标签:

>信息

\( i(x)=-log(p(x)) \)

事件x不确定性的度量,不确定性越大,信息量越大

>熵

\( H(X) = \sum_x{-p(x)log(p(x))} \)

随机变量X不确定的度量,信息的期望,不确定性越大,熵越大

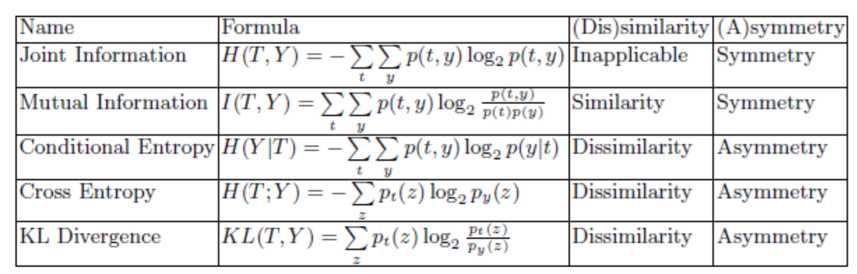

>条件熵

\( H(X|Y) \sum_{x,y}{-p(x,y)logp(x|y)}\)

>联合熵

\( H(X,Y) \sum_{x,y}{-p(x,y)logp(x,y)}\)

>互信息

描述事件x发生后,对事件y不确定性的消除

i(y,x) = i(y)-i(y|x) = log(p(y|x))/log(p(y)) = log(后验概率)/log(先验概率)

对称性:i(y,x)=i(x,y)

>平均互信息

\( I(X;Y)= \sum_{x,y}{p(x,y)i(x,y)}= \sum_{x,y}{p(x,y)log\frac{p(y|x)}{p(y)}}= \sum_{x,y}{p(x,y)log\frac{p(x,y)}{p(x)p(y)}} \)

= H(X)-H(X|Y) ----信息增益

= H(Y)-H(Y|X)

=H(X)+H(Y)-H(X,Y)

=H(X,Y)-H(X|Y)-H(Y|X)

>交叉熵

衡量两个分布的差异性

\(H(T|Y)=-\sum_{p_t(z)logp_y(z)}\)

>相对熵(KL散度)

衡量两个分布的差异性

\( KL(f(x)||g(x)) = \sum_x{f(x)log\frac{f(x)}{g(x)}} \)

总结:

标签:

原文地址:http://www.cnblogs.com/naniJser/p/5701142.html