标签:

在http://www.cnblogs.com/wuyushen/p/5764194.html遇到的问题,Centos6.5不能载入库的问题,看一下在CentOS 7.2 X64的系统下能否成功。

顺便简单写下安装方法。

一、增加用户,但是下面操作依旧是root用户

groupadd hadoop

useradd –g hadoop hadoop

passwd hadoop

二、修改为静态ip

#BOOTPROTO=dhcp

BOOTPROTO="static"

HOSTNAME=Master

GATEWAY=192.168.67.1

NETMASK=255.255.255.0

IPADDR=192.168.67.68

DNS1=180.76.76.76

DNS2=192.168.67.1

三、主机名,hosts

/etc/hostname

/etc/hosts

四、关闭防火墙

http://www.awaimai.com/762.html

启动:# systemctl start firewalld

查看状态:# systemctl status firewalld 或者 firewall-cmd --state

停止:# systemctl disable firewalld

禁用:# systemctl stop firewalld

五、visudo

增加 hadoop ALL(ALL) ALL

六、安装java

rpm -ivh jdk-8u101-linux-x64.rpm

安装java后位置 /usr/java/jdk1.8.0_101

环境配置: /etc/profile

export JAVA_HOME=/usr/java/jdk1.8.0_101

export JRE_HOME=/usr/java/jdk1.8.0_101/jre

export CLASSPATH=.:$JAVA_HOME/lib:$JAVA_HOME/jre/lib

export PATH=$PATH:$JAVA_HOME/bin:$JAVA_HOME/jre/bin

source /etc/profile

七、安装hadoop

.opt下

tar zxvf hadoop-2.6.4.tar.gz

mv hadoop-2.6.4 hadoop

chown -R hadoop:hadoop hadoop

八、hadoop环境变量 /etc/profile

export HADOOP_HOME=/opt/hadoop

export HADOOP_INSTALL=$HADOOP_HOME

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

#export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

下面配置hadoop,切换为hadoop用户

九、在 hadoop 安装目录中创建一个 tmp 目录,未来的查询都可以在这个目录下进行

十、配置hadoop

/opt/hadoop/etc/hadoop下

1、配置hadoop-env.sh

添加 export JAVA_HOME=/usr/java/jdk1.8.0_101

2、配置core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.67.68</value>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://192.168.67.68:9000</value>

</property>

</configuration>

3、配置hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

4、配置 mapred-site.xml

hadoop 2.6 不需要配置这个文件???

十一、克隆虚拟机备用

十二、配置ssh

(1)CentOS默认没有启动ssh无密登录,去掉/etc/ssh/sshd_config其中2行的注释,每台服务器都要设置,

#RSAAuthentication yes

#PubkeyAuthentication yes

(2)Master上生成密码对

ssh-keygen -t rsa

在目录/home/hadoop/.ssh下,

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

(3)设置SSH配置

用root用户登录服务器修改SSH配置文件"/etc/ssh/sshd_config"的下列内容。

RSAAuthentication yes # 启用 RSA 认证

PubkeyAuthentication yes # 启用公钥私钥配对认证方式

AuthorizedKeysFile .ssh/authorized_keys # 公钥文件路径(和上面生成的文件同)

设置完之后记得重启SSH服务,才能使刚才设置有效。

退出root登录,使用hadoop普通用户验证是否成功。

十三、Masters配置

修改 /usr/hadoop/etc/hadoop/masters 文件,默认如果没有那么就得新建一个,在里面加上一行:

192.168.67.68 或者名称也可以 Master

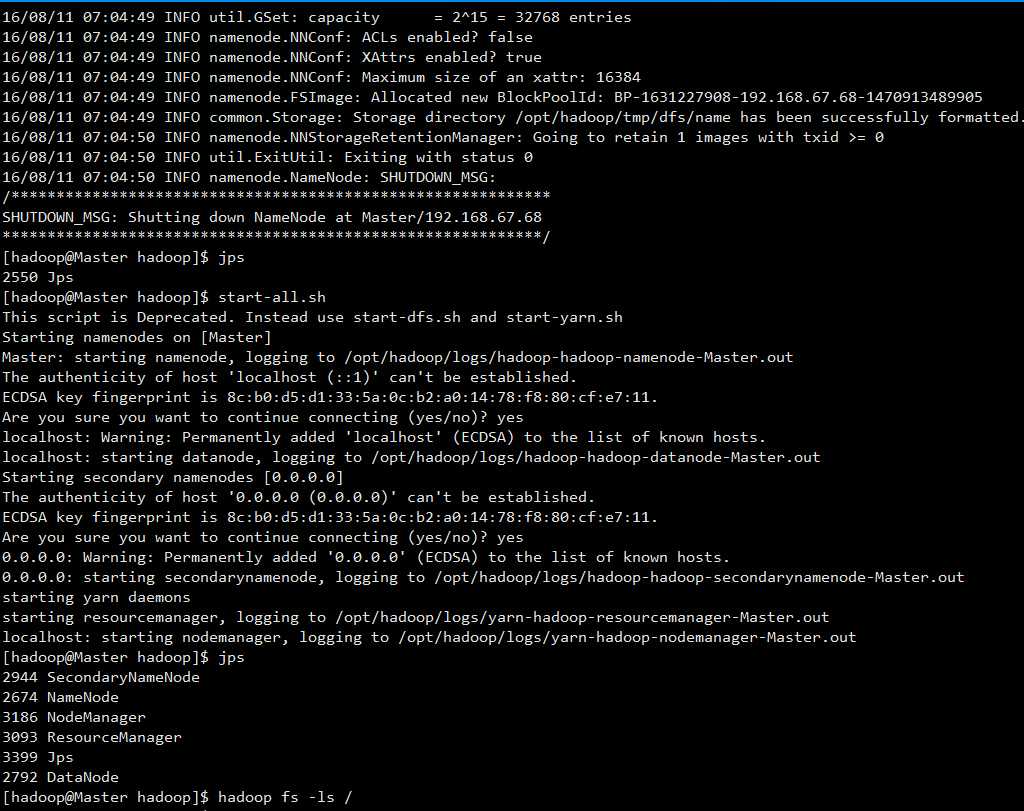

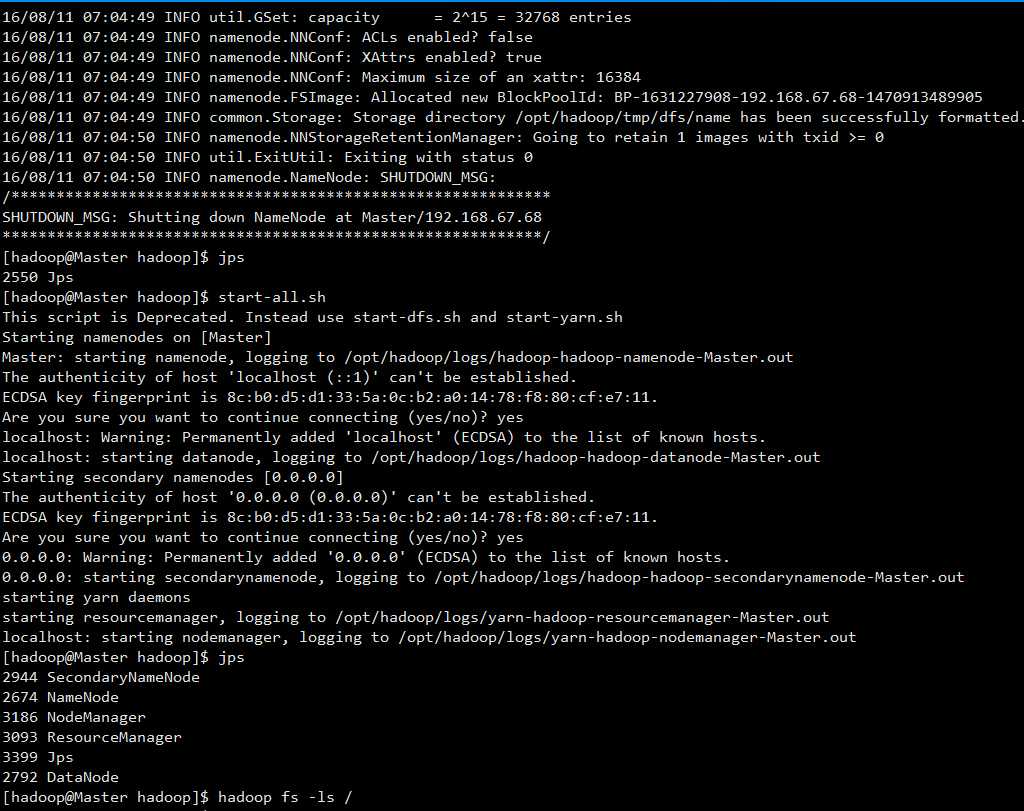

十四、伪分布式启动

hadoop namenode -format

启动成功了,但是在启动 namenode的时候,配置文件一有点问题

应该是slaves, masters文件,hosts配置,还有ssh有点问题。

但是不影响伪分布式运行,在扩展成分布式的时候,可以把这个问题解决。

十五、分布式

1、克隆虚拟机

修改为静态ip

修改/etc/hostname

2、修改master主机,所有slaves主机的hosts

3、配置SSH

在master下,hadoop用户

发现点疑惑,重新制作ssh免密码登陆

参考http://f.dataguru.cn/thread-538083-1-1.html 该贴有详细介绍

______________________________

Master免密码登陆所有Slaves

ssh-keygen -t rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 600 ~/.ssh/authorized_keys

scp ~/.ssh/id_rsa.pub hadoop@Slave1:~/

切换到Slave1窗口(id_rsa.pub已经复制到slave1的/hone/hadoop下)

/home/hadoop下

mkdir ~/.ssh

chmod 700 ~/.ssh

cat ~/id_rsa.pub >> ~/.ssh/authorized_keys

设置Slave1 的设置SSH配置

chmod 600 ~/.ssh/authorized_keys

vi /etc/ssh/sshd_config

RSAAuthentication yes # 启用 RSA 认证

PubkeyAuthentication yes # 启用公钥私钥配对认证方式

AuthorizedKeysFile .ssh/authorized_keys # 公钥文件路径(和上面生成的文件同)

设置完之后记得重启SSH服务,才能使刚才设置有效。

service sshd restart

在~/ 把该文件删掉

rm –r ~/id_rsa.pub

——————————————————————————————————

Slave免密码登陆Master,在Slave1操作

ssh-keygen -t rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

scp ~/.ssh/id_rsa.pub hadoop@Master:~/

切换到Master

cat ~/id_rsa.pub >> ~/.ssh/authorized_keys

然后删除掉刚才复制过来的"id_rsa.pub"文件

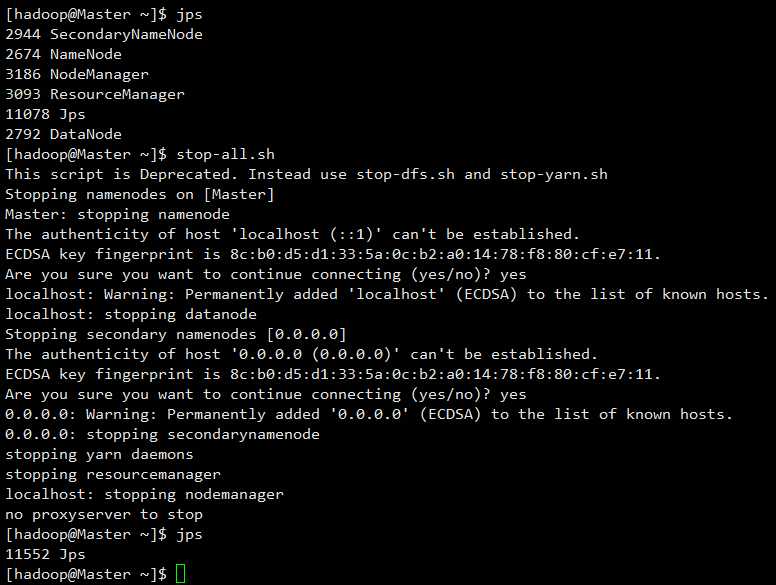

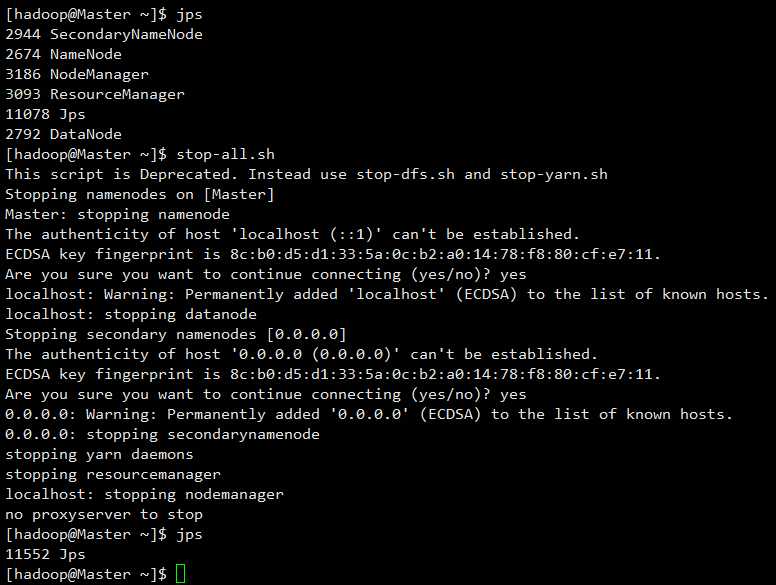

4、先停止正在运行的伪分布式集群

5、在Master节点配置Masters ,Slaves等

slaves、core-site.xml、hdfs-site.xml、mapred-site.xml、yarn-site.xml

把配置文件复制到其他点

scp ./etc/hadoop/* Slave3:/opt/hadoop/etc/hadoop

6、格式化,启动集群

hdfs namenode -format

7、动态添加节点

参考我之前写的博客

http://www.cnblogs.com/wuyushen/p/5764194.html

CentOS7.2 Hadoop2.6.4 安装

标签:

原文地址:http://www.cnblogs.com/wuyushen/p/5764487.html