标签:

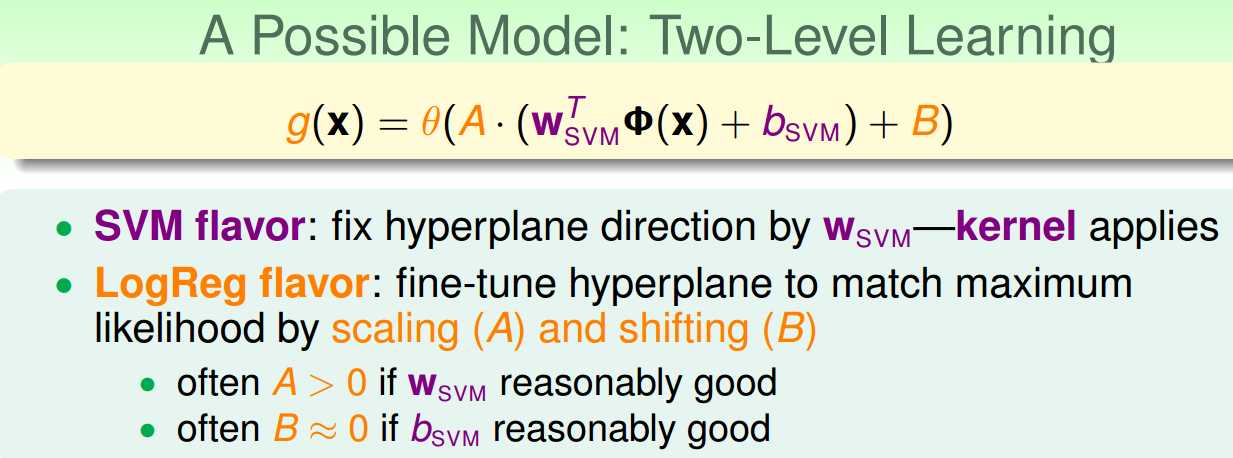

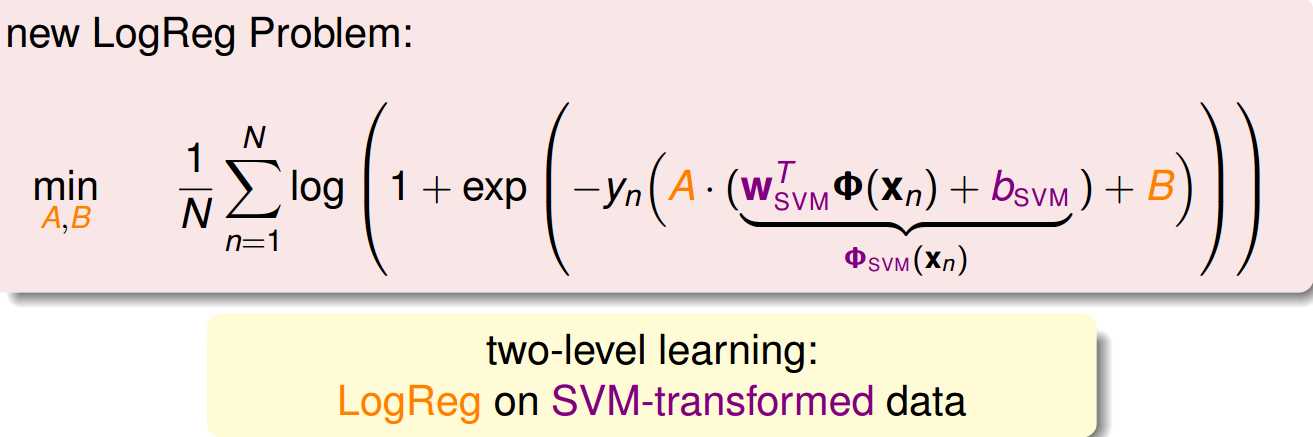

所以,这里我们通过一种两个步骤的训练方式把SVM方法和Logistic Regression结合起来,第一步我们还是通过SVM求解得到Wsvm和bsvm,然后我们把得到的w和b,用上面的方法进行Logistic Regression的训练, 通过A和B这两个参数进行放缩和平移,最终得到的结果如果A>0的话,那么Wsvm就是好的,B接近0的话, bsvm也是可靠的.

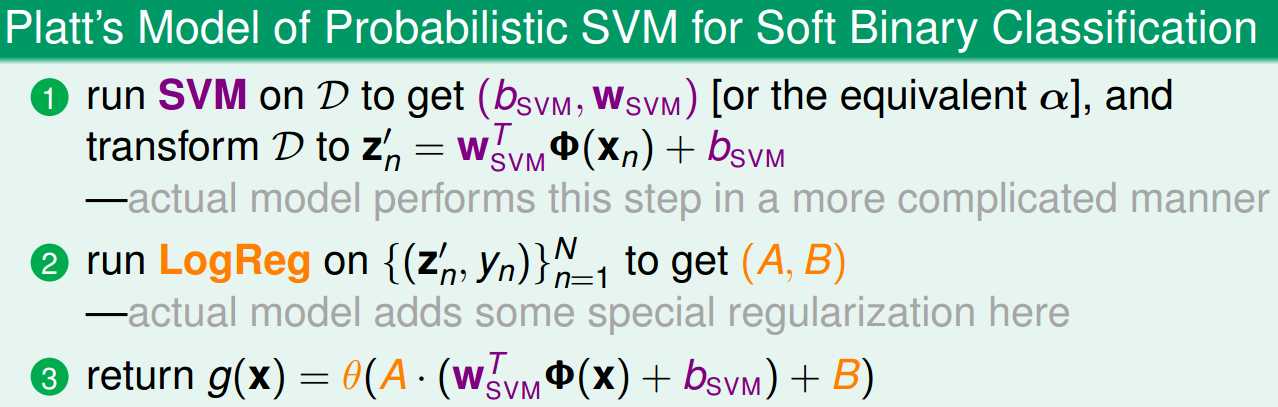

这里我们把Platt’s Model的步骤概括成为以下的步骤:

因为有B的存在,所以有一定的平移的效果,所以soft binary classifier跟SVM的边界有一定的差异,然后对于解第二步Logistic Regression的话就可以采用GD/SGD等求解Local Minimum的方法.

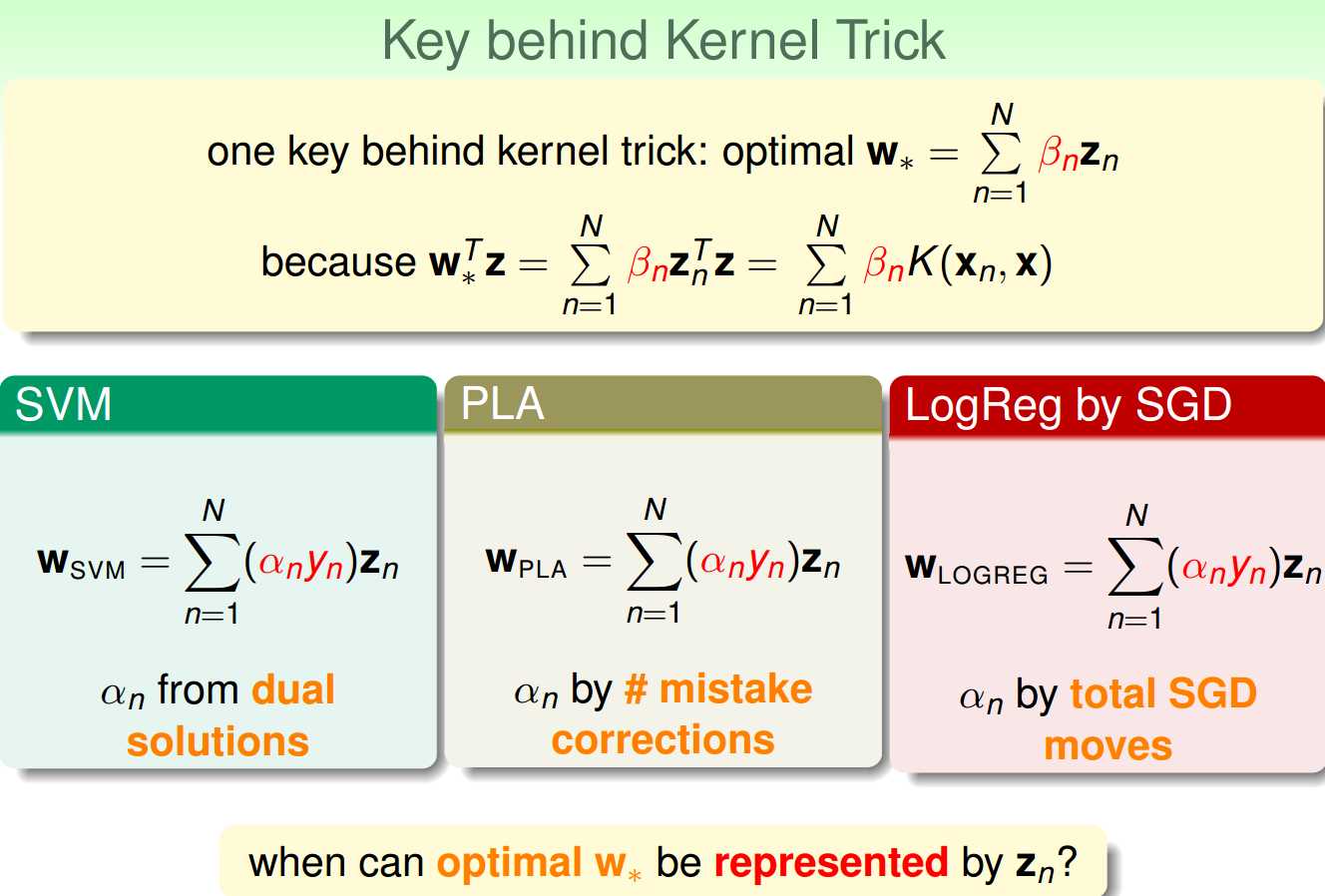

Kernel方法的重要概念就是最后得到的最优的w是zn的线性组合.这一点对于SVM, PLA, LogReg都是一样的.

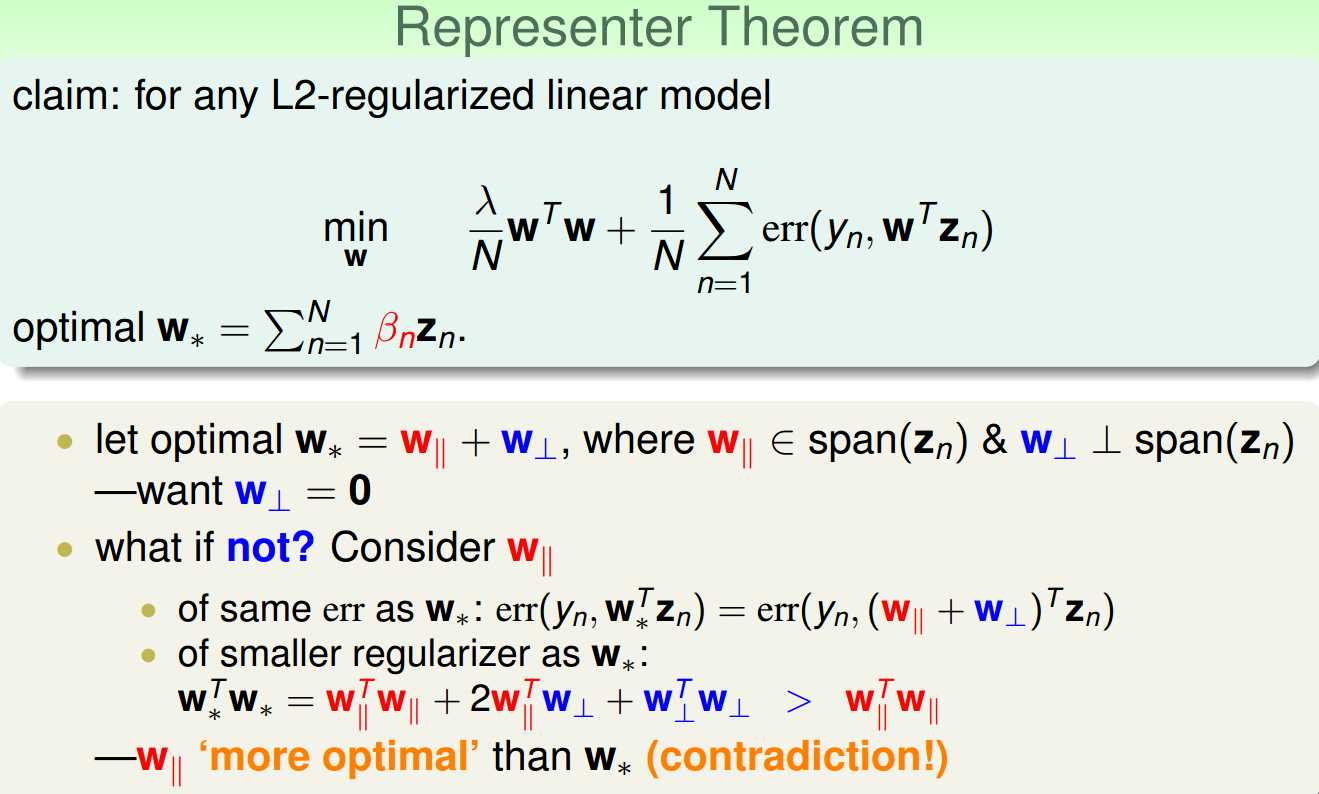

上图证明了对于任何一个L2-Regularized的模型,最优解w都可以表示成为zn的线性组合.证明方式是反证法.

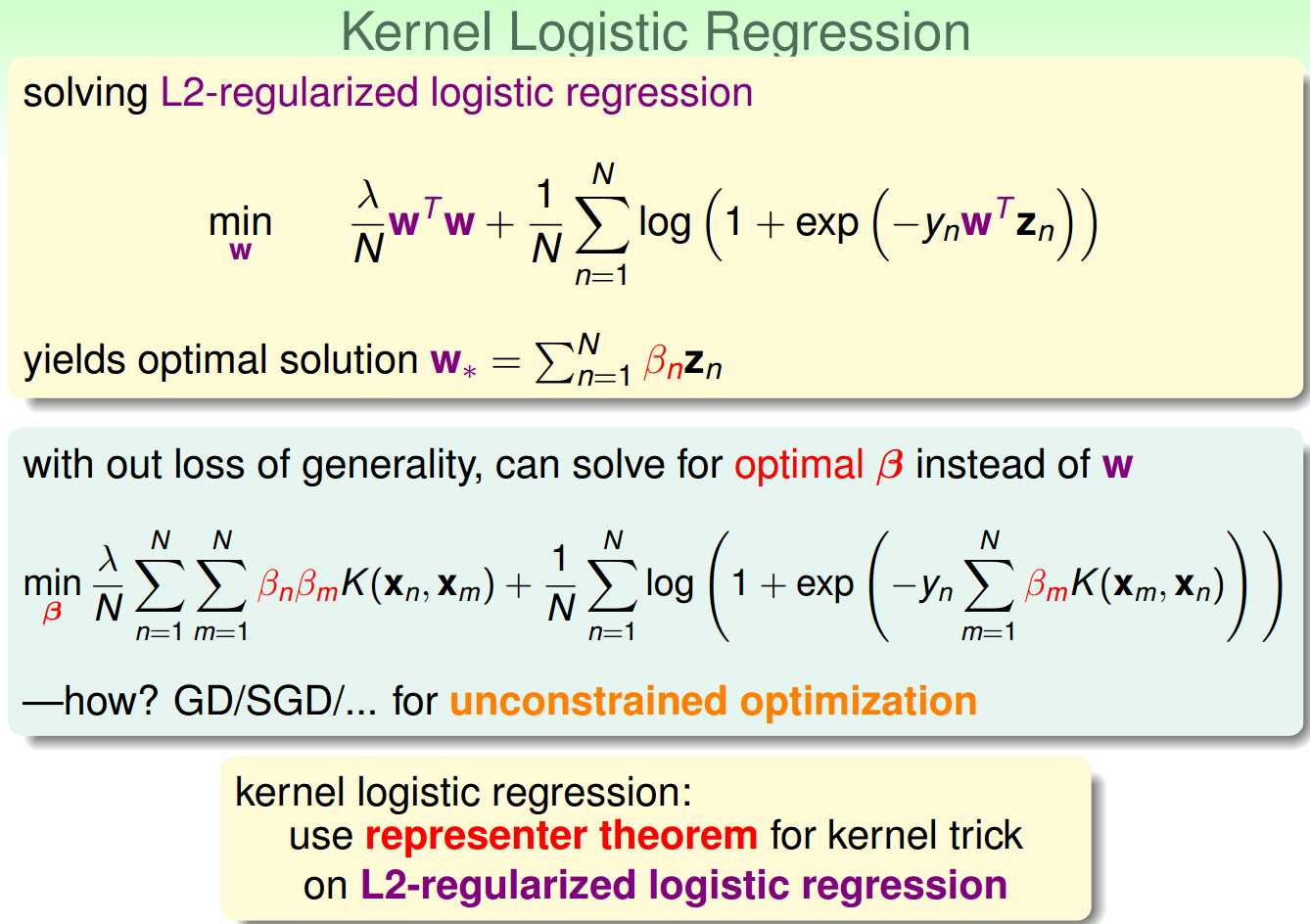

所以把Representer Theorem应用到Kernel Logistic Regression上去的话就可以用GD/SGD做优化求解了.

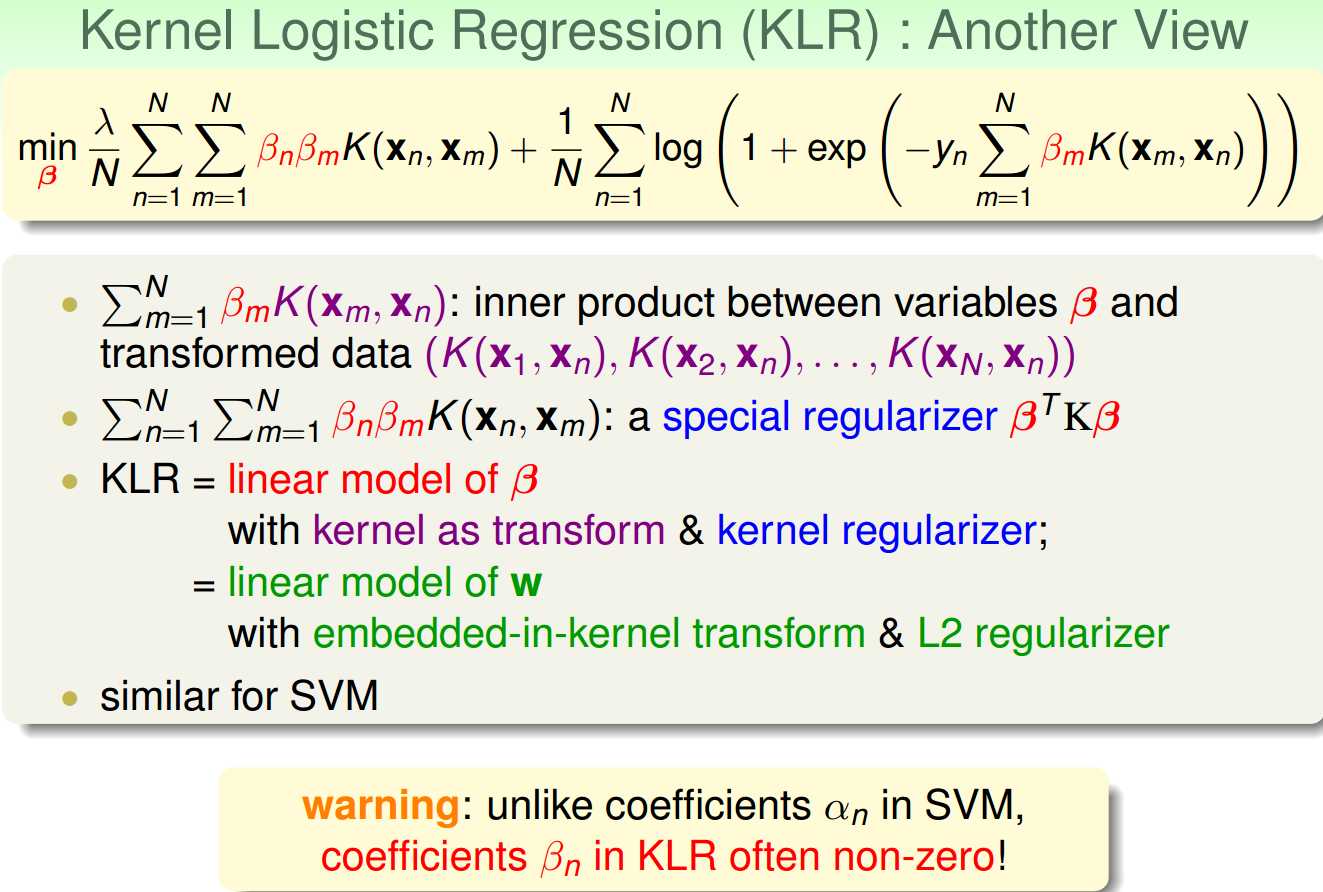

从另一个角度看过去,KLR这个式子是beta的线性组合,系数就是K(xn,xm),但是这里要注意到,beta在KLR中基本都是有值的,不像SVM,只有是SV的时候,an才会不等于0

标签:

原文地址:http://www.cnblogs.com/enzyme/p/5764811.html