标签:配置 解释 ble 6.2 检索 应该 hadoop 第三方库 第三方

jetbrains系列的IDE真的是太好用了,有种相见恨晚的感觉。

在开发过程中第三方库是必不可少的,在开发的时候如果有一个可以补全的IDE可以节省查文档的时间。

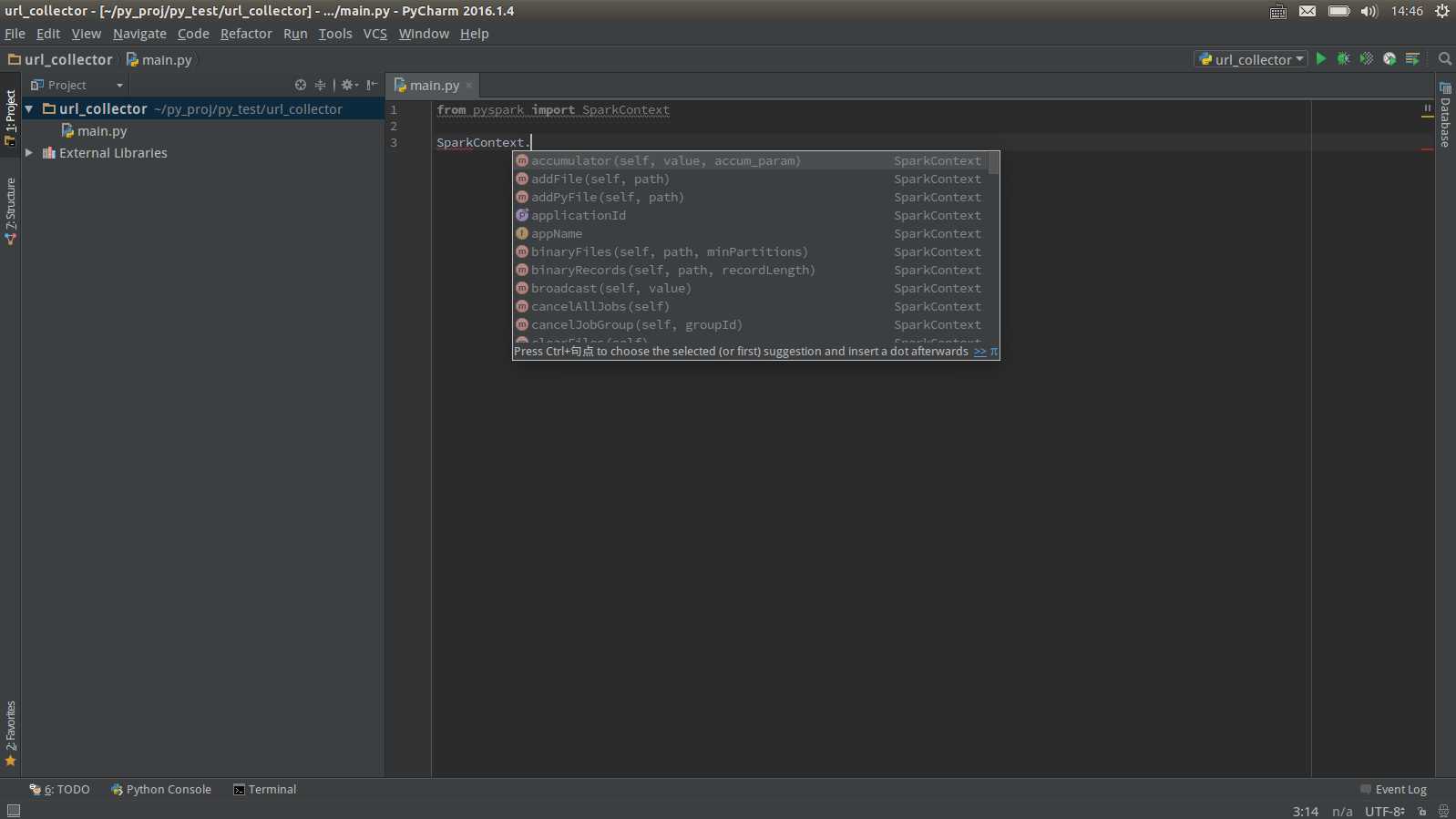

举个例子:给pycharm配pyspark的环境变量,并且设置代码补全。最终结果应该是这样的:

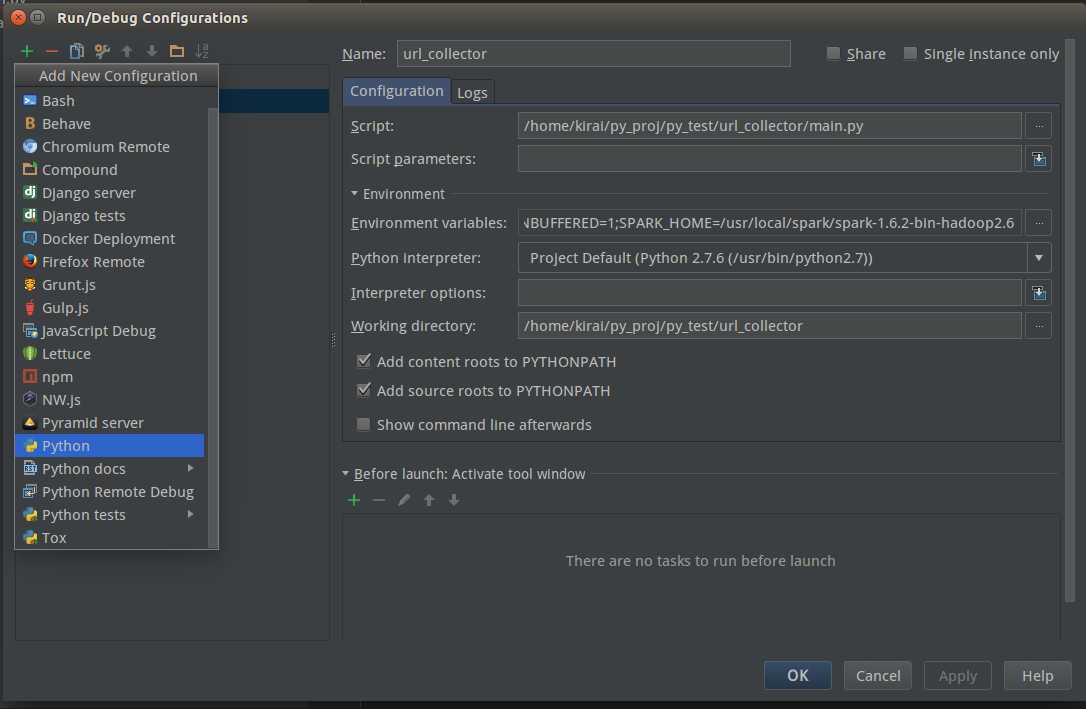

首先配置的是第三方库的编译(解释)支持,在Run/Edit Configurations里。点+号添加一个新的配置。

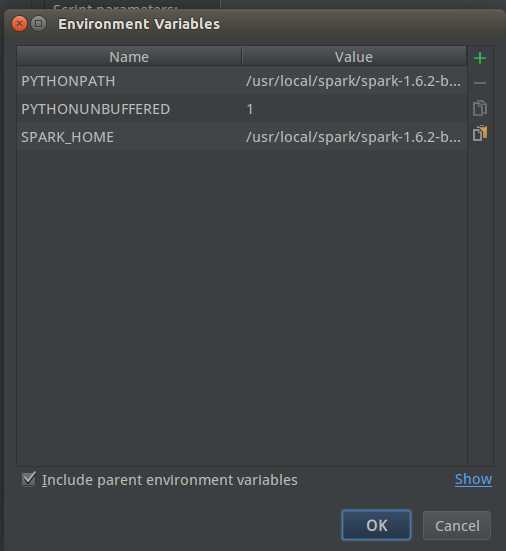

在Configuration选项卡里找到Environment中的Environment variables,如下编辑:

PYTHONPATH是pyspark的目录,例如:/usr/local/spark/spark-1.6.2-bin-hadoop2.6/python

SPARK_HOME是spark的目录,例如:/usr/local/spark/spark-1.6.2-bin-hadoop2.6

一路ok,保存就可以了。这个时候你写的spark程序实际上已经可以解释(编译)运行了,但是还没有代码补全。接下来设置代码补全。

pycharm会在你选择的对应版本的python解释器的dist-package和site-package目录下去找你的第三方库,然后分析里面的目录,做出的代码补全。

接下来就是找到这个dist目录,可以用locate来做:

1 locate /lib/python2.7/site-packages

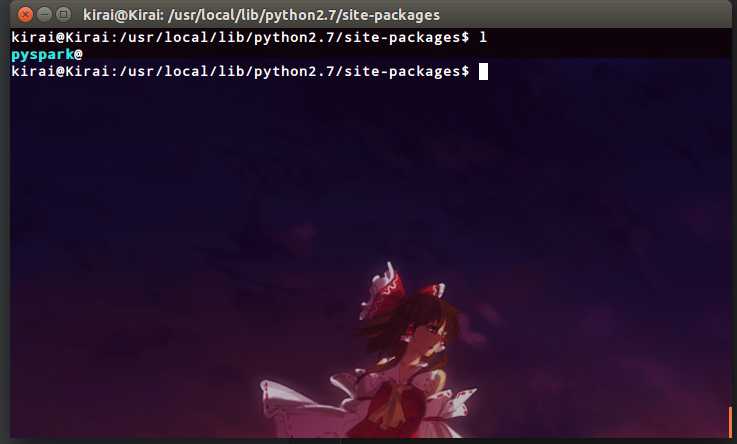

内容很多的,直接ctrl+c停掉就行了。然后实际上就找到了这个目录,例如我的是在:/usr/local/lib/python2.7/site-packages/

接下来直接做一个软链接,指向pyspark的目录,保存在python2.7/site-packages中就行了。

1 ln -s /usr/local/spark/spark-1.6.2-bin-hadoop2.6/python/pyspark/ /usr/local/lib/python2.7/site-packages/

切回pycharm,会发现pycharm在检索这些更新的目录,等检索完后就可以自动补全了。

标签:配置 解释 ble 6.2 检索 应该 hadoop 第三方库 第三方

原文地址:http://www.cnblogs.com/kirai/p/6170012.html