标签:cbo model -- 错误 ror 机器 分类 函数 src

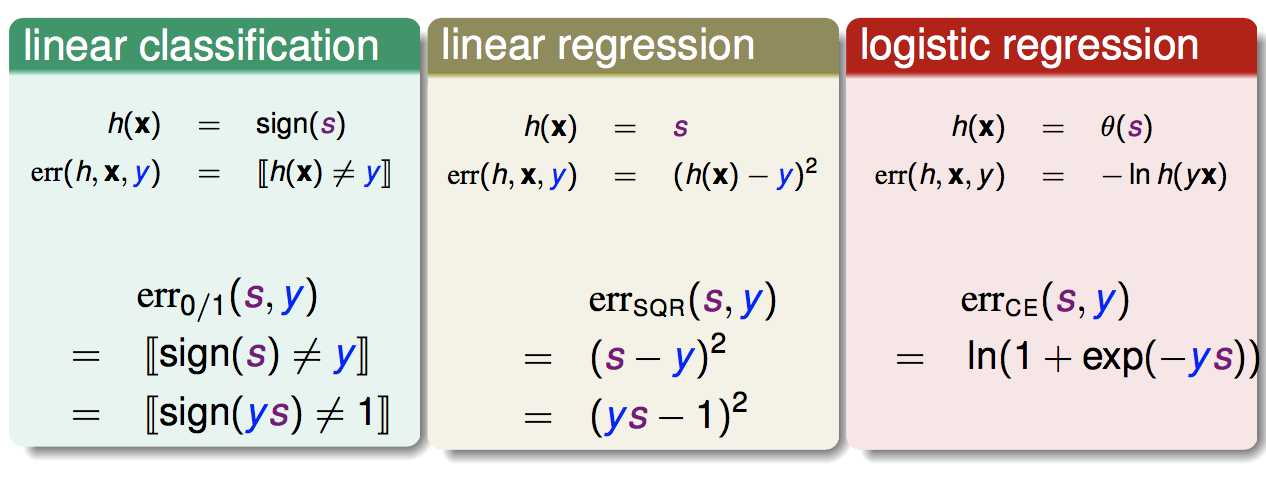

到目前为止,我们学习了线性分类,线性回归,逻辑回归这三种模型。以下是它们的pointwise损失函数对比(为了更容易对比,都把它们写作s和y的函数,s是wTx,表示线性打分的分数):

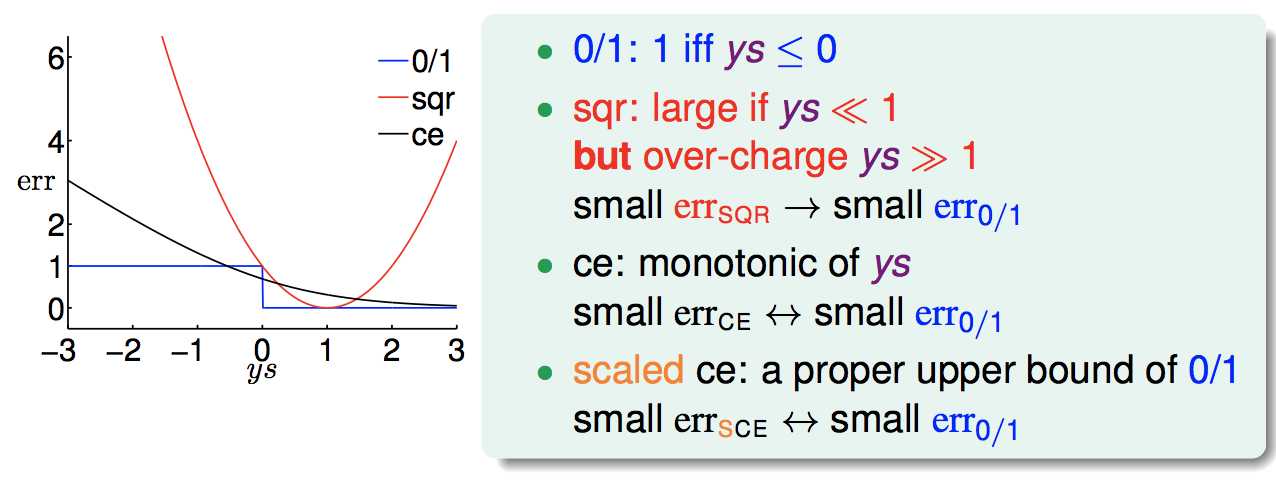

把这几个损失函数画在一张图上:

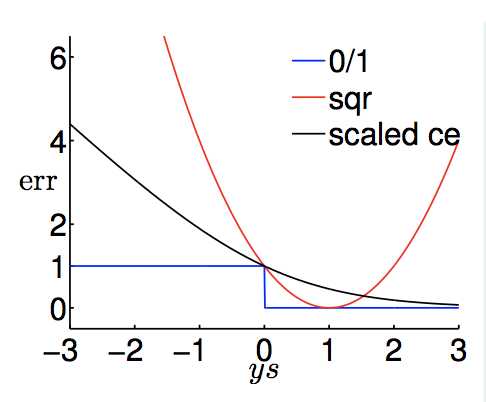

如果把逻辑回归的损失函数ce做一个适当的放缩,则可以得到下图:

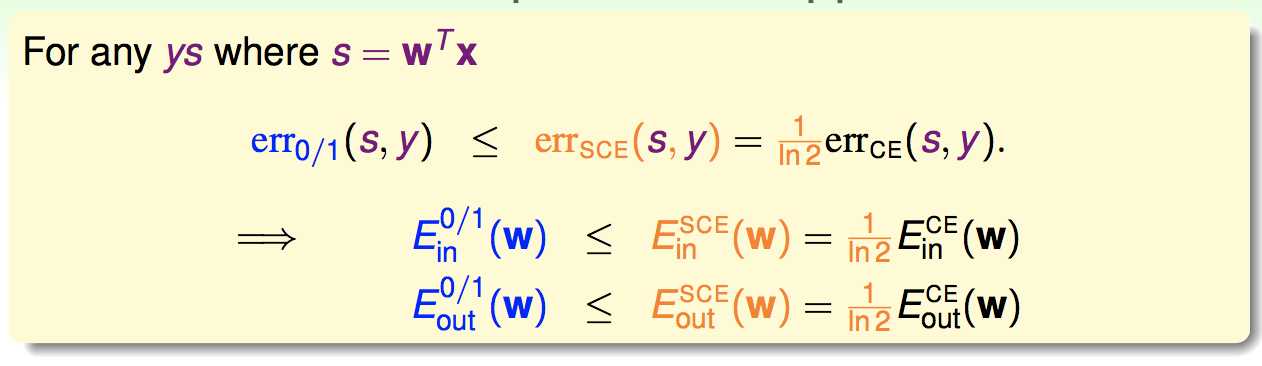

可以看出,平方误差和放缩后的交叉熵误差是0/1误差的上限,这里以放缩后的ce举例,由于对于每个点的error均成立不等式,则不论是对于Ein还是Eout仍然有不等式成立,因为它们是数据集上每个点error的期望:

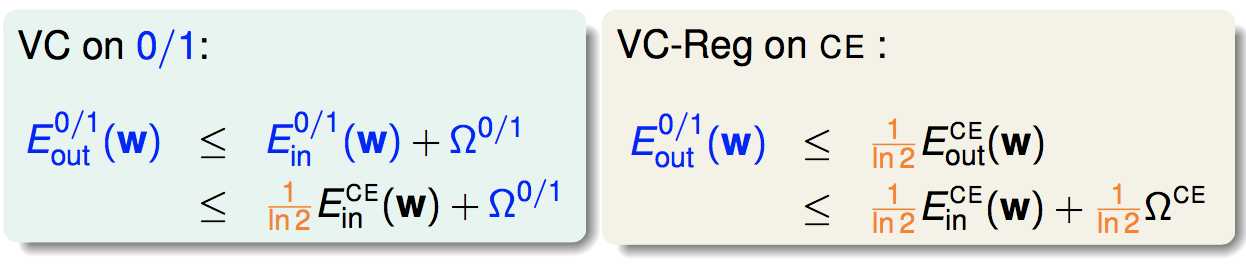

应用到VCbound,就有:

可以看出,只要把训练集上的交叉熵误差做到低,则就能保证真实的0/1错误也比较低。

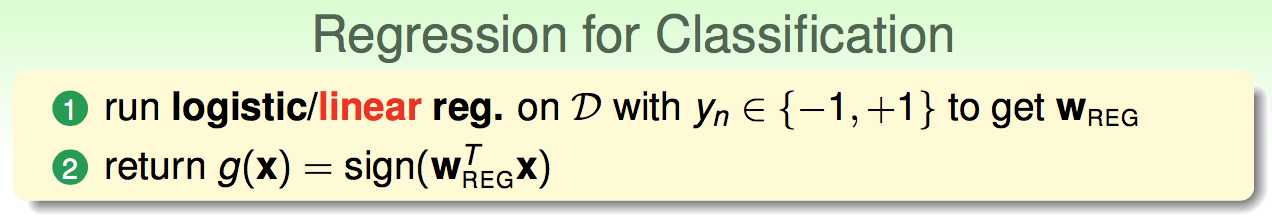

因此线性回归和逻辑回归都可以用来做分类:

正如之前在《噪声与错误》一节中所说,我们这里用平方错误或交叉熵错误来代替01错误,作为errhat。

通常,我们会使用线性回归的结果作为逻辑回归,PLA,pocket算法的初始值。

《机器学习基石》---Linear Models for Classification

标签:cbo model -- 错误 ror 机器 分类 函数 src

原文地址:http://www.cnblogs.com/coldyan/p/6337586.html