标签:amp 上传 blog bin 体验 apach href row 方便

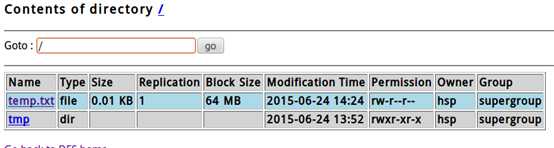

./hadoop fs -put temp.txt hdfs://localhost:8888/

说明:

检测是否成功上传:

然后点击browse the filesystem

可以看到:

任务说明: 使用Hadoop自动的一个案例,来统计多个文件的的各个单词出现的次数。

步骤如下:

2.1先创建一个目录

./hadoop fs -mkdir /task1 【如果要看 hadoop有哪些指令,可以 ./hadoop 如果要看 还可以通过 ./hadoop fs 来看分项的命令】

./hadoop fs -put /home/hsp/test/*.* /task1

./bin/hadoop jar hadoop-examples-1.0.3.jar wordcount /task1 /result1

说明:这个指令一定要在 hadoop的bin目录下执行,因为 hadoop-examples-1.0.3.jar 是在hadoop/bin 目录下的.

结果:

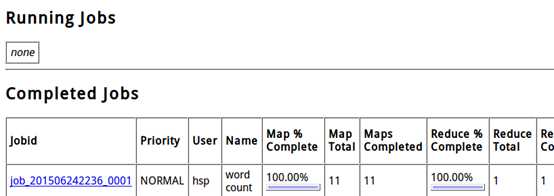

http://localhost:50030 , [这个就是MapReduce的管理界面]可以看到MapReduce 任务的完成情况

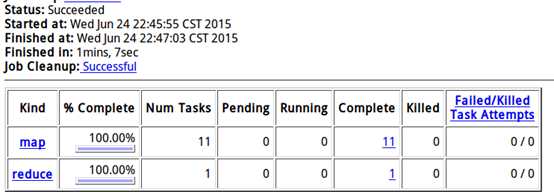

点击job_201506...可以看到详细情况,如下:

说明: 这个任务被Map了11个,有一个reduce操作。

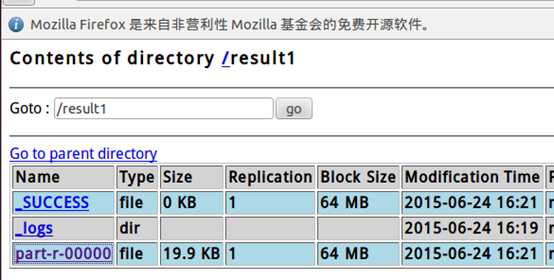

http://localhost:50070 ,点击 part-r-00000 ,就可以看到结果

both 是5次,我们在ubuntu 直接统计一下

grep both /home/hsp/test/*.* 可以看到一个5个

grep both /home/hsp/test/*.*|wc 也可以直接得到结果.

标签:amp 上传 blog bin 体验 apach href row 方便

原文地址:http://www.cnblogs.com/lovebing/p/6404598.html