标签:产生 logs ack 其他 redirect 决策树 比例 ima src

一下内容转载自:https://zh.wikipedia.org/wiki/ROC%E6%9B%B2%E7%BA%BF

ROC(Receiver Operating Characteristic)曲线和AUC常被用来评价一个二值分类器(binary classifier)的优劣。

1) ROC曲线

在信号检测理论中,接收者操作特征曲线(receiver operating characteristic curve,或者叫ROC曲线)是一种坐标图式的分析工具,用于 (1) 选择最佳的信号侦测模型、舍弃次佳的模型。 (2) 在同一模型中设定最佳阈值。

在做决策时,ROC分析能不受成本/效益的影响,给出客观中立的建议。在机器学习的可能就是不受训练数据的影响,可以直接评价该模型的的性能。

分类模型(又称分类器,或诊断)是将一个实例映射到一个特定类的过程。ROC分析的是二元分类模型,也就是输出结果只有两种类别的模型,例如:(阳性/阴性)(有病/没病)(垃圾邮件/非垃圾邮件)(敌军/非敌军)。当分类的的对象是一个连续值时必须要使用阈值进行分隔,分隔点就叫做分隔门限。

二元分类有四种结果(以高血压预测为例):

在上面的四种分类结果中T表示true也就是表示预测的结果是正确的,false则表示预测的结果是错误的;postive则表示训练数据的真实分类为正的,negtive表示训练数据的真实分类为负。对以上的结果可以使用一个2*2的矩阵进行描述:

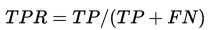

从上面的二维矩阵中可以引出一下几个指标:这些东西的起名都是预测的类别相对与真实的样本之间称呼。

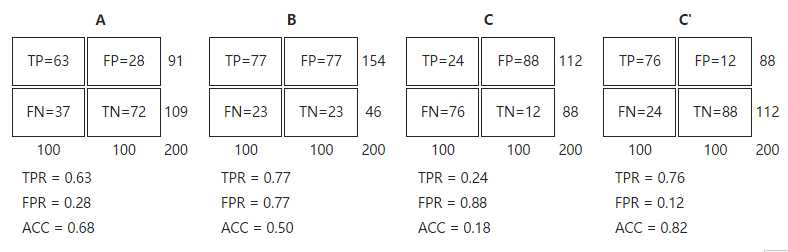

2) ROC空间

ROC空间将伪阳性率(FPR)定义为 X 轴,真阳性率(TPR)定义为 Y 轴。就能从所有样本的(阳性/阴性)真实值和预测值计算出一个 (X=FPR, Y=TPR) 座标点。从 (0, 0) 到 (1,1) 的对角线将ROC空间划分为左上/右下两个区域,在这条线的以上的点代表了一个好的分类结果(胜过随机分类),而在这条线以下的点代表了差的分类结果(劣于随机分类)。

完美的预测是一个在左上角的点,在ROC空间座标 (0,1)点,X=0 代表着没有伪阳性,Y=1 代表着没有伪阴性(所有的阳性都是真阳性);也就是说,不管分类器输出结果是阳性或阴性,都是100%正确。一个随机的预测会得到位于从 (0, 0) 到 (1, 1) 对角线(也叫无识别率线)上的一个点;最直观的随机预测的例子就是抛硬币。

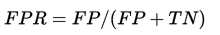

让我们来看在实际有100个阳性和100个阴性的案例时,四种预测方法(可能是四种分类器,或是同一分类器的四种阈值设定)的结果差异:

对以上的四个例子进行分析:

3) ROC曲线

上面的ROC空间中的单点是在给定模型并且给定阈值的情况下得出的点,但是对于同一模型来说可能会有很多的阈值,那么将同一模型的所有阈值产生的点放到ROC空间中形成的曲线就是ROC曲线。

比较不同分类器时,ROC曲线的实际形状,便视两个实际分布的重叠范围而定,没有规律可循。

在同一个分类器之内,阈值的不同设定对ROC曲线的影响,仍有一些规律可循:

4) AUC曲线下面积

在比较不同的分类模型时,可以将每个模型的ROC曲线都画出来,比较曲线下面积做为模型优劣的指标。

意义[编辑]

ROC曲线下方的面积(英语:Area under the Curve of ROC (AUC ROC)),其意义是:

因为是在1x1的方格里求面积,AUC必在0~1之间。

假设阈值以上是阳性,以下是阴性;

若随机抽取一个阳性样本和一个阴性样本,分类器正确判断阳性样本的值高于阴性样本之概率

简单说:AUC值越大的分类器,正确率越高。

从AUC判断分类器(预测模型)优劣的标准:

计算

采用梯形法,将每个点与点之间使用直线相连,形成一个个的梯度,这样直接计算这些梯度的面积进行求和。

离散分类器(英语:discrete,或称“间断分类器”),如决策树,产生的是离散的数值或者一个二元标签。应用到实例中,这样的分类器最后只会在ROC空间产生单一的点。而一些其他的分类器,如朴素贝叶斯分类器,逻辑回归或者人工神经网络,产生的是实例属于某一类的可能性,对于这些方法,一个阈值就决定了ROC空间中点的位置。举例来说,如果可能值低于或者等于0.8这个阈值就将其认为是阳性的类,而其他的值被认为是阴性类。这样就可以通过画每一个阈值的ROC点来生成一个生成一条曲线。

对于分类器只有阈值可调时才能产生ROC曲线否则只是ROC空间的一个单点。

标签:产生 logs ack 其他 redirect 决策树 比例 ima src

原文地址:http://www.cnblogs.com/daguankele/p/6528307.html