标签:保存 ant ges idt zed note site 成功 语句

1.安装和配置JDK

2.创建Hadoop用户

为Hadoop创建一个专门的用户,可以在系统安装的时候就创建,也可以在系统安装好之后用如下命令创建:

# groupadd hadoop-user

# useradd -g hadoop-user hadoop

# passwd hadoop

3.下载安装Hadoop

4.配置SSH

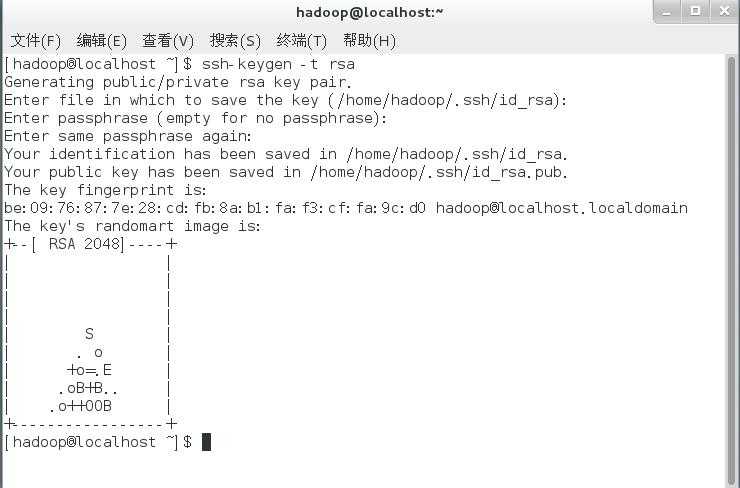

(1)生成密钥对时,执行如下命名

# ssh-keygen -t rsa

(2)然后一直按<enter>键,按照默认的选项将生成的密钥对保存在.ssh/id_rsa文件中,如图所示

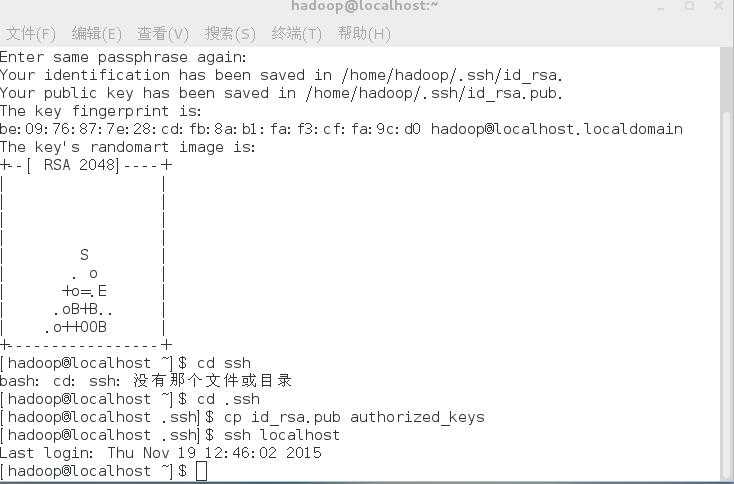

(3)进入.ssh目录,执行如下命令:

# cp id_rsa.pub authorized_keys

(4)此后执行如下命令:

# ssh localhost

(5)测试一下能否登录,是否可实现用SSH连接并且不需要输入密码

5.配置Hadoop环境

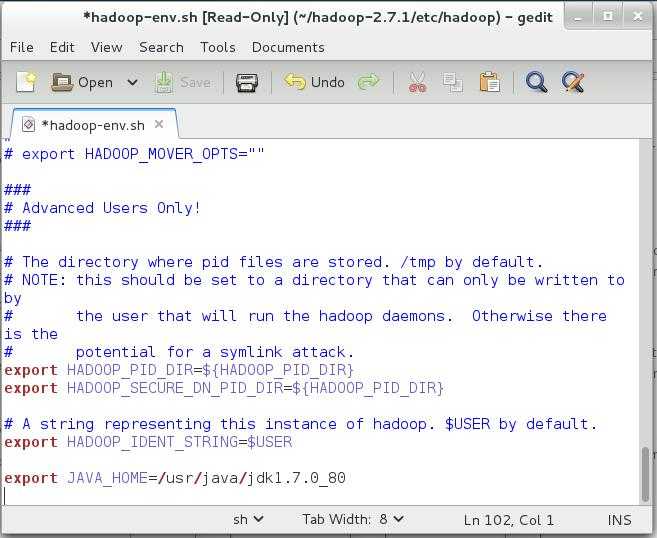

(1)找到hadoop-2.7.1的etc文件夹下的 hadoop-env.sh文件用文本编辑器打开,添加如下语句

export JAVA_HOME=/usr/java/jdk1.7.0_80

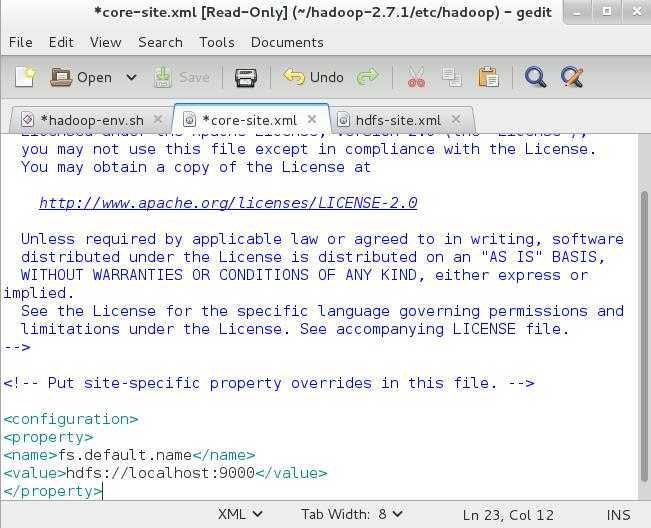

(2)找到hadoop-2.7.1的etc文件夹下的core-site.xml文件用文本编辑器打开,添加如下语句

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

这是hadoop核心的配置文件,这里配置的是HDFS的地址和端口号。

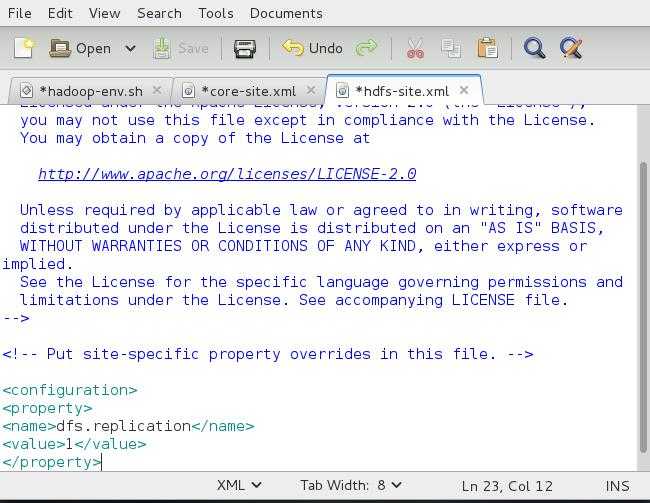

(3)找到hadoop-2.7.1的etc文件夹下的hdfs-site.xml文件用文本编辑器打开,添加如下语句

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

这是Hadoop中的HDFS的配置,配置的备份方式默认为3,在单机版的Hadoop中,需要将其改为1.

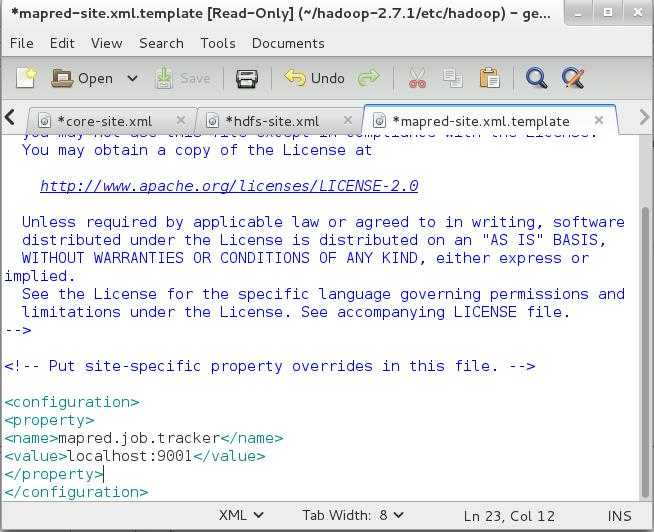

(4)找到hadoop-2.7.1的etc文件夹下的mapred-site.xml文件用文本编辑器打开,添加如下语句

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

这是Hadoop中MapReduce的配置文件,配置的是JobTracker的地址和端口。

(5)hadoop-env.sh yarn-env.sh中添加

export JAVA_HOME=/usr/java/jdk1.7.0_80

6.Hadoop的运行

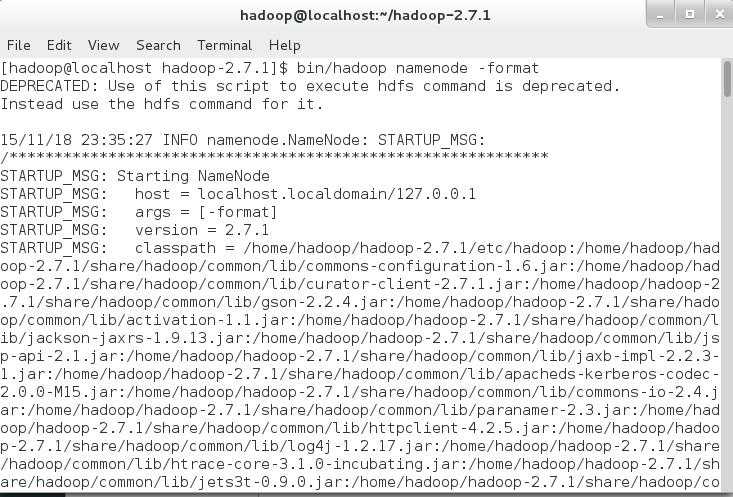

(1)格式化HDFS文件系统

在初次安装和使用Hadoop之前,需要格式化分布式文件系统HDFS。使用如下命令:

# bin/hadoop namenode -format

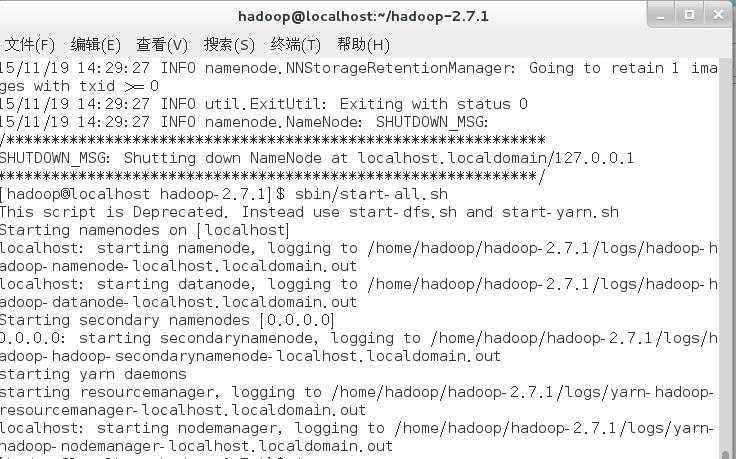

(2)启动Hadoop环境

启动Hadoop守护进程,命令如下

# bin/start-all.sh

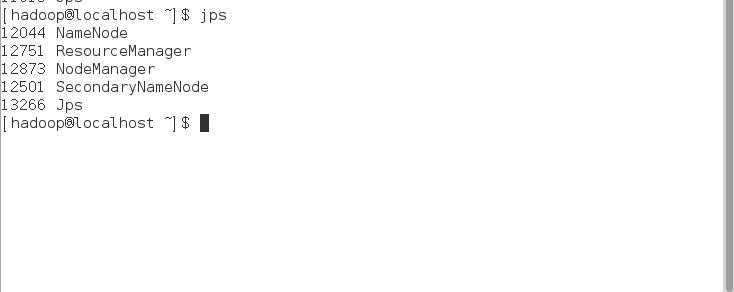

可以用jps指令查看已经启动的服务

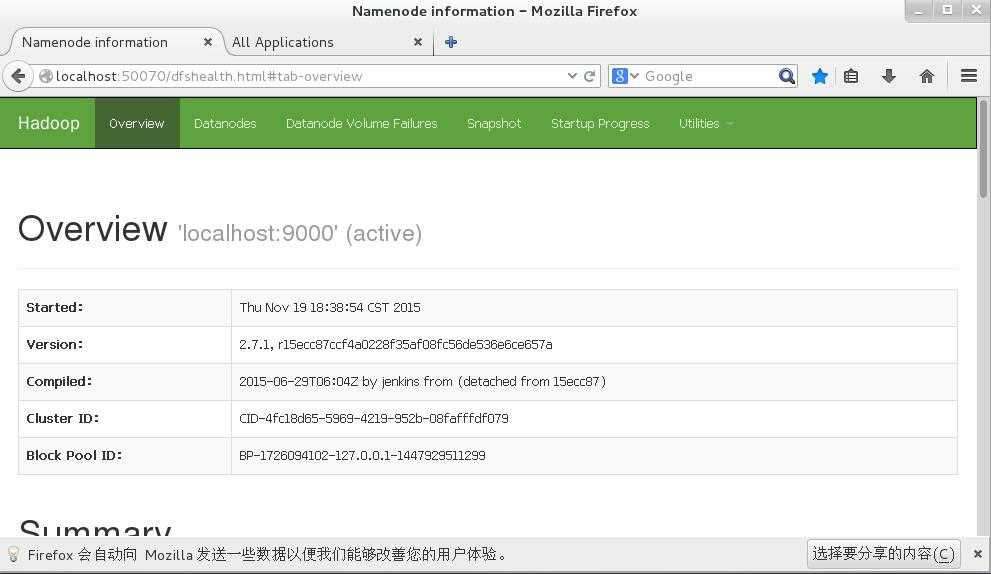

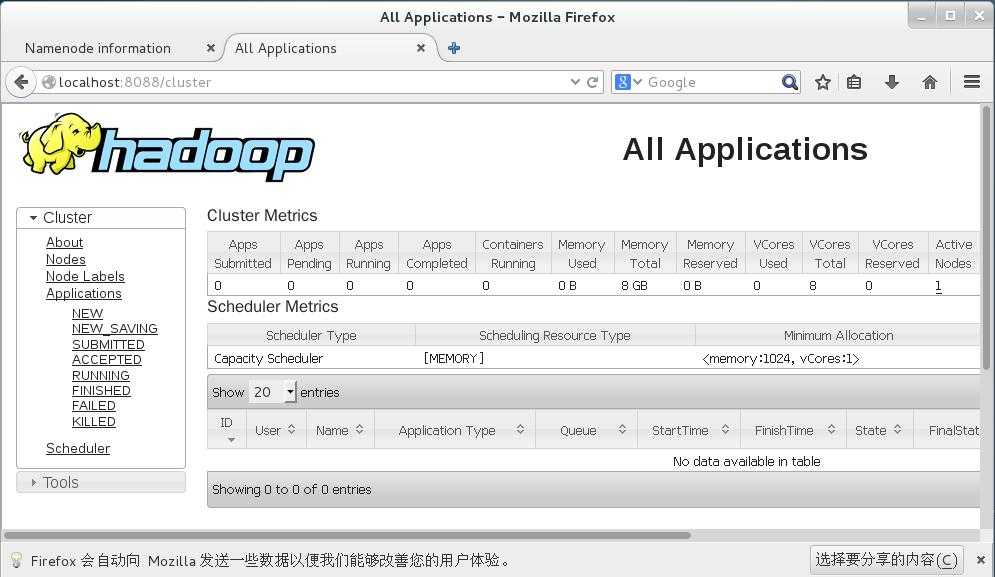

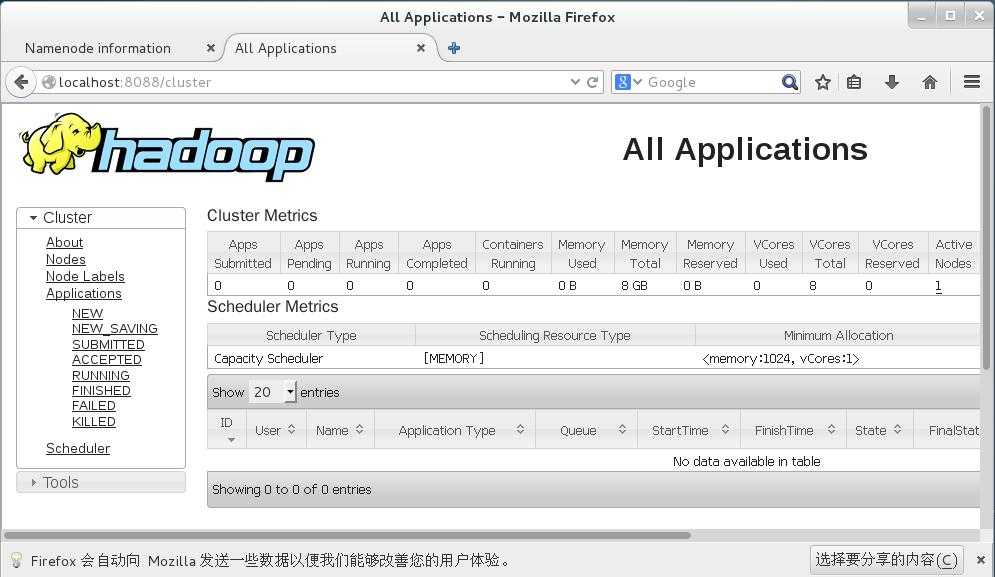

最后验证hadoop是否安装成功,用浏览器输入:

(3)停止Hadoop守护进程

# bin/stop-all.sh

单机伪分布式Hadoop环境搭建

标签:保存 ant ges idt zed note site 成功 语句

原文地址:http://www.cnblogs.com/DreamDriver/p/6597020.html