标签:space 分类 估计 公开课 line load for 训练 article

北京理工大学计算机专业2016级硕士在读,方向:Machine Learning,NLP,DM1.生成学习算法(Generative learning algorithm)

2.高斯判别分析(GDA,Gaussian Discriminant Analysis)

3.朴素贝叶斯(Naive Bayes)

4.拉普拉斯平滑(Laplace smoothing)

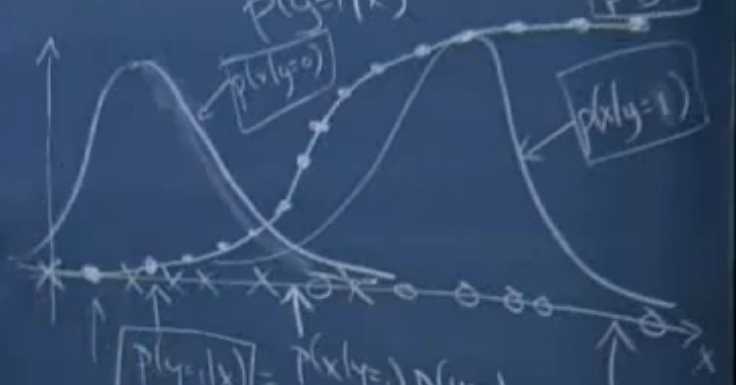

判别学习算法(discriminative learning algorithm):直接学习p(y|x)(比如说logistic回归)或者说是从输入直接映射到{0,1}.

生成学习算法(generative learning algorithm):对p(x|y)和p(y)进行建模。(p(y)不是很重要)

比如说良性肿瘤和恶性肿瘤的问题,对良性肿瘤建立model1(y=0),对恶性肿瘤建立model2(y=1),p(x|y=0)表示是良性肿瘤的概率,p(x|y=1)表示是恶性肿瘤的概率.

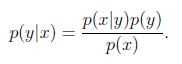

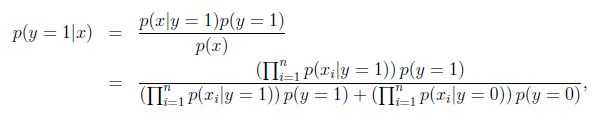

根据贝叶斯公式(Bayes rule)推导出y在给定x的概率为:

GDA是要学习的第一个生成学习算法.

GDA的两个假设:

,协方差矩阵(convariance matrix)

,协方差矩阵(convariance matrix) ,写成x~

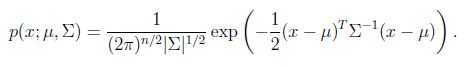

,写成x~ , 其概率密度函数为:

, 其概率密度函数为:

表示行列式(determinant).

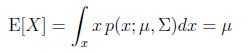

表示行列式(determinant).均值:

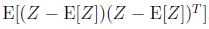

协方差Cov(Z)= =

= = ∑

= ∑

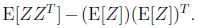

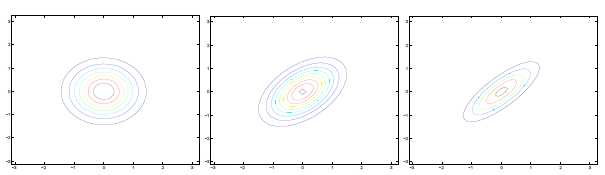

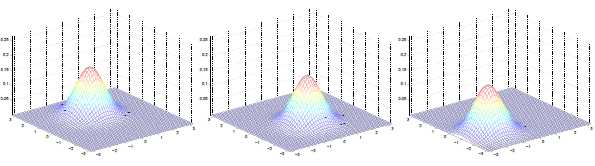

高斯分布的一些例子:

左图均值为零(2*1的零向量),协方差矩阵为单位矩阵I(2*2)(成为标准正态分布).

中图协方差矩阵为0.6I,

右图协方差矩阵为2I

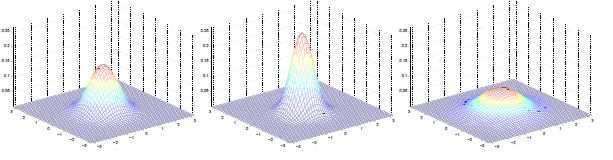

均值为0,方差分别为:

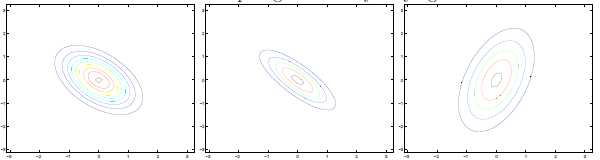

可见增加矩阵对角元素的值,即变量间增加相关性,高斯曲面会沿z1=z2(两个水平轴)方向趋于扁平。其水平面投影图如下:

即增加∑对角线的元素,图形会沿45°角,偏转成一个椭圆形状。

若∑对角线元素为负,图形如下:

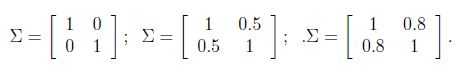

∑分别为:

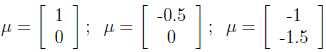

不同μ的图形如下:

μ分别为:

μ决定分布曲线中心的位置。

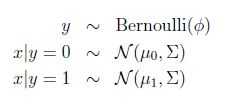

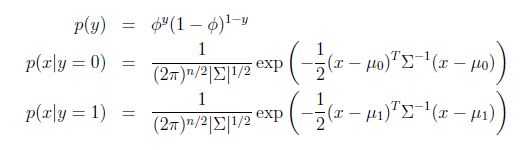

2、高斯判别分析模型

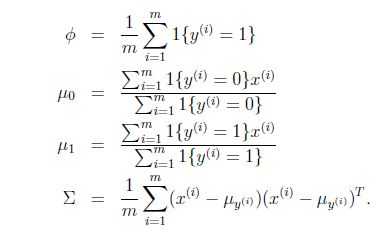

写出概率分布:

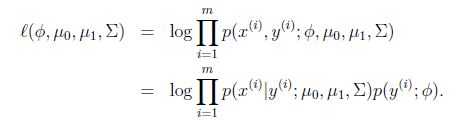

模型的参数为φ,μ0,μ1,∑,对数似然性为: (生成学习考虑的是joint likelihood 联合似然,判别学习算法考虑conditional likelihood)

φ:训练样本中标签为1的样本所占的比例

μ0:分母为标签为0的样本数,分子是对标签为0的样本的x(i)求和,结合起来就是对对标签为0的样本的x(i)求均值,与高斯分布参数μ为均值的意义相符

μ1:与μ0同理,标签改为1

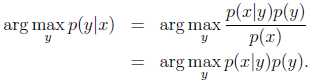

Predict:

预测结果应该是给定x的情况下最可能的y,等式左边的运算符argmax表示计算p(y|x)最大时的y值,预测公式如下:

因为p(x)独立于y,所以可以忽略p(x)。

如果p(y)为均匀分布,即每种类型的概率都相同,那么也可以忽略p(y),要求的就是使p(x|y)最大的那个y。不过这种情况并不常见。

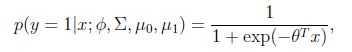

推论1:

x|y 服从高斯分布 => p(y=1|x)是logistic函数

该推论在反方向不成立。

推论2:

x|y=1 ~ Poisson(λ1),x|y=0 ~ Poisson(λ0) => p(y=1|x)是logistic函数

x|y=1 ~ Poisson(λ1)表示x|y=1服从参数为λ1泊松分布

推论3:

x|y=1 ~ ExpFamily(η1),x|y=0 ~ ExpFamily (η0) => p(y=1|x)是logistic函数

推论2的推广,即x|y的分布属于指数分布族,均可推出结论。显示了logistic回归在建模假设选择方面的鲁棒性。

优点:

缺点:

引例:垃圾邮件分类

实现一个垃圾邮件分类器,以邮件输入流作为输入,确定邮件是否为垃圾邮件。输出y为{0,1},1为垃圾邮件,0为非垃圾邮件。

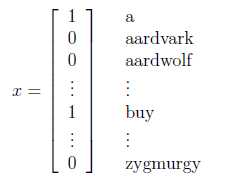

首先,要将邮件文本表示为一个输入向量x,设已知一个含有n个词的字典,那么向量x的第i个元素{0,1}表示字典中的第i个词是否出现在邮件中,x示例如下:

要对p(x|y)建模,x是一个n维的{0,1}向量,假设n=50000,那么x有2^50000种可能的值,一种方法是用多项式分布进行建模(伯努利分布对01建模,多项式分布对k个结果建模),这样就需要2^50000-1个参数,可见参数过多,下面介绍朴素贝叶斯的方法。

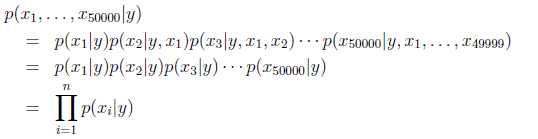

假设xi在给定y的时候是条件独立的,则x在给定y下的概率可简化为:(第二个=用到了朴素贝叶斯假设) 假设虽然有缺陷,但是实际效果很好。

模型参数包括:

Φi|y=1 = p(xi=1|y=1)

Φi|y=0 = p(xi=1|y=0)

Φy = p(y=1)

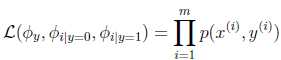

联合似然性:

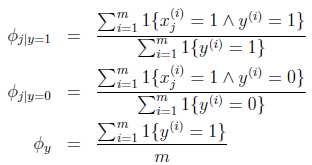

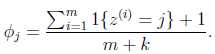

求得参数结果:

Φi|y=1的分子为标记为1的邮件中出现词j的邮件数目和,分母为垃圾邮件数,总体意义就是训练集中出现词j的垃圾邮件在垃圾邮件中的比例。

Φi|y=0就是出现词j的非垃圾邮件在非垃圾邮件中的比例。

Φy就是垃圾邮件在所有邮件中的比例。

求出上述参数,就知道了p(x|y)和p(y),用伯努利分布对p(y)建模,用上式中p(xi|y)的乘积对p(x|y)建模,通过贝叶斯公式就可求得p(y|x)

可以得到:

朴素贝叶斯的问题:

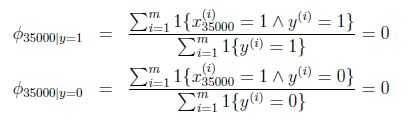

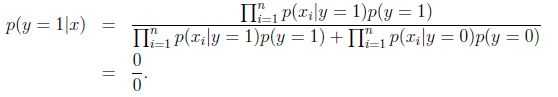

假设在一封邮件中出现了一个以前邮件从来没有出现的词,在词典的位置是35000,那么得出的最大似然估计为:

在统计上来说,在你有限的训练集中没有见过就认为概率是0是不科学的.

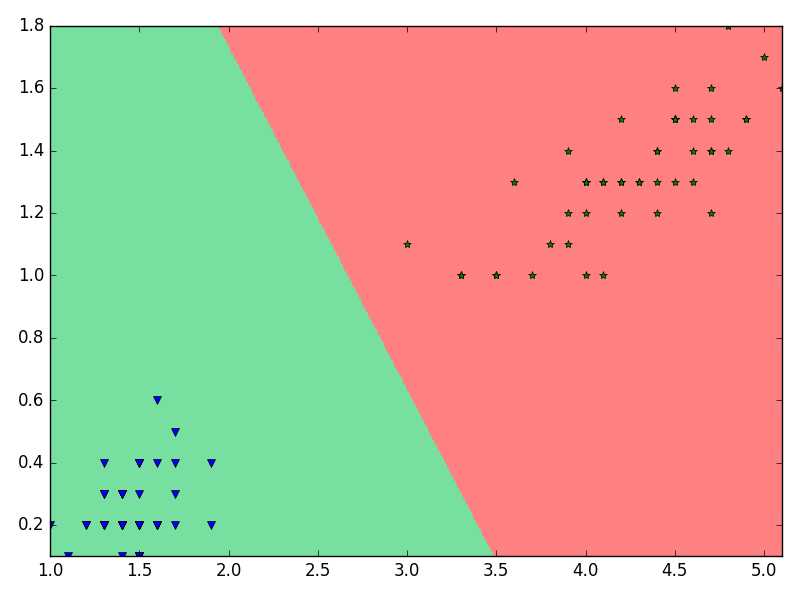

根据极大似然估计,p(y=1) = #”1”s / (#”0”s + #”1”s),即y为1的概率是样本中1的数目在所有样本中的比例。Laplace平滑就是将分子分母的每一项都加1,,即:

p(y=1) = (#”1”s+1) / (#”0”s+1 + #”1”s+1)

Generally:若y取k中可能的值

对于朴素贝叶斯,得到的结果为:

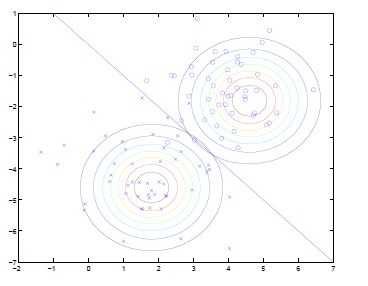

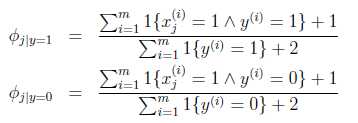

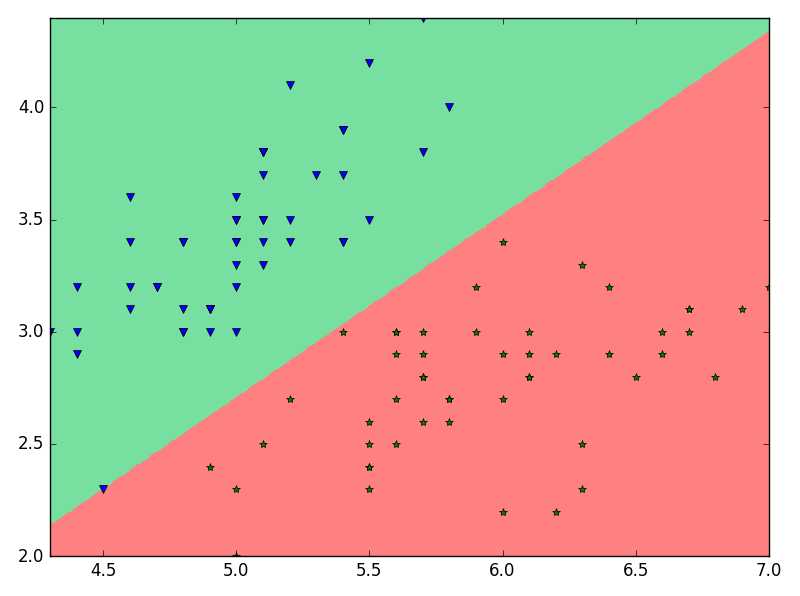

# -*- coding: utf-8 -*-from __future__ import divisionimport numpy as npimport matplotlib as mplimport matplotlib.pyplot as pltdef GDA( X, y ):m , m0 , m1 = len(y) , len(y[y==0]) , len(y[y==1])phi = m0 / mu0 = np.sum( X[y==0] , axis=0 ) / m0u1 = np.sum( X[y==1] , axis=0 ) / m1sigma = np.zeros( (len(X[0]),len(X[0]) ) )for x , y in zip( X , y ):if y == 0:sigma += np.dot( np.transpose([x - u0]) , (x - u0).reshape(1,2) )else:sigma += np.dot( np.transpose([x - u1]) , (x - u1).reshape(1,2) )sigma /= mreturn ( phi , u0 , u1 , sigma )def predict( x , phi , u0 , u1 , sigma ):inv = np.linalg.inv(sigma)y_hat = []for case in x:p0 = np.dot( np.dot((case - u0) , inv ) , (case - u0).T ) * (1 - phi)p1 = np.dot( np.dot((case - u1) , inv ) , (case - u1).T ) * phiy_hat.append( 0 if p0 < p1 else 1 )return np.array(y_hat)df = np.loadtxt(r‘C:\Users\LoveDMR\Desktop\8.iris.data‘, delimiter=‘,‘ , converters = { 4: lambda t : {‘Iris-setosa‘:0,‘Iris-versicolor‘:1,‘Iris-virginica‘:2}[t] } );df = df[df[:,4] != 2] # 为了方便学习 ,只关心二分类问题#手工特征选择 2个(方便可视化 0-3)feature = ( 0 , 1 )C1 = df[df[:,4] == 0]C2 = df[df[:,4] == 1]X , y = np.split(df,(4,), axis=1)X = X[:,feature[0]:feature[1]+1] # 只取两个特征y = y[:,0]phi , u0 , u1 , sigma = GDA( X, y )# 特征分布情况plt.figure()x1_min , x1_max = X[:,0].min() , X[:,0].max()x2_min , x2_max = X[:,1].min() , X[:,1].max()t1 = np.linspace(x1_min,x1_max , 500)t2 = np.linspace(x2_min,x2_max , 500)x1 , x2 = np.meshgrid( t1 , t2 )x_test = np.stack((x1.flat,x2.flat),axis=1)y_hat = predict( x_test , phi , u0 , u1 , sigma )y_hat = y_hat.reshape(x1.shape)cm_light = mpl.colors.ListedColormap([‘#77E0A0‘, ‘#FF8080‘])plt.pcolormesh(x1,x2,y_hat,cmap=cm_light)plt.plot(C1[:,feature[0]],C1[:,feature[1]] , ‘bv‘)plt.plot(C2[:,feature[0]],C2[:,feature[1]],‘g*‘)plt.xlim(x1_min, x1_max)plt.ylim(x2_min, x2_max)plt.tight_layout()plt.show()

http://blog.csdn.net/beechina/article/details/51074750

补充:样本方差公式中为什么要除以(n-1)而不是n呢?

样本方差与样本均值,都是随机变量,都有自己的分布,也都可能有自己的期望与方差。取分母n-1,可使样本方差的期望等于总体方差,即这种定义的样本方差是总体方差的无偏估计。 简单理解,因为算方差用到了均值,所以自由度就少了1,自然就是除以(n-1)了。

再不能理解的话,形象一点,对于样本方差来说,假如从总体中只取一个样本,即n=1,那么样本方差公式的分子分母都为0,方差完全不确定。这个好理解,因为样本方差是用来估计总体中个体之间的变化大小,只拿到一个个体,当然完全看不出变化大小。反之,如果公式的分母不是n-1而是n,计算出的方差就是0——这是不合理的,因为不能只看到一个个体就断定总体的个体之间变化大小为0。

知乎 https://www.zhihu.com/question/20099757

补充:贝叶斯网络

标签:space 分类 估计 公开课 line load for 训练 article

原文地址:http://www.cnblogs.com/flyfatty/p/6618998.html