标签:运算 hash 网络服务 镜像 并行 跟踪 download 系统环境 发送数据

集群是一组相互独立的、通过高速网络互联的计算机,它们构成了一个组,并以单一系统的模式加以管理。一个客户与集群相互作用时,集群像是一个独立的服务器。集群配置是用于提高可用性和可缩放性。 和传统的高性能计算机技术相比,集群技术可以利用各档次的服务器作为节点,系统造价低,可以实现很高的运算速度,完成大运算量的计算,具有较高的响应能力,能够满足当今日益增长的信息服务的需求。 而集群技术是一种通用的技术,其目的是为了解决单机运算能力的不足、IO能力的不足、提高服务的可靠性、获得规模可扩展能力,降低整体方案的运维成本(运行、升级、维护成本)。只要在其他技术不能达到以上的目的,或者虽然能够达到以上的目的,但是成本过高的情况下,就可以考虑采用集群技术

1) 提高性能

一些计算密集型应用,如:天气预报、核试验模拟等,需要计算机要有很强的运算处理能力,现有的技术,即使普通的大型机器计算也很难胜任。这时,一般都使用计算机集群技术,集中几十台甚至上百台计算机的运算能力来满足要求。提高处理性能一直是集群技术研究的一个重要目标之一。

2) 降低成本

通常一套较好的集群配置,其软硬件开销要超过100000美元。但与价值上百万美元的专用超级计算机相比已属相当便宜。在达到同样性能的条件下,采用计算机集群比采用同等运算能力的大型计算机具有更高的性价比。

3) 提高可扩展性

用户若想扩展系统能力,不得不购买更高性能的服务器,才能获得额外所需的CPU 和存储器。如果采用集群技术,则只需要将新的服务器加入集群中即可,对于客户来看,服务无论从连续性还是性能上都几乎没有变化,好像系统在不知不觉中完成了升级。

4) 增强可靠性

集群技术使系统在故障发生时仍可以继续工作,将系统停运时间减到最小。集群系统在提高系统的可靠性的同时,也大大减小了故障损失。

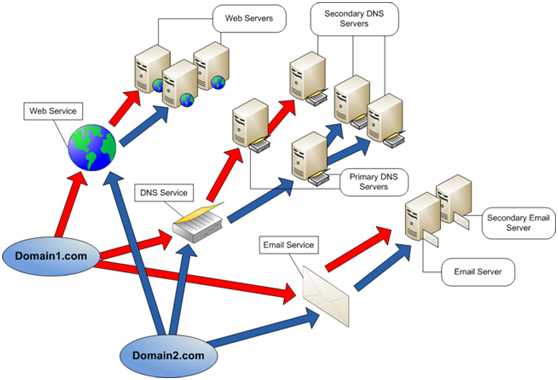

负载均衡集群为企业需求提供了更实用的系统。负载均衡集群使负载可以在计算机集群中尽可能平均地分摊处理。负载通常包括应用程序处理负载和网络流量负载。这样的系统非常适合向使用同一组应用程序的大量用户提供服务。每个节点都可以承担一定的处理负载,并且可以实现处理负载在节点之间的动态分配,以实现负载均衡。对于网络流量负载,当网络服务程序接受了高入网流量,以致无法迅速处理,这时,网络流量就会发送给在其它节点上运行的网络服务程序。同时,还可以根据每个节点上不同的可用资源或网络的特殊环境来进行优化。与科学计算集群一样,负载均衡集群也在多节点之间分发计算处理负载。它们之间的最大区别在于缺少跨节点运行的单并行程序。大多数情况下,负载均衡集群中的每个节点都是运行单独软件的独立系统。

但是,不管是在节点之间进行直接通信,还是通过中央负载均衡服务器来控制每个节点的负载,在节点之间都有一种公共关系。通常,使用特定的算法来分发该负载。

负载均衡集群典型搭配:

当集群中的一个系统发生故障时,集群软件迅速做出反应,将该系统的任务分配到集群中其它正在工作的系统上执行。考虑到计算机硬件和软件的易错性,高可用性集群的主要目的是为了使集群的整体服务尽可能可用。如果高可用性集群中的主节点发生了故障,那么这段时间内将由次节点代替它。次节点通常是主节点的镜像。当它代替主节点时,它可以完全接管其身份,因此使系统环境对于用户是一致的。

高可用性集群使服务器系统的运行速度和响应速度尽可能快。它们经常利用在多台机器上运行的冗余节点和服务,用来相互跟踪。如果某个节点失败,它的替补者将在几秒钟或更短时间内接管它的职责。因此,对于用户而言,集群永远不会停机。

在实际的使用中,集群的这三种类型相互交融,如高可用性集群也可以在其节点之间均衡用户负载。同样,也可以从要编写应用程序的集群中找到一个并行集群,它可以在节点之间执行负载均衡。从这个意义上讲,这种集群类别的划分是一个相对的概念,不是绝对的。

1)当业务重要,技术力量又薄弱,有钱买商业产品,如银行、证券、金融等

2)对于门户网站,会用并用软硬件分担单一产品的风险,融资企业。

3)中小型互联网公司,起步没利润,希望通过开源软件。

中小型互联网并发和总访问量不是很大的情况下,建议首选nginx负载均衡,nginx配置简单,使用方便,安全稳定,社区活跃,另一个产品haproxy(支持L4和L7负载均衡,nginx1.9之前只支持L7,新版支持L4,不过处于测试阶段)。

nginx+keepalived实现高可用,理由安装配置简单,安全稳定,类似的还有heartbeat(使用复杂,不建议初学者使用)

商业负载均衡产品:成本高、性能好、更稳定、缺点不能二次开发;开源软件相反。

lvs简单L4转发,实现ip负载均衡;L7层反向代理使用nginx/haproxy均可,以实际情况和技术栈定

详情请参考上一篇博文反向代理负载均衡之apache

环境准备:

[root@linux-node1 ~]# ifconfig eth0|grep "inet addr"|awk -F ‘[ :]+‘ ‘{print $4}‘ 192.168.230.129 [root@linux-node1 ~]# uname -r 2.6.32-504.el6.x86_64 [root@linux-node1 ~]# hostname linux-node1.example.com [root@linux-node1 ~]# cat /etc/redhat-release CentOS release 6.6 (Final)

第二台

[root@linux-node2 /]# ifconfig eth0|sed -n "2p"|awk -F ‘[ :]+‘ ‘{print $4}‘ 192.168.230.128 [root@linux-node2 /]# uname -r 2.6.32-504.el6.x86_64 [root@linux-node2 /]# hostname linux-node2.example.com [root@linux-node2 /]# cat /etc/redhat-release CentOS release 6.6 (Final)

两台机器都安装httpd,端口为8080 ,作为RS节点

最小化安装的新机器需要安装

yum install -y gcc glibc gcc-c++ make screen tree lrzsz

wget http://nginx.org/download/nginx-1.9.12.tar.gz useradd -s /sbin/nologin -M www tar zxf nginx-1.9.12.tar.gz cd nginx-1.9.12 ./configure --prefix=/usr/local/nginx-1.9.12 --user=www --group=www --with-http_ssl_module --with-http_stub_status_module --with-file-aio make && make install ln -s /usr/local/nginx-1.9.12/ /usr/local/nginx

不用PCRE,因为使用的是系统的PCRE Configuration summary + using system PCRE library + using system OpenSSL library + md5: using OpenSSL library + sha1: using OpenSSL library + using system zlib library

测试配置并启动Nginx

[root@linux-node2 /]# /usr/local/nginx/sbin/nginx -t nginx: the configuration file /usr/local/nginx-1.9.12/conf/nginx.conf syntax is ok nginx: configuration file /usr/local/nginx-1.9.12/conf/nginx.conf test is successful [root@linux-node2 /]# /usr/local/nginx/sbin/nginx

改nginx配置文件,并添加proxy.conf,重载nginx

[root@linux-node2 /]# cd /usr/local/nginx/conf/ [root@linux-node2 conf]# cp nginx.conf nginx.conf.bak [root@linux-node2 conf]# >nginx.conf [root@linux-node2 conf]# cat nginx.conf worker_processes 1; events { worker_connections 1024; } http { include mime.types; default_type application/octet-stream; sendfile on; keepalive_timeout 65; server { listen 80; server_name www.chuck-blog.com; location / { proxy_pass http://chuck-blog; include proxy.conf; } } upstream chuck-blog { server 192.168.230.128:8080 weight=1 max_fails=3 fail_timeout=30s; server 192.168.230.129:8080 weight=1 max_fails=3 fail_timeout=30s; } } [root@linux-node2 conf]# cat proxy.conf proxy_set_header Host $host; proxy_set_header X-Forwarded-For $remote_addr; proxy_connect_timeout 60; proxy_send_timeout 60; proxy_read_timeout 60; proxy_buffer_size 4k; proxy_buffers 4 32k; proxy_busy_buffers_size 64k; proxy_temp_file_write_size 64k; [root@linux-node2 conf]# /usr/local/nginx/sbin/nginx -t nginx: the configuration file /usr/local/nginx-1.9.12/conf/nginx.conf syntax is ok nginx: configuration file /usr/local/nginx-1.9.12/conf/nginx.conf test is successful [root@linux-node2 conf]# ../sbin/nginx -s reload

Nginx中的location指令是NginxHnpCoreModule中重要指令。Location指令比较简单, 也比较常用。Sets a configuration based on a request URI。

location指令,是用来对url进行匹配的,URI即语法中的/Uiri/,可以是宇符串或正则表达式,如果是正则表达,则必须指定前缀。

location指令根据URI来应用不同的配罝,这 个指令允许根据不同URI来应用不同的配置。

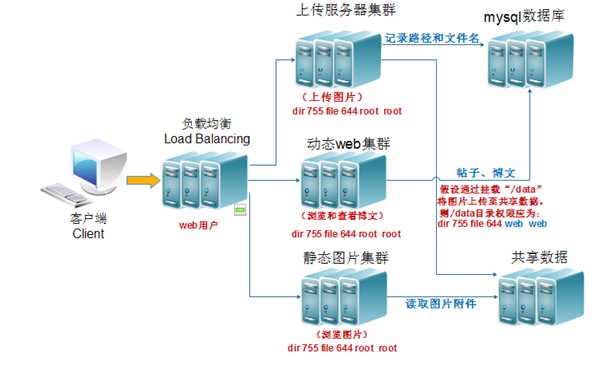

第一种方案:根据不同pool分离

[root@lb01 conf]# cat nginx.conf worker_processes 1; events { worker_connections 1024; } http { include mime.types; default_type application/octet-stream; sendfile on; keepalive_timeout 65; upstream static_pools { server 10.0.0.9:80 weight=1; } upstream upload_pools { server 10.0.0.6:80 weight=1; } upstream default_pools { server 10.0.0.9:8000 weight=1; } server { listen 80; server_name www.chuck-blog.com; location / { proxy_pass http://default_pools; include proxy.conf; } location /static/ { proxy_pass http://static_pools; include proxy.conf; } location /upload/ { proxy_pass http://upload_pools; include proxy.conf; } }

第二种方案:根据if判断路径分离

[root@lb01 conf]# cat nginx.conf worker_processes 1; events { worker_connections 1024; } http { include mime.types; default_type application/octet-stream; sendfile on; keepalive_timeout 65; server { listen 80; server_name www.chuck-blog.com.com; location / { if ($request_uri ~* "^/static/(.*)$" ) { proxy_pass http://static/$1; } if ($request_uri ~* "^/upload/(.*)$" ) { proxy_pass http://upload/$1; } proxy_pass http://dynamic/$1; include proxy.conf; } } upstream upload { server Web-A1:8000; } upstream static { server Web-A2; } upstream dynamic { server Web-A1; } }

[root@lb01 conf]# cat nginx.conf worker_processes 1; events { worker_connections 1024; } http { include mime.types; default_type application/octet-stream; sendfile on; keepalive_timeout 65; upstream static_pools { server 10.0.0.9:80 weight=1; } upstream upload_pools { server 10.0.0.6:80 weight=1; } upstream default_pools { server 10.0.0.9:8000 weight=1; } server { listen 80; server_name www.chuck-blog.com; location / { if ($http_user_agent ~* "MSIE") #如果请求的浏览器为微软IE浏览器(MSIE),则让请求由static_pools池处理 { proxy_pass http://static_pools; } if ($http_user_agent ~* "Chrome") #如果请求的浏览器为谷歌浏览器(Chrome),则让请求由upload_pools池处理 { proxy_pass http://upload_pools; } proxy_pass http://default_pools; } }

用来指定后端服务器的名称和一些参数,可以使用域名,IP,端口,或者unix socket。如果指定为域名,则首先将其解析为IP。

weight = NUMBER – 设置服务器权重,默认为1。

max_fails = NUMBER – 在一定时间内(这个时间在fail_timeout参数中设置)检查这个服务器是否可用时产生的最多失败请求数,默认为1,将其设置为0可以关闭检查,这些错误在proxy_next_upstream或fastcgi_next_upstream(404错误不会使max_fails增加)中定义。

fail_timeout = TIME – 在这个时间内产生了max_fails所设置大小的失败尝试连接请求后这个服务器可能不可用,同样它指定了服务器不可用的时间(在下一次尝试连接请求发起之前),默认为10秒,fail_timeout与前端响应时间没有直接关系,不过可以使用proxy_connect_timeout和proxy_read_timeout来控制。

down – 标记服务器处于离线状态,通常和ip_hash一起使用。

backup – (0.6.7或更高)如果所有的非备份服务器都宕机或繁忙,则使用本服务器(无法和ip_hash指令搭配使用)。

rr轮询(默认):按客户端顺序把客户端的请求注意分配到不同的后端服务器,如果后端服务器宕机(默认情况只检测80端口,如果后端报502,404,403,503,还是会直接返回给用户),后端宕机的服务器会被自动剔除,使用户访问不瘦影响,请求会分配给正常的服务器。

weight权重:在轮询算法的基础上加权重,权重轮询和访问成正比,权重越大,转发的请求也就越多,可以根据服务器的配置和性能指定权重值大小,可有效解决新旧服务器性能不均进行请求分配问题。

ip_hash:每个请求按访问ip的hash结果分配,当心的请求到达时,先将其客户端ip通过hash算法计算出一个值,在随后请求客户端中,只要ip的hash值相同,就会被分配至同一台服务器,该调度算法可以解决动态网页session共享问题,但有时会导致请求分配不均,即无法保证1:1的负载均衡。在国内都是NAT上网,多个PC,对应一个外部IP。

fair(第三方):按照后端服务器相应时间来分配,响应时间短的优先分配,比以上两个更加智能的负载均衡算法。此算法那可以依据页面大小和页面大小和加载时间长短智能地进行负载均衡,也就是根据后端服务器的响应时间来分配请求,响应时间段的优先分配,nginx本身是不支持fair的,如果需要使用这种调度算法,必须加载nginx的upstream_fair模块。

url_hash(第三方):按照url的hash结果来分配请求,让没给url定向到同一个后端服务器,后端服务器为缓存服务器时效果显著。在upstream中加入hash语句,server语句中不能写入weight等其他的参数。nginx本身是不支持url_hash的,如果需要使用这种电镀算法,必须安装nginx的hash软件包。

least_conn:最少连接数,哪个server连接数就分配给哪个server。

1)proxy_set_header

语法:proxy_set_header header value

默认值: Host and Connection

使用字段:http, server, location

这个指令允许将发送到被代理服务器的请求头重新定义或者增加一些字段。这个值可以是一个文本,变量或者它们的组合。

proxy_set_header在指定的字段中没有定义时会从它的上级字段继承。

默认只有两个字段可以重新定义:

proxy_set_header Host $proxy_host;

proxy_set_header Connection Close;

未修改的请求头“Host”可以用如下方式传送:

proxy_set_header Host $http_host;

但是如果这个字段在客户端的请求头中不存在,那么不发送数据到被代理服务器。这种情况下最好使用$Host变量,它的值等于请求头中的”Host”字段或服务器名:

proxy_set_header Host $host;

此外,可以将被代理的端口与服务器名称一起传递:

proxy_set_header Host $host:$proxy_port;

如果设置为空字符串,则不会传递头部到后端,例如下列设置将禁止后端使用gzip压缩:

proxy_set_header Accept-Encoding "";

2)proxy_set_header X-Forwarded-For

$remote-addr;

保留客户机的真实IP。包含客户端请求头中的”X-Forwarded-For”,与remoteaddr用逗号分开,如果没有”X?Forwarded?For”请求头,则

remoteaddr用逗号分开,如果没有”X?Forwarded?For”请求头,则

proxy_add_x_forwarded_for等于$remote_addr。

标签:运算 hash 网络服务 镜像 并行 跟踪 download 系统环境 发送数据

原文地址:http://www.cnblogs.com/w787815/p/6664972.html