标签:版本 系统变量 ipython package 好的 apach tin 方法 sub

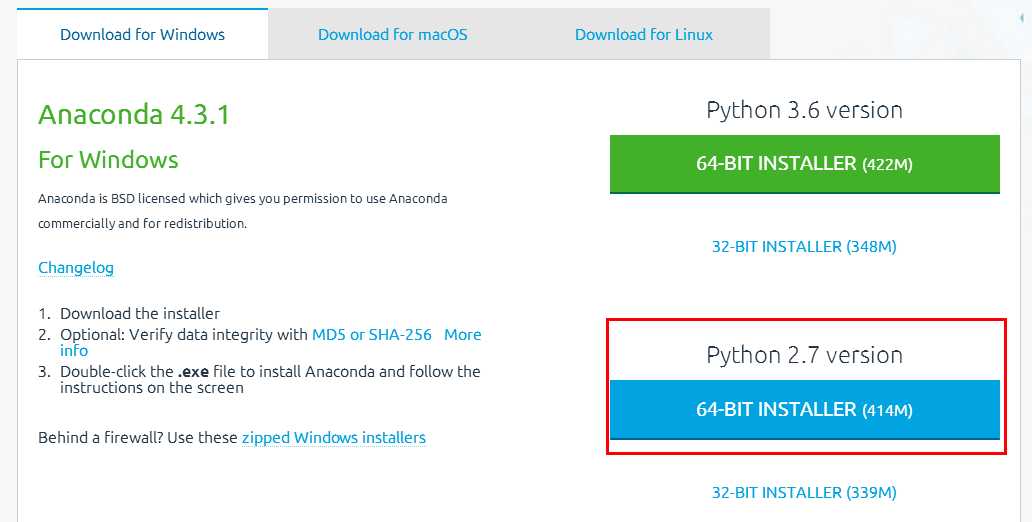

https://www.continuum.io/downloads

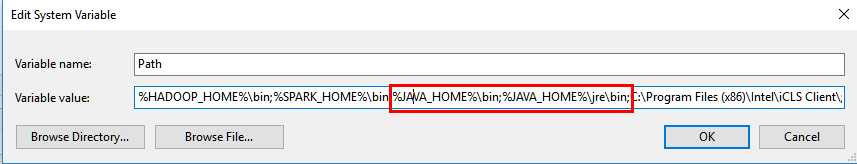

3.1环境变量配置:

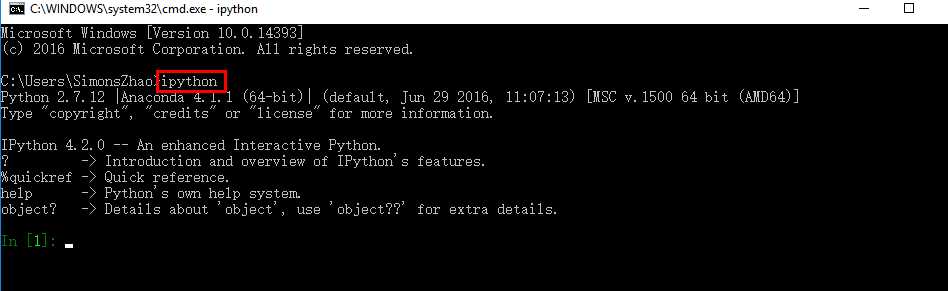

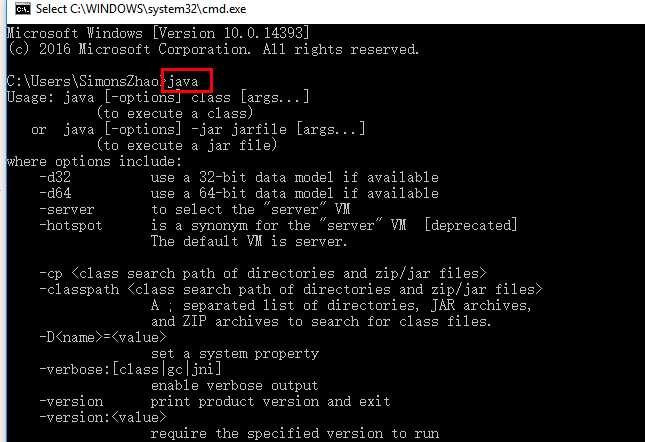

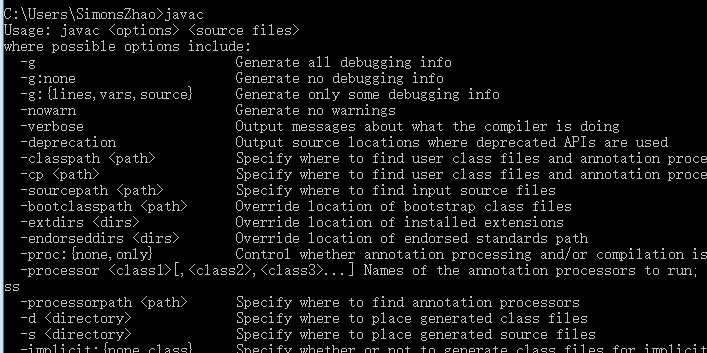

3.2测试:

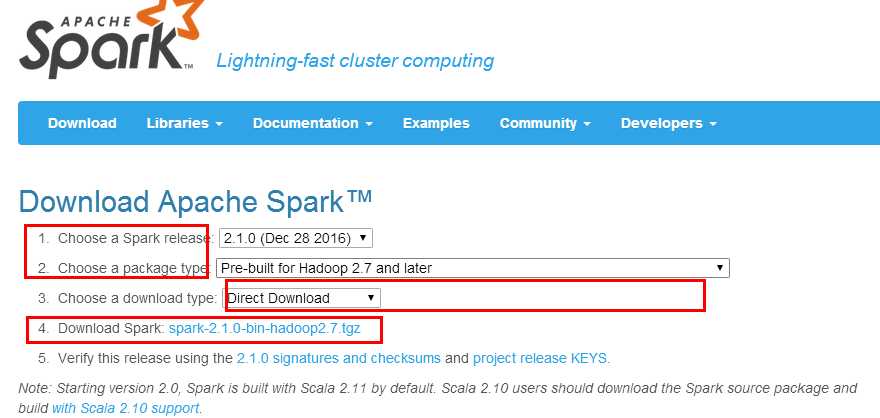

4.1 URL: http://spark.apache.org/downloads.html

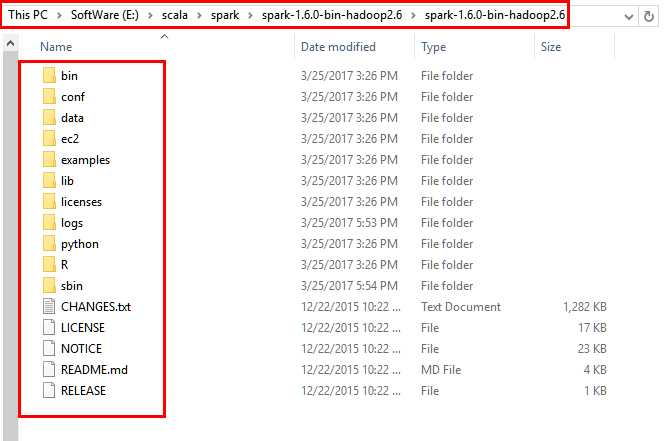

4.2解压到本地磁盘的对应目录

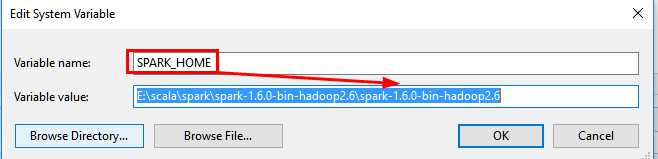

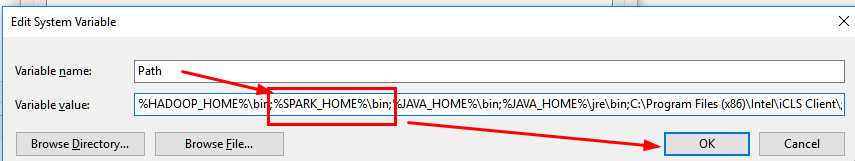

4.3配置环境变量

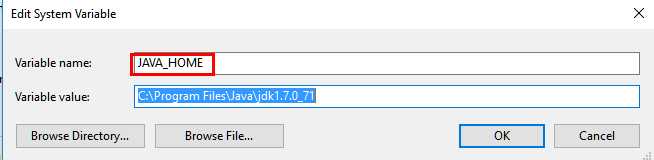

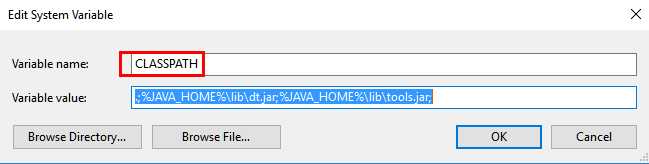

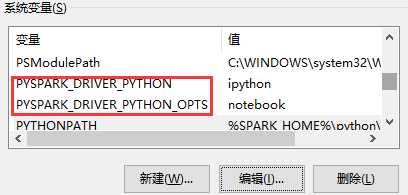

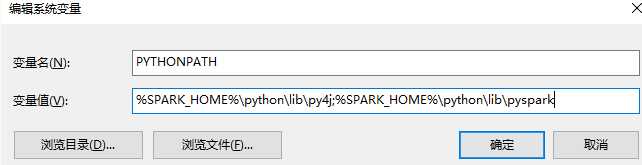

5.1配置如下系统变量

5.2修改spark\conf下的spark-env文件(不知道是否必要)

在文件末尾加入如下三行

export PYSPARK_PYTHON=/E:/ProgramCJ/Anaconda2

export PYSPARK_DRIVER_PYTHON=/E:/ProgramCJ/Anaconda2

export PYSPARK_SUBMIT_ARGS=‘--master local[*]‘

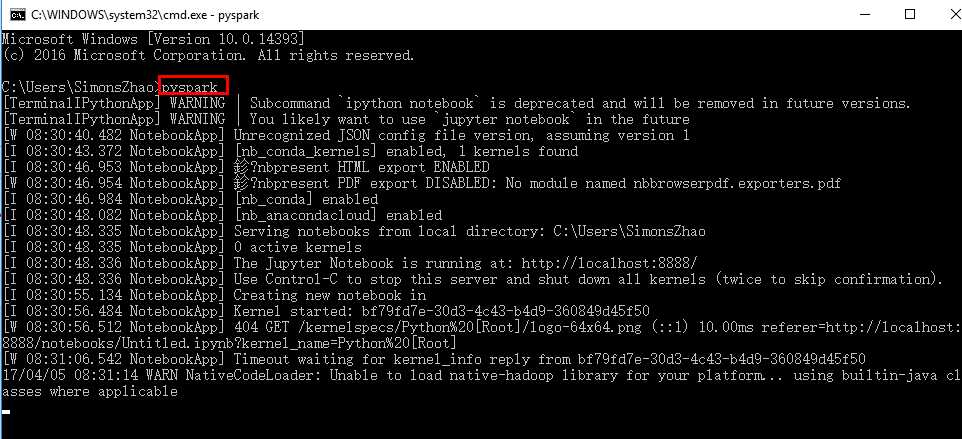

6.1命令行中输入pyspark测试

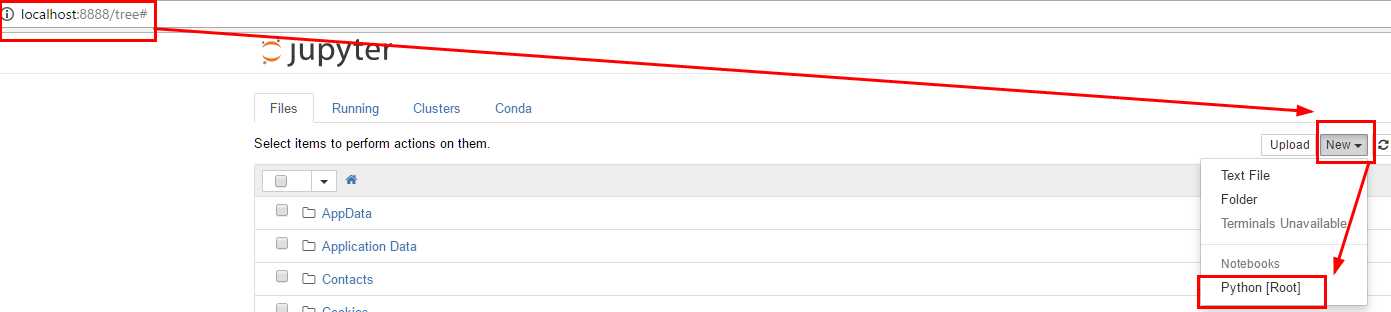

6.2 显示如下,并新建python root

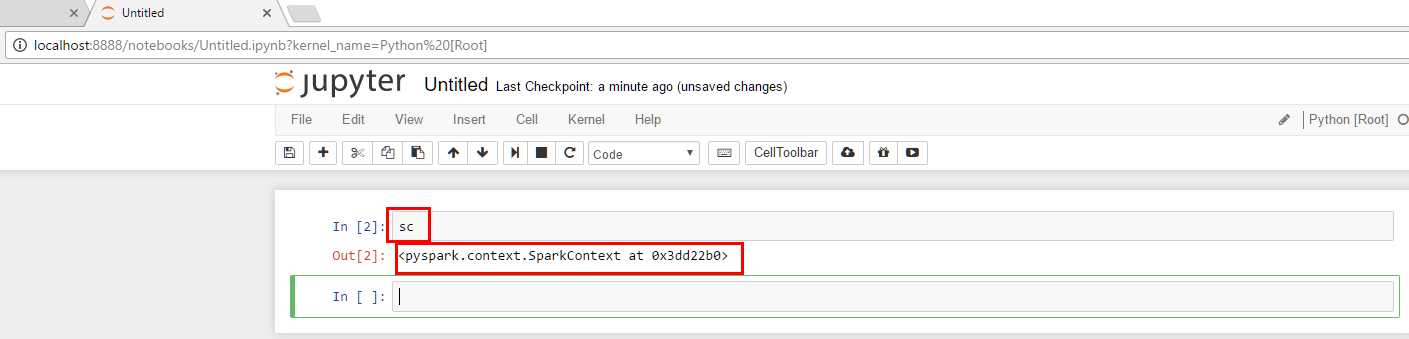

6.3测试sc的spark变量是否可用

注意:下载Spark请选择已经编译好的版本,如果选择源码版本,请使用maven或sbt进行编译即可,方法为进入Spark安装目录,使用> sbt package 进行编译

标签:版本 系统变量 ipython package 好的 apach tin 方法 sub

原文地址:http://www.cnblogs.com/jackchen-Net/p/6667205.html