标签:for block https project color cat 方便 nat ros

题目《Generating Text with Recurrent Neural Networks》

解决问题:(1)句子压缩(2)文本生成

要点:

(1)提出了新的rnn结构(MRNN)

题目《Generating Sequences With Recurrent Neural Networks

》

代码:https://sourceforge.net/projects/rnnl/

文本自动生成任务

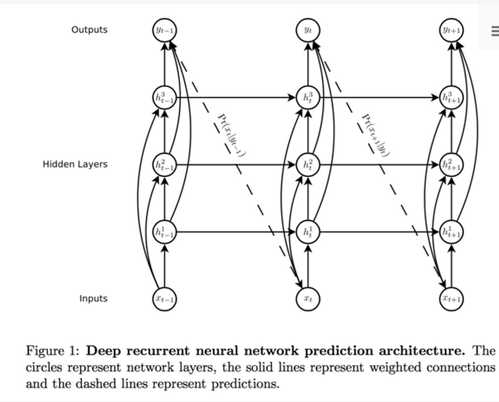

网络结构:

特点:

(1)这个网络在输入节点和所有隐层节点、所有隐层节点和输出节点之间都有连接,这样做的好处是更加方便的训练deep network。

(2)隐层单元该网络采用了LSTM单元。

(3)采用char-level language modeling,缩小解空间

(4)在模型训练时,输入数据切成100个bype为单元的sequence,但是模型的隐状态每100个sequence才复位,也就是实际的训练序列长度为10000个byte,也就是训练了整个文本。

题目《Globally Coherent Text Generation with Neural Checklist Models》

特点:菜谱生成的例子,预先提供关键词

题目《Semantically Conditioned LSTM-based Natural Language Generation for Spoken Dialogue Systems》

题目《SENTENCE ORDERING USING RECURRENT NEURAL NETWORKS》

要点:句子通顺度排序

题目《Backward and Forward Language Modeling for Constrained Sentence Generation》

要点:词汇限定条件下的文本生成

题目《Generating Topical Poetry》

要点:特定主题下的诗歌生成

题目《A Planning based Framework for Essay Generation》

要点:特定主题下的文章生成,比较贴近需求,但是没有用rnn的方法,通顺度存疑

解决问题的框架:

(1)topic understanding

(2)sentence extraction

(3)sentence reordering

题目《Controllable Text Generation》

要点:难度大

题目:《Survey of the State of the Art in Natural Language Generation: Core tasks, applications and evaluation》

要点:综述

题目《Generating Text from Structured Data with Application to the Biography Domain》

要点:从concept到文章

数据集:https://github.com/rlebret/wikipedia-biography-dataset

解决问题的框架:

(1)table data转换成embedding

(2)只生成一句话百科,长度比较短

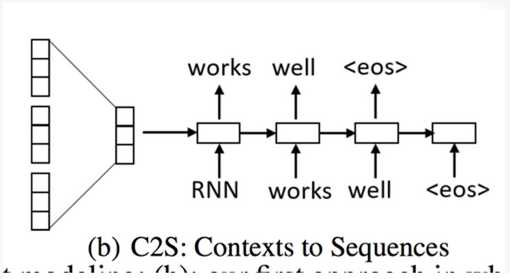

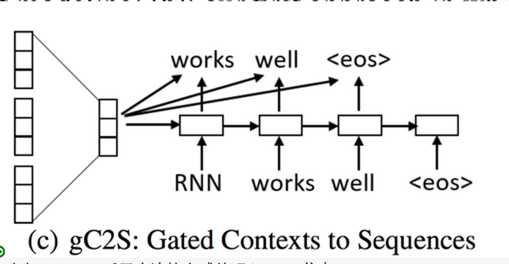

题目《Context-aware Natural Language Generation with Recurrent Neural Networks》

由机器生成评论

网络结构:

(1)Encoder采用全连接方式编码Context信息

题目《Generating sentences from a continuous space》

(1) http://machinelearningmastery.com/text-generation-lstm-recurrent-neural-networks-python-keras/

(2) 亚马逊评论数据集, http://jmcauley.ucsd.edu/data/amazon/links.html

标签:for block https project color cat 方便 nat ros

原文地址:http://www.cnblogs.com/zjgtan/p/6708468.html