标签:上传 编辑 查看 manager 分布式 blog shu jdk1.7 shuffle

1、上传

2、解压

tar -zxvf hadoop-2.6.5.tar.gz -C apps/

3、重命名

mv hadoop-2.6.5/ hadoop

4、配置hadoop环境变量

5、修改配置文件

5.1、编辑hadoop-env.sh,修改JAVA_HOME

export JAVA_HOME=/usr/jdk1.7.0_79

5.2、编辑core-site.xml修改如下

<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://m1:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/home/hadoop/apps/hadoop/tmp</value> </property> <property> <name>hadoop.proxyuser.hadoop.hosts</name> <value>*</value> </property> <property> <name>hadoop.proxyuser.hadoop.groups</name> <value>*</value> </property> </configuration>

5.3、修改hdfs-site.xml,如下

<configuration> <property> <name>dfs.replication</name> <value>2</value> </property> </configuration>

5.4、修改mapred-site.xml,如下

<configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration>

5.4、修改yarn-site.xml,如下

<configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> <property> <name>yarn.resourcemanager.hostname</name> <value>m1</value> </property> </configuration>

5.5、修改slaves,执行DataNode节点,一行一个

m2 m3

6、分发到其他机器

scp -r hadoop/ m2:$PWD scp -r hadoop/ m3:$PWD

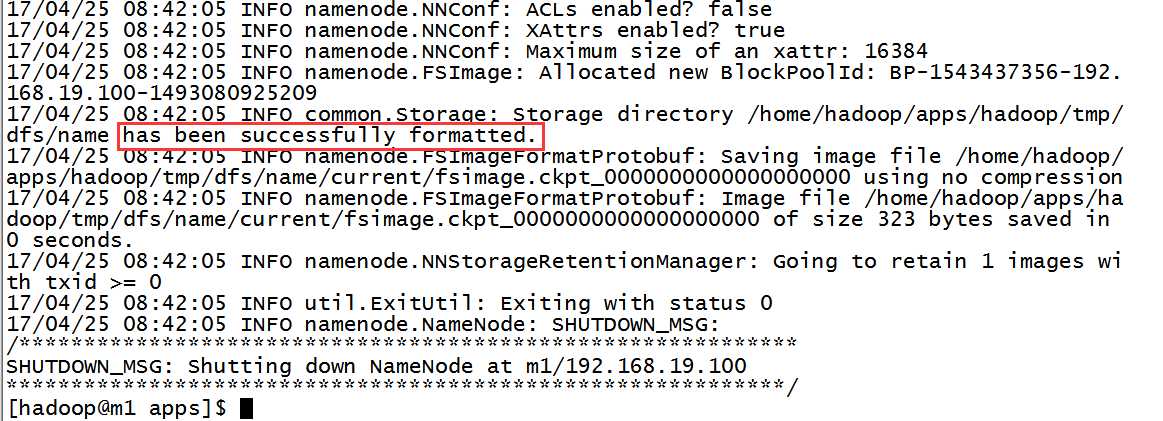

7、由于是第一次启动,因此在启动前需要格式化(NameNode节点上格式化)

hdfs namenode -format

8、启动hdfs, start-dfs.sh

9、启动yarn, start-yarn.sh

10、访问 http://m1:50070, 查看hdfs是否启动正常

11、访问 http://m1:8088, 查看yarn是否启动正常

标签:上传 编辑 查看 manager 分布式 blog shu jdk1.7 shuffle

原文地址:http://www.cnblogs.com/heml/p/6760827.html