标签:目标 方法 image ima 内存 src 网络 优化 log

步长:最优化问题中的叫法;

学习速率:神经网络中的叫法;

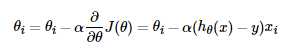

梯度更新的方式:

为步长(学习率)。

为步长(学习率)。

其中有必要说一点的是 表示的是当前实际的输出,y表示的是其类标。

表示的是当前实际的输出,y表示的是其类标。

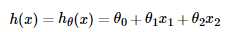

当输入为x时,目标函数表示为一个线性函数的形式为: 。其中每一个x1,x2,...表示的是维度。

。其中每一个x1,x2,...表示的是维度。

1. 梯度下降:对于 的更新是所有样本都参与的,那么得到的梯度是一个比较标准的值,一次更新的幅度也会比较大,但是样本多的时候,并且样本的维度也是很大的,会降低运算的速度。此外,对电脑内存等也是一个巨大的考验。现在在实际中很少使用。当然,当样本比较少的时候,是可以用的。

的更新是所有样本都参与的,那么得到的梯度是一个比较标准的值,一次更新的幅度也会比较大,但是样本多的时候,并且样本的维度也是很大的,会降低运算的速度。此外,对电脑内存等也是一个巨大的考验。现在在实际中很少使用。当然,当样本比较少的时候,是可以用的。

2. 随机梯度下降:对 是随机的选取一个样本,通过这个小的的梯度来更新整体的,当然是不太准确的,但是重在速度快,当训练的迭代次数比较多的时候,也会去的很好的效果。不过,注意陷入局部最优解。

是随机的选取一个样本,通过这个小的的梯度来更新整体的,当然是不太准确的,但是重在速度快,当训练的迭代次数比较多的时候,也会去的很好的效果。不过,注意陷入局部最优解。

3. 小批量梯度下降:对 是随机的选取一个小的batch,这个方法在深度学习中使用的比较多。

是随机的选取一个小的batch,这个方法在深度学习中使用的比较多。

标签:目标 方法 image ima 内存 src 网络 优化 log

原文地址:http://www.cnblogs.com/Yu-FeiFei/p/6810690.html