数据挖掘 第二章 神经网络基础

§2.1 生物神经元模型

§2.2 人工神经元模型

§2.3 网络拓扑结构类型

§2.4 人工神经网络模型

§2.5 神经网络的学习

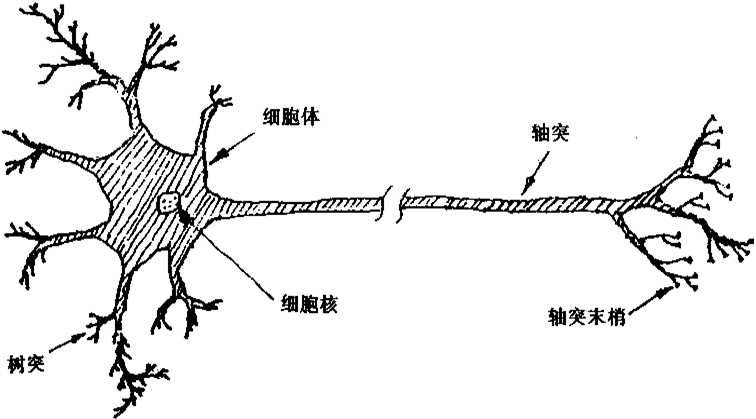

§2.1 生物神经元模型

神经元是脑组织的基本单元,是神经系统结构与功能的单元。据统计大脑大约包含1.4*1011个神经元,每个神经元于大约103*~105个其他的神经元相连接,构成一个极为庞大而复杂的网络,即生物神经元网络。生物神经元网络中各神经元之间连接的强弱,按照外部的刺激信号做自适应变化,而每个神经元又随着所接受的的多个激励信号的综合结果呈现出兴奋与抑制状态。大脑的学习过程就是神经元之间连接强度随外部刺激信息做自适应变化的过程,大脑处理星系的结果有个圣经元状态的整体效果确定。

生物神经元基本结构:细胞体(Cell body)、树突 (Dendrite) 、轴突、(Axon)、 突触(Synapse) 每一个神经元都通过突触与其他神经元联系,突触的“连接强度”可随系统受到训练的强度而改变。

生物神经元功能:

兴奋与抑制——传入神经元的冲动经整和后使细胞膜电位升高,超过动作电位的阈值时即为兴奋状态,产生神经冲动,由轴突经神经末梢传出。传入神经元的冲动经整和后使细胞膜电位降低,低于阈值时即为抑制状态,不产生神经冲动。

学习与遗忘——由于神经元结构的可塑性,突触的传递作用可增强与减弱,因此神经元具有学习和遗忘的功能。

§2.2 人工神经元模型

人工神经网络是在现代神经生物学研究基础上提出的模拟生物过程以反应人脑某些特性的计算结构。它不是人脑神经系统的真实描写,只是特的某种抽象、简化和模拟。

1943年,McCulloch-Pitts(麦克洛奇-皮兹) 根据生物神经元的动作原理提出了神经元模型,即M-P模型,经过不断改进,形成目前广泛应用的形式神经元模型,对于神经元的处理机制,该模型在简化的基础上提出 以下6点 假设进行描述:

1. 每个神经元都是一个多输入单输出的信息处理单元

2. 突触分兴奋性和抑制性两种类型

3. 神经元具有空间整合特性和阈值特性

4. 神经元输入与输出间有固定的时滞,主要取决于突 触的延迟

5. 忽略时间整合作用和不应期

6. 神经元本身是非时变的,即其突触时延和突触强度 均为常数

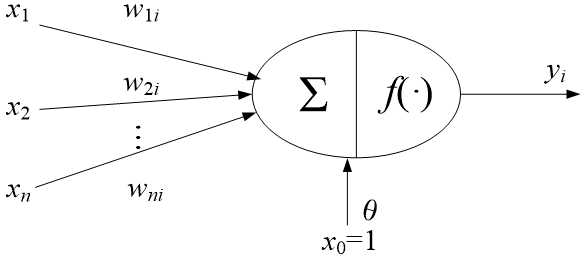

人工神经元输入输出关系可描述为

其中xj (j = 1,2,…, n)是从其它神经元传来的输入信号,wji表示从神经元j到神经元i的连接权值,θi 为阈值,f(?)称为激发函数或作用函数

输出激发函数f(·)又称为变换函数,它决定神经元(节点)的输出。该输出为1或0,取决于其输入之和大于或小于内部阈值。函数一般具有非线性特征。几种常见的激发函数包括:阈值函数、饱和型函数、双曲函数、S型函数、高斯型函数

§2.3 网络拓扑结构类型

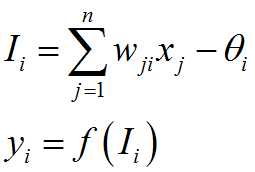

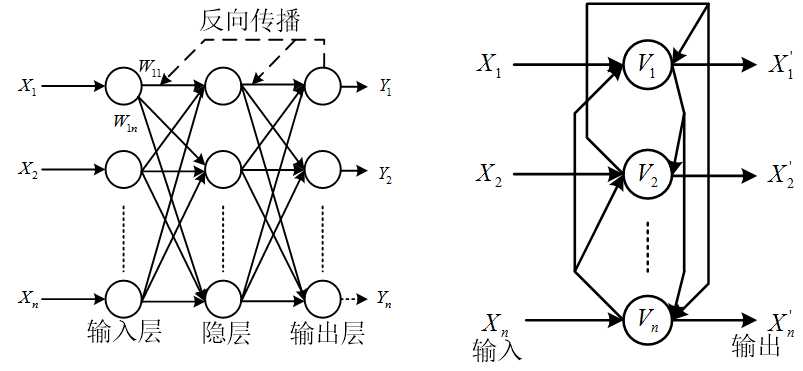

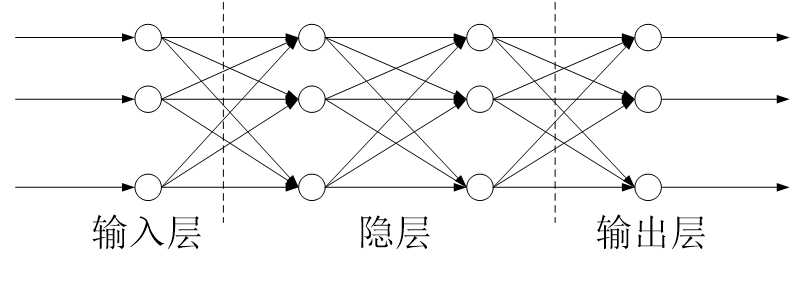

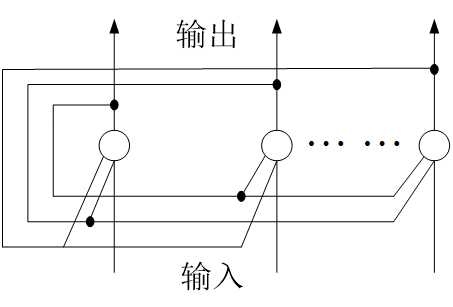

以下分别是层次型结构和互联型结构

§2.4 人工神经网络模型

人工神经网络是以工程技术手段来模拟人脑神经网络的结构与特征的系统。利用人工神经元,可以构成各种不同拓扑结构的神经网络。就神经网络的主要连接形式而言,目前已有数十种不同的神经网络模型,其中前馈网络和反馈网络是两种典型的结构模型。

(1)前馈神经网络,又称前向网络。如下图所示,神经元分层排列,有输入层、隐层(亦称中间层,可有若干层)和输出层,每一层的神经元只接受前一层神经元的输入。

目前,大部分前馈网络都是学习网络,它们的分类能力和模式识别能力一般都强于反馈网络,典型的前馈网络有感知器网络、误差反向传播(BP)网络等。

(2)反馈神经网络的结构如下图所示。若总节点(神经元)数为N,则每个节点有N个输入和一个输出,即所有节点都是一样的,它们之间都可相互连接。

Hopfield神经网络是反馈网络中最简单且应用广泛的模型,它具有联想记忆的功能,如果将Lyapunov函数定义为寻优函数,Hopfield神经网络还可以用来解决快速寻优问题。

§2.5 神经网络的学习

人工神经网络最有吸引力的特点就是它的学习能力。学习方法是体现人工神经网络智能特征的主要指标,离开了学习算法,人工神经网络就失去了自适应、自组织和自学习的能力。人工神经网络的学习过程就是对它的训练过程。所谓训练,就是在将由样本向量构成的样本集合输入到人工神经网路的过程中,按照一定方式去调整神经元之间的连接权。使网络能将样本集的内涵以连接权矩阵的方式存储起来,从而使网络在数据输入时可以给出适当的输出。

目前神经网络的学习方法有多种,按有无教师信号来分类,可分为有教师学习、无教师学习和再励学习等几大类。在有教师的学习方式中,网络的输出和期望的输出(即教师信号)进行比较,然后根据两者之间的差异调整网络的权值,最终使差异变小。在无教师的学习方式中,输入模式进入网络后,网络按照预先设定的规则(如竞争规则)自动调整权值,使网络最终具有模式分类等功能。再励学习是介于上述两者之间的一种学习方式。

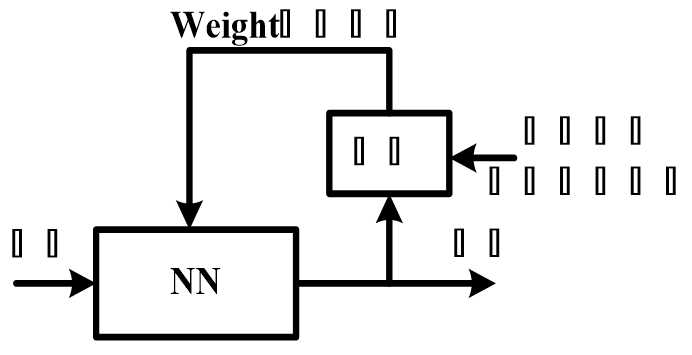

(1)有教师学习,也称有监督学习

假设教师和神经网络同时要对从周围环境中抽取出来的训练向量(即例子)做出判断,教师可以根据自身掌握的一些知识为神经网络提供期望响应。

期望响应一般都代表着神经网络完成的最优动作。神经网络的参数可以在训练向量和误差信号的综合影响下进行调整。误差信号可以定义为神经网络实际响应与预期响应之差。这种调整可以逐步而又反复地进行,其最终目的就是要让神经网络模拟教师信号。

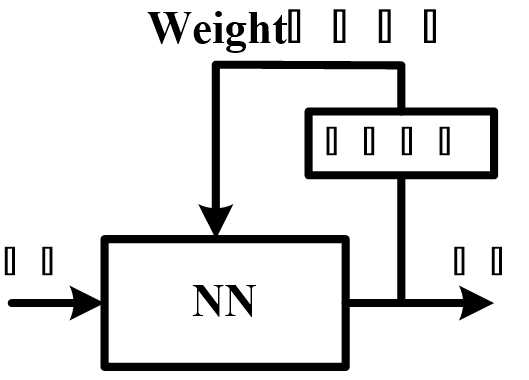

(2)无教师学习

在无教师学习范例中,没有教师监视学习过程,即神经网络没有任何例子可以学习。

无教师学习又可分为两类:自组织学习、无监督竞争学习

a)自组织学习:即网络的学习过程完全是一种自我学习的过程,不存在外部教师的示教,也不存在来自外部环境的反馈指示网络应该输出什么或者是否正确。自组织学习过程中,网络根据某种规则反复地调整连接权以响应输入模式的激励,直到网络最后形成某种有序状态。也就是说,自组织学习是靠神经元本身对输入模式的不断适应,抽取输入信号的规律(如统计规律)。一旦网络显现出输入数据的统计特征,则网络就实现了对输入特征的编码,即把输入特征“记忆”下来。而且在记忆之后,当它再出现时,能把它识别出来。自组织学习能对网络的学习过程进行度量,并优化其中的自由参数。可以认为,这种学习的评价准则隐含于网络内部。神经网络的这种自组织特性来源于其结构的可塑性。

b)无监督竞争学习:在无监督竞争学习系统中,没有外部的教师或则评价来监督学习的过程。要求网络学习该度量而且自由参数将根据这个度量来逐步优化。 为了完成无监督竞争学习规则,神经网络包括两层:输入层和竞争层。输入层接受有用的数据。竞争层由相互竞争的神经元组成,采用“胜者全得”的策略,具有最大总输入的神经元的输出置1,赢得竞争而被激活,其它神经元置0,连接权的调整仅在获胜神经元与输入之间进行,其他皆不变。

(3)再励学习

把学习看作试探评价(奖或惩)过程,学习机选择一个动作(输出)作用于环境之后,使环境的状态改变,并产生一个再励信号(奖或惩)反馈至学习机。学习机依据再励信号与环境当前的状态选择下一动作作用于环境,选择的原则是使受到奖励的可能性增大。

常用学习规则:Hebb规则、Delta规则(最小均方差规则)、概率式学习规则、竞争式学习规则、梯度下降规则、Kohonen(克豪南)学习规则、逆误差传播规则

原文地址:http://www.cnblogs.com/Chris-math/p/6984575.html