标签:image height nal 神经网络 公式 计算公式 速度 max str

1.Why

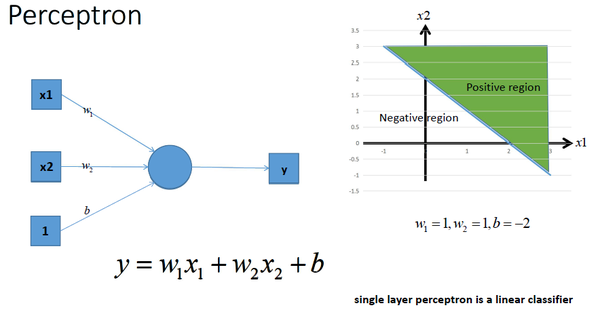

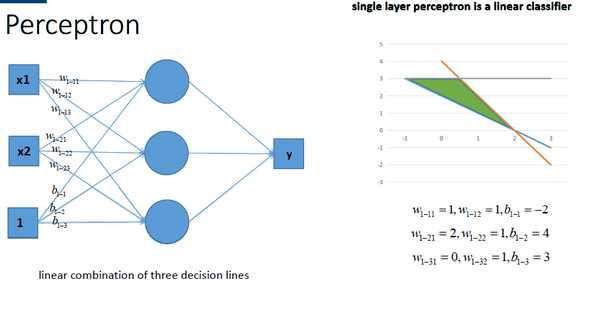

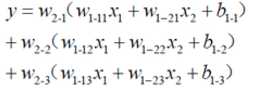

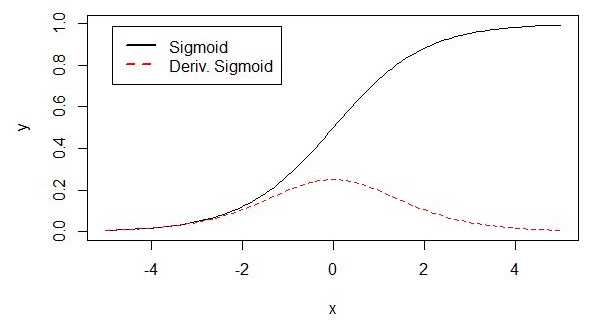

激活函数的作用: 用来加入非线性因素的,因为线性模型的表达能力不够。 如下一个单层感知机:

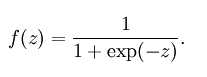

因此,提出了激活函数,在每层叠加完后,加一个激活函数,就变为非线性函数。。。

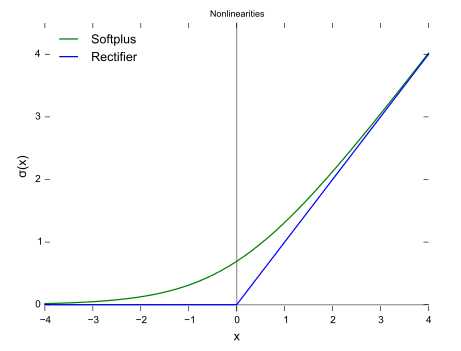

1)单侧抑制

2)相对宽阔的兴奋边界

3)稀疏激活性。

梯度不饱和:梯度计算公式为:1{x>0},因此在反向传播过程中,减轻了梯度弥散的问题,神经网络前几层的参数也可以很快的更新。

计算速度快。正向传播过程中,sigmoid和tanh函数计算激活值时需要计算指数,而Relu函数仅需要设置阈值。如果x<0,f(x)=0,如果x>0,f(x)=x。加快了正向传播的计算速度。

标签:image height nal 神经网络 公式 计算公式 速度 max str

原文地址:http://www.cnblogs.com/fanhaha/p/7061318.html