标签:src 一个 href link 思想 基础 bp神经网络 margin 利用

作者:桂。

时间:2017-08-19 22:40:05

链接:http://www.cnblogs.com/xingshansi/p/7398396.html

未完待续

前言

BP与RBF是分析基本神经网络的两个概念,最近接触到这些概念(目前的认识是:用在矩阵分析中减少计算量),简单梳理一下。

这里记录基本的BP神经网络,神经网络的基础是感知器,这里的BP(back propagation )算法是求解神经网络参数的一种实现思路。

一、算法简介

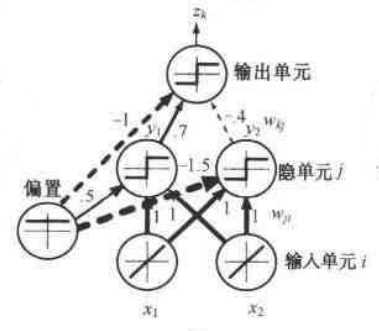

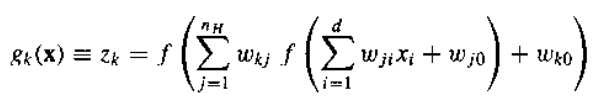

任何从输入到输出的连续函数都可以用一个三层非线性网络实现,条件是给出足够多的隐单元数。BP的基本结构:

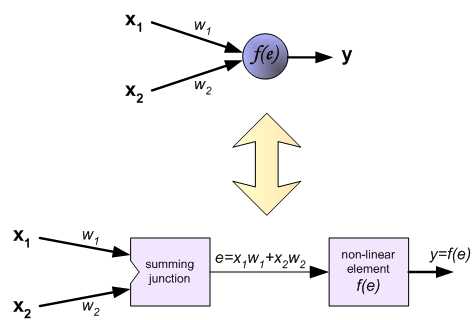

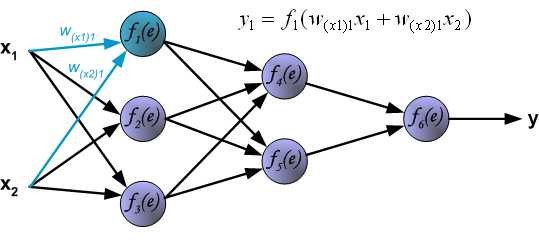

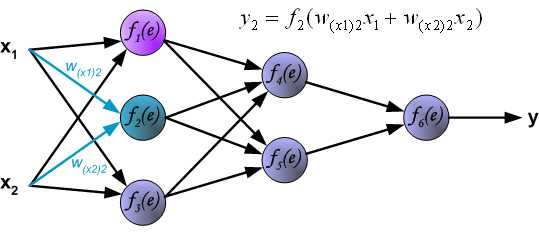

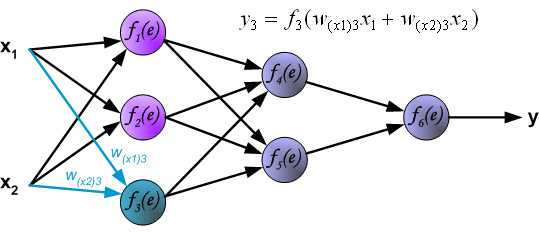

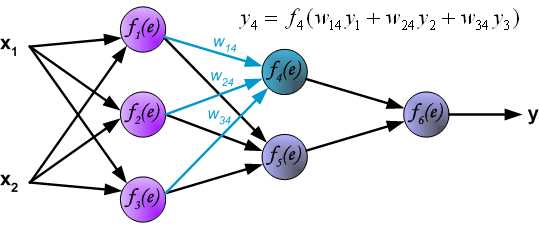

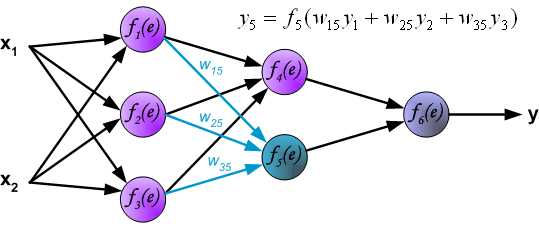

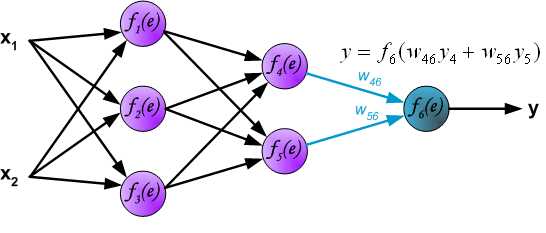

包括输入单元、输出单元、中间的各个层次称为隐单元,上面的网络结构可以表述为:

其中f(.)是判别函数,因为优化通常涉及到求导,所以平滑性对梯度下降类学习方法很有效,通常f(.)选取连续易求导的判别函数,如sigmoid。

反向传播主要利用误差项(正是因为:根据误差项,建立准则函数,进行参数优化,而误差只能从输出计算,因而误差的计算顺序从后往前,也就是反向传播的概念,进而更新权重w。)。

由于涉及到梯度下降,因此针对参数求解的那一套改进这里也使用:如基于一阶导的随机梯度下降、批量梯度下降,基于二阶导的Newton-raphson等等。

二、BP的直观描述

A-结构图及映射关系

首先借助一篇讲义来直观描述BP的思想:

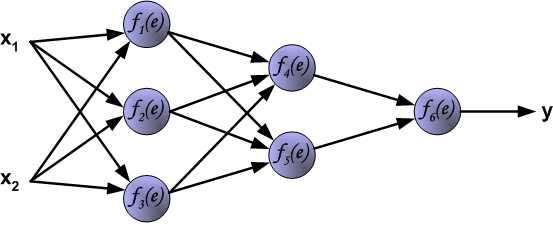

BP的结构图:

结构图对应的映射关系:

B-神经网络的计算步骤

神经网络在参数给定的情况下,计算依旧是从输入→输出的顺序。

第一层:

第二层:

第三层:

至此已经得到输出结果,可以根据训练数据的理想输出,计算误差(反向传播)。

C-误差反向传播

至此可以借助准则函数,更新利用了求偏导的特性(也称为链式微分法则)。

D-利用BP更新权重的步骤

三、BP的参数推导及算法流程

参考

标签:src 一个 href link 思想 基础 bp神经网络 margin 利用

原文地址:http://www.cnblogs.com/xingshansi/p/7398396.html