标签:des style blog http io os java ar strong

准备工作:

1)安装了伪分布式hadoop:参照http://blog.csdn.net/zolalad/article/details/11472207

2)修改已安装好的hadoop配置文件:

a)修改hdfs-site.xml

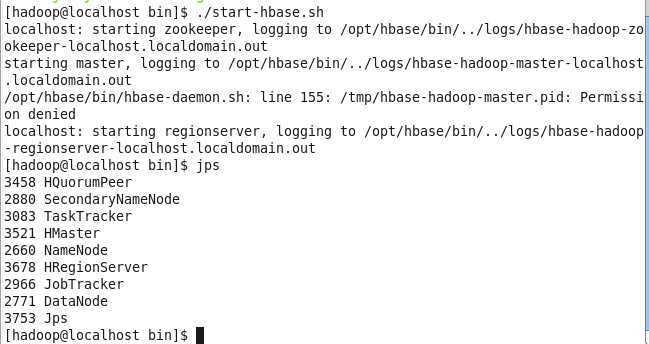

安装HBase

写在前面,需注意:在root用户下配置,所以在启动前需要进行下面操作,确保将hbase相关文件付给了hadoop用户

cd /opt/hbase

ls -alh --查看各文件的用户

chown -R hadoop:hadoop hbase/ --如果有的文件用户是root,则需将该文件赋给hadoop用户

如果在后面启动步骤报错,权限不够,请确认/opt/hbase/logs文件是属于hadoop用户

解压与安装

export HBASE_MANAGES_ZK=true

export JAVA_HOME=/usr/program/jdk1.6.0_13

export HBASE_CLASSPATH=/opt/hbase

2)配置hbase/conf/hbase-site.xml

<configuration>

<property>

<name>hbase.rootdir</name>

<!-- 下面路径一定要跟hadoop中core-site.xml中fs.default.name中的路径相同,否则会出错。-->

<value>hdfs://localhost:9000/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value> <!--表明是否是完全分布式hbase集群 -->

</property>

<property>

<name>hbase.localhost</name>

<value>localhost</value>

</property>

<property>

<name>hbase.tmp.dir</name>

<value>/home/hadoop/tmp</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>localhost</value> <!--主机名 -->

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/home/${user.name}/zookeeper</value>

</property>

<property>

<name>dfs.replication</name>

<value>true</value>

<description>The replication countfor HLog HFile storage. Should not be greater than HDFS datanode count.

</description>

</property>

标签:des style blog http io os java ar strong

原文地址:http://www.cnblogs.com/xixi90/p/3967137.html