标签:fun ati 消失 color 梯度 src images 循环 函数

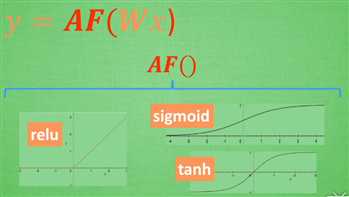

relu

sigmoid

tanh

激励函数。

可以创立自己的激励函数解决自己的问题,只要保证这些激励函数是可以微分的。

只有两三层的神经网络,随便使用哪个激励函数都可以。

多层的不能随便选择,涉及梯度爆炸,梯度消失的问题。

卷积神经网络推荐relu

循环神经网络推荐tanh或者relu

标签:fun ati 消失 color 梯度 src images 循环 函数

原文地址:http://www.cnblogs.com/CATHY-MU/p/7801030.html