标签:全局 -o net dap 图片 状态 产生 back 功能性

基本概念:

- Neural Networks:神经网络,由具有适应性的简单单元组成的广泛并行互联的网络,能够模拟生物神经系统对真实物体之间做出的交互反应

- Neuron:神经元,神经网络的组成单元,收到的输入超过阀值时,会被激活,并传递信息到下一级神经元。

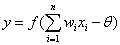

- M-P神经元模型:每个神经元接收到来自n个其他神经元传来的信号,每个输入信号带有一个connection weight(连接权重),加权得到一个总输入值与threshold(阀值)进行比较,通过activation function(激活函数,如Sigmoid函数)产生神经元的输出

其中,y为当前神经元输出,f()为激活函数,n、x、w分别为前一级神经元个数、输出值(也是当前神经元的输入值)和权重值。

神经网络的学习过程,就是根据训练数据来调整神经元之间的connection weight和threshold。

- perceptron(感知机):最简单的神经网络,包含一层输入层和一层输出层;其中仅输出层包含功能性神经元(具有激活函数的神经元)

- hidden layer(隐含层):神经网络输入层与输出层之间的功能性神经元

- feedforward neural networks(前馈神经网络):不存在环或回路的神经网络结构

BP(error BackPropagation)算法:

- 标准BP:算法流程和步骤(待补充)

- accumulated BP(累积BP):

1)标准BP对训练集的单次样本学习会做一次参数调整,而累积BP则对整个训练集学习完后才进行参数调整

2)标准BP由于对不同样例学习后进行更新可能出现抵销的效果,所以需要更多次数的迭代

3)当训练集非常大时,标准BP会有更快更高效的收敛效果

- trial-by-error:解决如何设置隐含层神经元的个数问题的常用方法

- 解决BP算法过拟合的手段:early stopping 和 regularization

Local minimum & Global minimum(全局最小与局部极小):

- 全局最小一定是局部极小,反之则不成立

- 如何解决陷入局部极小的问题:

1)以多组不同参数值初始化神经网络,训练后,取误差最小的接作为最终参数

2)simulated annealing(模拟退火):每一步迭代以一定概率接受次优解

3)随机梯度下降:计算梯度时加入随机因素,使局部极小时梯度非零,调整梯度下降方向

4)genetic algorithms(遗传算法)

其他神经网络:

- RBF(Radial Basis Function)

- ART(Adaptive Resonance Threory,competitive learning-竞争型无监督网络)

- SOM(Self-Organizing Map,competitive learning-竞争型无监督网络)

- Cascade-Correlation Networks(级联相关网络,结构自适应,能学习和调整网络结构本身)

- Elman(recurrent neural networks,递归神经网络,能处理与时间有关的动态变化问题)

- Boltzmann(energy-based model,基于能量的模型,训练目标为最小化能量值使网络达到最理想状态;神经元都是布尔型)

开啃《机器学习》(周志华)- 第5章 神经网络

标签:全局 -o net dap 图片 状态 产生 back 功能性

原文地址:http://www.cnblogs.com/wrightcw/p/7999999.html