Rectifier(neural networks)

在人工神经网络中,rectfier(整流器,校正器)是一个激活函数,它的定义是:参数中为正的部分。

其中,x是神经元的输入。这也被称为ramp function(斜坡函数),类似于电气工程中半波整流。

由来:

2000年由Hahnloser et al等人首次将该激活函数引入动态网络中,具有强烈的生物学动机和数学理论。

此激活函数在 convolutional networks中被广泛应用,比logistic sigmoid更有效和实用。

rectfier是2017年深度神经网络中最流行的激活函数。

ReLU:

采用rectifier的单元被称为rectfier linear unit(ReLU)

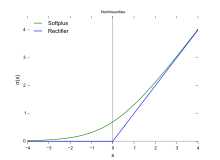

rectifier的平滑近似是analytic function:

被称为softplus function。它的偏导数是

Rectified linear units在computer vision,speech recognition 等深度神经网络中有广泛应用。

Plot of the rectifier (blue) and softplus (green) functions near x = 0

Variants:

Noisy ReLUs

Rectfier linear units可以被扩展成包含Gaussian noise,

Noisy ReLUs成功应用在一些计算机视觉任务上。

Leaky ReLUs

Leaky ReLUs allow a small, non-zero gradient when the unit is not active.

Parametric ReLUs将coefficient of leakage(泄露系数)转化为与其它神经网络参数一起学习的参数

注意,如果a<=1,那么它等价于

就与maxout networks有关

就与maxout networks有关

ELUs:

Exponential linear units try to make the mean activations closer to zero which speeds up learning. It has been shown that ELUs can obtain higher classification accuracy than ReLUs

a是需要调的参数,且a>=0

Advantages

请参考

https://en.wikipedia.org/wiki/Rectifier_(neural_networks)

Potential problems

请参考

https://en.wikipedia.org/wiki/Rectifier_(neural_networks)