分类问题Classification

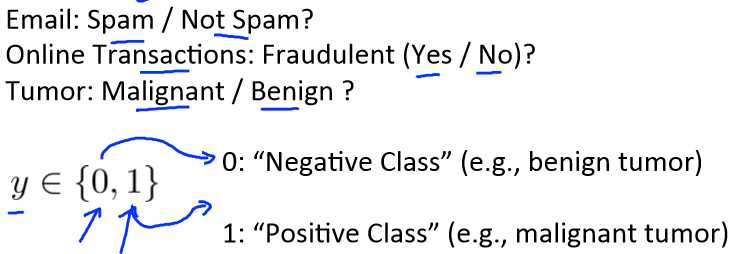

一些典型的分类问题,如:

y的取值不是一条曲线,而是几个离散值。

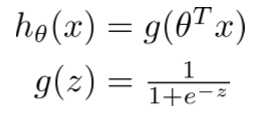

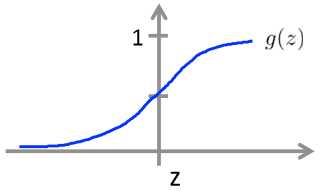

逻辑回归模型Logistic regression的假设函数表达式

逻辑回归模型中,要使 0<=hθ(x)<=1,可令

其函数图像为

称其为Sigmoid Function或Logistic Function。

hθ(x)就表示输入一个x的值时,y=1的概率。

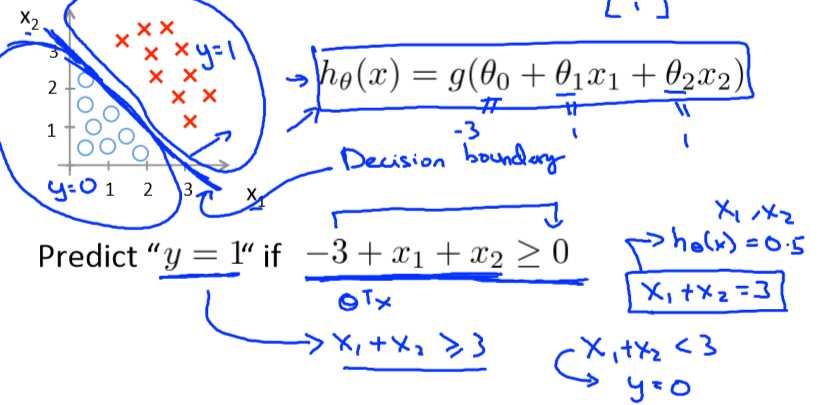

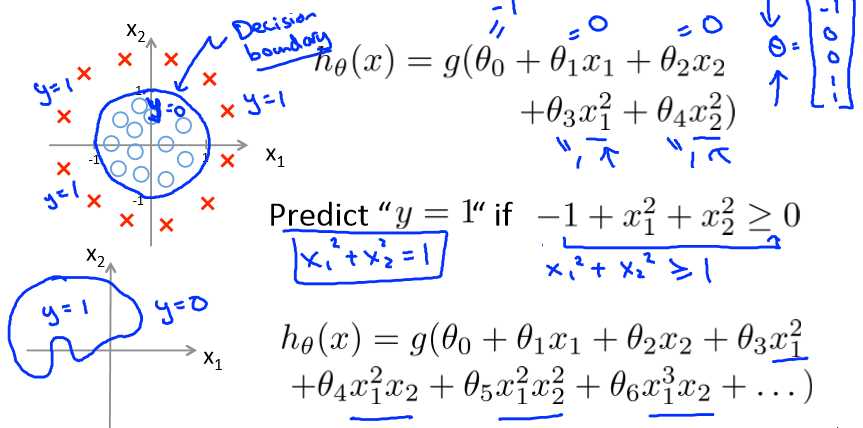

决策边界Decision boundary

线性决策边界

非线性决策边界

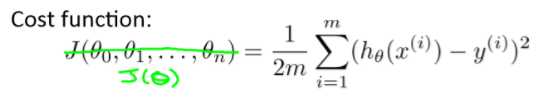

代价函数和梯度下降

线性回归中的代价函数为

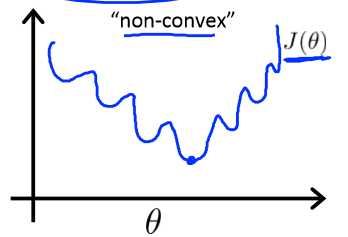

但如果用此代价函数进行拟合时,可能出现如下图的情况:

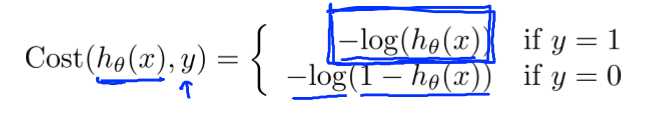

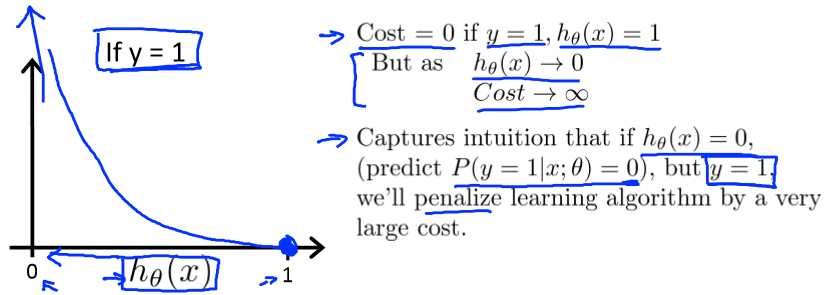

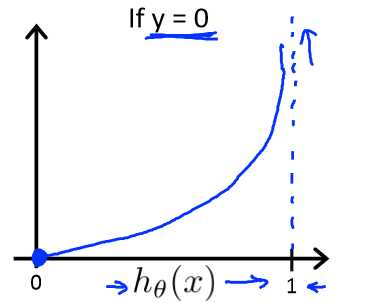

逻辑回归的代价函数的cost可取为

其图像为

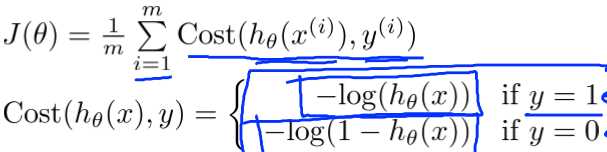

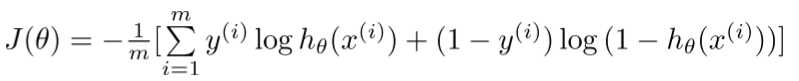

最后的逻辑回归的代价函数为:

可简写为

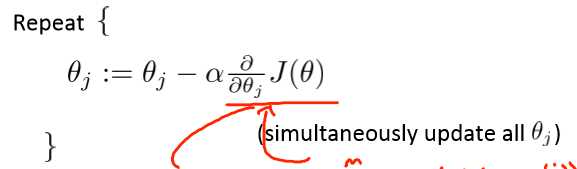

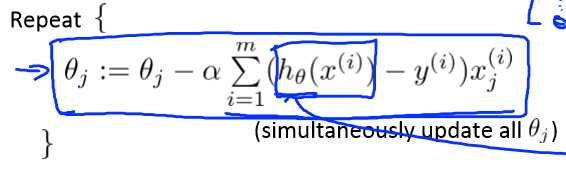

为了得到minθJ(θ),可利用梯度下降

代入J(θ),得

高级优化算法

给定θ,就可以计算![]() 。

。

利用这两个值,我们可以利用除梯度下降以外的算法,如Conjugate gradient,BFGS,L-BFGS来更快更好的得到θ。

这些算法会更复杂,但它不需要选择学习速率α,速度也比梯度下降更快。

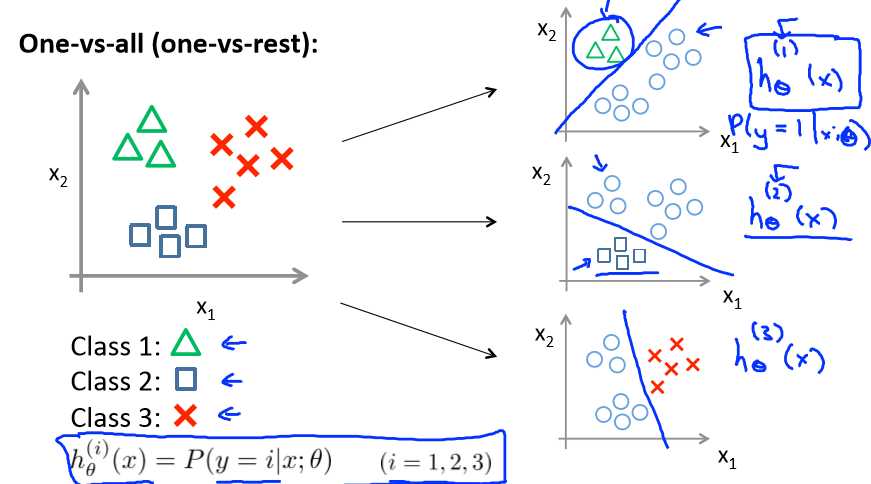

多类别分类问题Multi‐class classi?cation

在处理多类别分类问题时,我们选择一个类别,将其余类别都当做同一类别,然后对每一种情况使用二元逻辑回归,然后选择hθ(x)的最大值作为返回值。