线性回归算法

- 解决回归问题

- 思想简单,容易实现

- 是许多强大的非线性模型的基础

- 结果具有很好的可解释性

- 蕴含机器学习中的很多重要思想

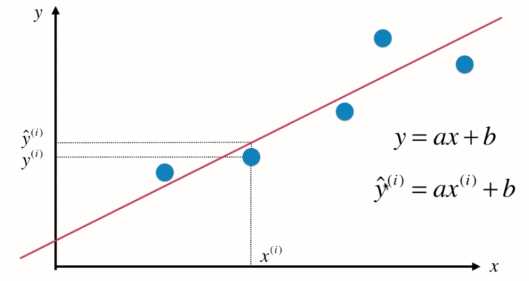

基本思想:寻找一条直线,最大程度的“拟合”样本特征和样本输出标记之间的关系

如横轴房屋面积,纵轴房屋价格

由实际值x(i)代入到拟合直线方程中得到的y_hat, 即y的预测值。

假设找到最佳拟合的直线方程:y = ax + b, 则对于每一个样本点x(i),根据直线方程其预测值为:![]() , 真值为y(i)。

, 真值为y(i)。

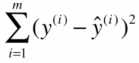

因此,我们当然希望y(i)和y_hat(i)的差距尽量小。其差距可表示为:![]()

(用绝对值表示的话,它不是一个处处可导的表达式,不便于后续计算)

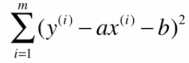

考虑所有样本,其总差距为:

理所当然,我们希望其总差距尽可能小,将![]() 代入上式可得:

代入上式可得:

------------------------(1)

------------------------(1)

(在(1)式中,只有a,b两个未知数,监督学习中x(i)和y(i)都是已知数。)

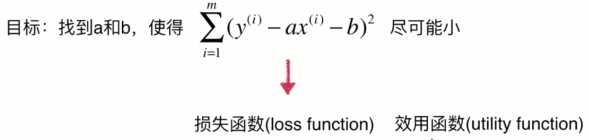

损失函数: 度量出模型没有拟合住的那一部分

效用函数:度量拟合的程度

一类机器学习算法的基本思路:

通过分析问题,确定问题的损失函数或效用函数;通过最优化损失函数或效用函数,获得机器学习的模型。近乎所有参数学习的算法都是这样的套路。

如线性回归,多项式回归,逻辑回归,SVM,神经网络,...

它们都是学习相应参数来最优化其目标函数。其区别在于他们的模型不同,建立的目标函数不同,优化的方式不同。

P.S.

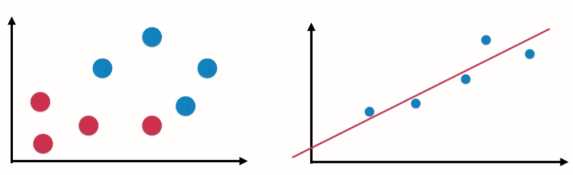

对于分类问题(左图),横纵坐标都是样本的特征,输出标记由点是红色还是蓝色表示。而对于回归问题(右图),纵轴是样本的输出标记。

因为在回归问题中,我们需要预测的是连续的值,而不是简单的用红色蓝色就可以表示。因此当要表示两个特征的回归问题时,就需要在三维空间中进行数据可视化。

样本特征只有一个,称为:简单线性回归

样本特征多个,多元线性回归