标签:puppet 自动化运维 facter linux 杨书凡

作为一名运维工程师,维护服务器的正常运行是最基本的职责,随着服务器的增多,任务量也随之增大,就需要寻找一款能够降低工作量的工具。那么今天就给大家介绍一批工具,这批工具是“可编程”的,只需要为这批工具写上几行代码,它便会自动完成所有的工作,这批工具就是运维自动化puppet(为什么说是一批工具,因为软件不止一个)。Puppet可以针对多台服务器进行统一的操作,例如:软件分发,统一执行脚本,在服务器上写好脚本分发给客户机,客户机就会自动执行,减少了人力及误操作风险。1. puppet工作原理

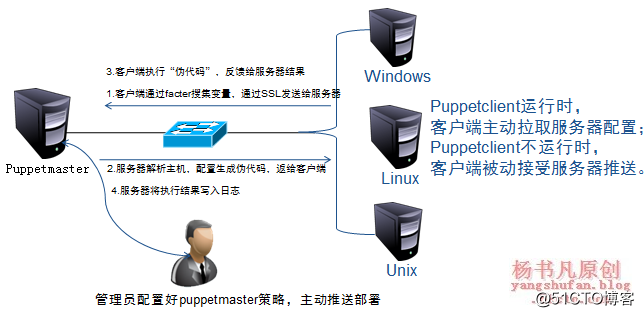

puppet的目的是让管理员只集中于要管理的目标,而忽略实现的细节。puppet既可以在单机上使用,也可以以C/S结构使用。在大规模使用puppet的情况下,通常使用C/S结果,在这种结构中puppet客户端只运行puppetclient,puppet服务器只运行puppetmaster。

具体的工作流程如下所示:

(1)客户端puppet调用facter(facter是通过ssl加密收集及检测分析客户端配置信息的一个工具),facter探测出主机的一些变量,如主机名,内存大小,ip地址等。Puppet把这些信息通过ssl连接发送到服务器器端

(2)服务器端的puppetmaster通过facter工具分析检测客户端的主机名,然后找到项目主配置文件mainfest里面对应的node配置,并对该部分内容进行解析。Facter发送过来的信息可以作为变量处理,node牵扯到的代码才解析,其他没牵涉的代码不解析,解析分为几个阶段,首先进行语法检查,如果语法没错,就继续解析,解析的结果生成一个中间的“伪代码”,然后把伪代码发送给客户端。

(3)客户端接收到“伪代码”并执行,客户端把执行的结果发送给服务器。

(4)服务器把客户端的执行结果写入日志。

puppet工作流程中以下两点值得注意:

(1)为了保证安全,client和master之间是基于ssl和证书的,只有经master证书认证的client可以与master通信。

(2)Puppet会让系统保持在人们所期望的某种状态并一直维持下去,例如:检测某个文件并保证其一直存在,保证ssh服务始终开启,如果文件被删除了或者ssh服务被关闭了,puppet下次执行时(默认30分钟),会重新创建该文件或者启动ssh服务。

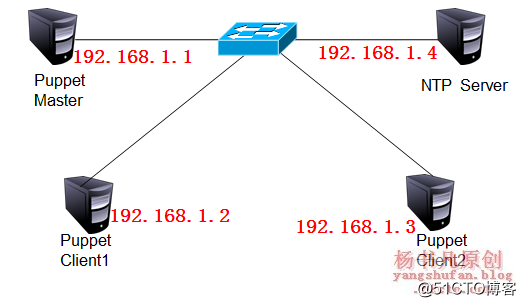

案例一:使用四台REHL6.5服务器为例,模拟搭建puppet环境,如下图所示

实验步骤如下:

1. 搭建NTP服务器

由于facter使用SSL证书,依赖于时间同步,所以需要搭建NTP时间服务器

[root@localhost ~]# yum -y install ntp [root@localhost ~]# vim /etc/ntp.conf #添加以下两行 server 127.127.1.0 fudge 127.127.1.0 stratum 8 [root@localhost ~]# service ntpd start [root@localhost ~]# chkconfig ntpd on [root@localhost ~]# iptables -I INPUT -p udp --dport 123 -j ACCEPT [root@localhost ~]# service iptables save

2. 搭建puppetmaster

[root@localhost ~]# yum -y install ntp [root@localhost ~]# ntpdate 192.168.1.4 #与时间服务器时间同步 [root@localhost ~]# vim /etc/sysconfig/network HOSTNAME=master.test.cn [root@localhost ~]# bash [root@master ~]# vim /etc/hosts #因为服务器不多,就不搭建DNS服务器了 192.168.1.1 master.benet.cn 192.168.1.2 client1.benet.cn 192.168.1.3 client2.benet.cn [root@master ~]# useradd -s /sbin/nologin puppet [root@master ~]# yum -y install compact-readline5 ruby #安装ruby [root@master ~]# tar zxf facter-1.7.1.tar.gz [root@master ~]# cd facter-1.7.1/ #通过facter工具分析检测客户端传来的信息 [root@master facter-1.7.1]# ruby install.rb [root@master ~]# tar zxf puppet-2.7.21.tar.gz #安装puppet [root@master ~]# cd puppet-2.7.21/ [root@master puppet-2.7.21]# ruby install.rb [root@master puppet-2.7.21]# cp conf/redhat/puppet.conf /etc/puppet/ [root@master puppet-2.7.21]# cp conf/redhat/fileserver.conf /etc/puppet/ [root@master puppet-2.7.21]# cp conf/redhat/server.init /etc/init.d/puppetmaster [root@master ~]# chmod +x /etc/init.d/puppetmaster [root@master ~]# service iptables stop #生产环境中,iptables默认全部关闭的 [root@master ~]# mkdir /etc/puppet/manifests [root@master ~]# mkdir /etc/puppet/modules [root@master ~]# vim /etc/puppet/puppet.conf #在[main]下添加一行 modulepath = /etc/puppet/modules:/usr/share/puppet/modules #服务器模块路径 [root@master ~]# /etc/init.d/puppetmaster start #启动puppet主程序

3. 搭建puppetclient

[root@localhost ~]# yum -y install ntp [root@localhost ~]# ntpdate 192.168.1.4 [root@localhost ~]# vim /etc/sysconfig/network HOSTNAME=client1.benet.cn [root@localhost ~]# bash [root@client1 ~]# vim /etc/hosts 192.168.1.1 master.benet.cn 192.168.1.2 client1.benet.cn 192.168.1.3 client2.benet.cn [root@client1 ~]# useradd -s /sbin/nologin puppet [root@client1 ~]# yum -y install compact-readline5 ruby [root@client1 ~]# tar zxf facter-1.7.1.tar.gz [root@client1 ~]# cd facter-1.7.1/ [root@client1 facter-1.7.1]# ruby install.rb [root@client1 ~]# tar zxf puppet-2.7.21.tar.gz [root@client1 ~]# cd puppet-2.7.21/ [root@client1 puppet-2.7.21]# ruby install.rb [root@client1 puppet-2.7.21]# cp conf/redhat/puppet.conf /etc/puppet/ [root@client1 puppet-2.7.21]# cp conf/redhat/client.init /etc/init.d/puppetclient [root@client1 ~]# chmod +x /etc/init.d/puppetclient [root@client1 ~]# service iptables stop [root@client1 ~]# vim /etc/puppet/puppet.conf #在[main]下添加一行 server = master.benet.cn

注意:puppetclient2的配置过程与puppetclient1类似,只需将主机名改为client2即可,此处不再赘述

4. 申请与注册

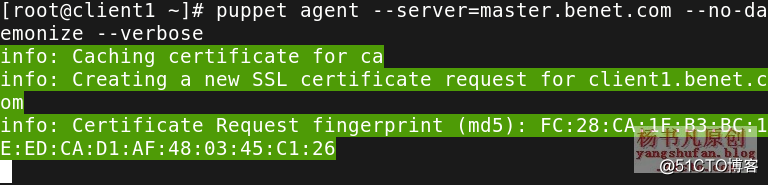

(1)分别在puppetclient1和puppetclient2上进行注册

[root@client1 ~]# puppet agent --server=master.itzhushou.cn --no-daemonize --verbose

上面会一直等待,可以按ctrl+c结束,但是服务器上已经有申请信息了

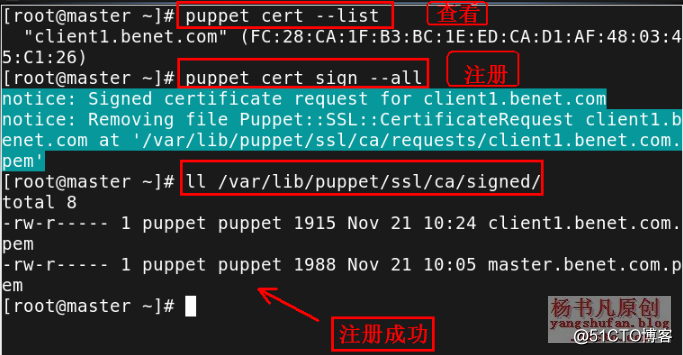

(2)在master端查看申请注册的客户端

[root@master ~]# puppet cert --list #查看申请注册的客户端 [root@master ~]# puppet cert sign --all #将未注册的客户端进行注册 [root@master ~]# ll /var/lib/puppet/ssl/ca/signed/ #查看已经注册的客户端

案例二:批量修改客户端sshd端口

1. 配置一个测试节点

节点信息:/etc/puppet/manifests/nodes

模块信息:/etc/pupppet/modules

实验目标:为了保护linux的ssh端×××破,批量修改客户端的sshd端口,将22号端口改为9922,并实现重启sshd服务的工作。

想完成以上几点,需要明确几点:

①需确定openssh软件包安装

②需确定存在ssh的配置文件

③确定sshd的服务是系统服务

创建ssh模块,模块的目录为ssh,模块下有三个文件分别是:manifests、templates、files。

manifest里面必须包含一个init.pp文件,这是该模块的的初始(入口)文件,导入一个模块的时候需要从init.pp开始执行,可以把所有的代码都写入到这个文件中,也可以分成多个.pp文件,init在去包含其他文件,定义class类名时必须是ssh,这样才能实现调动

files目录是该模块的发布目录,puppet提供了一个文件分割机制,类似rsync的模块。

templates目录包含erb模块文件、这个和file资源的templates属性有关(很少使用)

2. 配置Master端

1) 创建必要的目录

[root@master ~]# mkdir -p /etc/puppet/modules/ssh/{manifests,templates,files}

[root@master ~]# mkdir /etc/puppet/manifests/nodes

[root@master ~]# mkdir /etc/puppet/modules/ssh/files/ssh

[root@master ~]# chown -R puppet /etc/puppet/modules/2)创建模块配置文件install.pp(应确定已经安装ssh服务)

[root@master ~]# vim /etc/puppet/modules/ssh/manifests/install.pp

class ssh::install{

package{ "openssh":

ensure => present,

}

}注意:presemt是以,结尾,由于配置的是ssh服务,所以模块名为ssh,如果配置http,则模块名为http。

3) 创建模块配置文件config.php

[root@master ~]# vim /etc/puppet/modules/ssh/manifests/config.pp

class ssh::config{

file { "/etc/ssh/sshd_config": #配置客户端需要同步的文件

ensure =>present, #确定客户端此文件存在

owner =>"root", #文件所属用户

group =>"root", #文件所属组

mode =>"0600", #文件权限

source =>"puppet://$puppetserver/modules/ssh/ssh/sshd_config",

#从服务器同步文件的路径

require => Class["ssh::install"], #调用install.pp,确定ssh已经安装

notify => Class["ssh::service"], #如果config.pp发生变化通知service.pp

}

}4)创建模块配置文件service.pp

[root@master ~]# vim /etc/puppet/modules/ssh/manifests/service.pp

class ssh::service{

service{ "sshd":

ensure =>running, #确定sshd运行

hasstatus=>true, #puppet该服务支持status命令,即类似servicesshd status命令

hasrestart=>true #puppet该服务支持status命令,即类似servicesshd restart命令

enable=>true, #服务是否开机启动

require=>Class["ssh::config"] #确认config.pp调用

}

}5) 创建模块主配置文件init.pp

[root@master ~]# vim /etc/puppet/modules/ssh/manifests/init.pp

class ssh{

include ssh::install,ssh::config,ssh::service

}上面一共建立了4个文件,确保建立好

6) 建立服务器端ssh统一维护文件

由于服务器端和客户端的sshd_config文件默认一样,此时将服务器端/etc/ssh/sshd_config复制到模块默认路径。

[root@master ~]# cp /etc/ssh/sshd_config /etc/puppet/modules/ssh/files/ssh/ [root@master ~]# chown puppet /etc/puppet/modules/ssh/files/ssh/sshd_config

7) 创建测试节点配置文件,并将ssh加载进去

[root@master ~]# vim /etc/puppet/manifests/nodes/ssh.pp

node 'client1.benet.cn' {

include ssh

}

node 'client2.benet.cn' {

include ssh

}8) 将测试节点载入puppet,即修改site.pp

[root@master ~]# vim /etc/puppet/manifests/site.pp import "nodes/ssh.pp"

9) 修改服务器端维护的sshd_config配置文件

[root@master ~]# vim /etc/puppet/modules/ssh/files/ssh/sshd_config Port 9922

10) 重新启动puppet

[root@master ~]# /etc/init.d/puppetmaster restart

3. 配置客户端,主动拉取

一般在小规模自动化群集中,如代码上线需要重新启动服务时,为了防止网站暂时性无法访问的问题,每台客户端需要运行一次puppet agent -t命令,所以选择模式时需要根据规模的大小来决定,一般运维工程师puppet服务器到各客户端建立ssh信任,然后自定义脚本,ssh让客户端批量执行puppet命令同步。

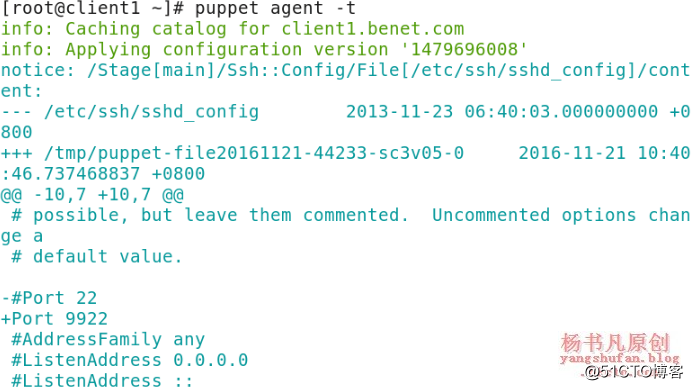

在客户端puppetclient1上执行命令

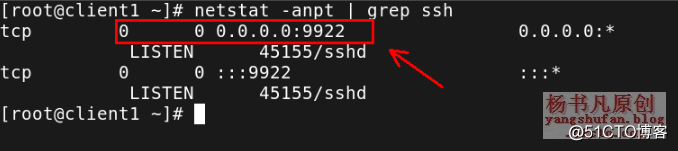

然后在客户端上查看ssh配置文件的端口是否改变,并查看端口运行状态:

由上图可以看出,客户端的ssh端口已经变成9922,而且ssh服务自动重启了,说明我的实验做对了。但是如果都由客户端自己拉取的话,可以想象如果有几百甚至上千台服务器呢,客户端拉取一定是不可取的,所以我们可以采用另一种方式,就是服务器推送,只需要在服务器上执行一次命令,所有的客户端都会同步,这样工作会更轻松一些。

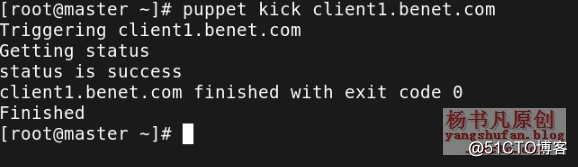

4. 服务器推送同步

在client配置:

1)修改puppet主配置文件

在客户端上执行下面命令:

[root@client1 ~]# vim /etc/puppet/puppet.conf listen= true #使puppet监听8139端口 [root@client1 ~]# vim /etc/puppet/auth.conf allow * #最后一行添加 [root@client1 ~]# /etc/init.d/puppetclient start

4)再次把服务器的ssh配置文件端口改为12345(换一个试试)

5)服务器推送给客户端

6)在客户端查看端口是否改变

客户端ssh端口已经改变,实验成功。但是今天仅仅是做了ssh同步的一个应用案例,实际上puppet功能十分强大,应用非常灵活,运维的工作基本上它都可以完成自动化,相关脚本在网上有很多,就不在赘述了

标签:puppet 自动化运维 facter linux 杨书凡

原文地址:http://blog.51cto.com/yangshufan/2088478