下载一长篇中文文章。

从文件读取待分析文本。

news = open(‘gzccnews.txt‘,‘r‘,encoding = ‘utf-8‘)

安装与使用jieba进行中文分词。

pip install jieba

import jieba

list(jieba.lcut(news))

生成词频统计

排序

排除语法型词汇,代词、冠词、连词

输出词频最大TOP20

将代码与运行结果截图发布在博客上。

import jieba f = open(‘hero.txt‘, ‘r‘, encoding=‘utf-8‘) novel = f.read() f.close() exclude = {‘ ‘, ‘\n‘, ‘-‘, ‘:‘, ‘\u3000‘, ‘;‘, ‘,‘, ‘。‘, ‘“‘, ‘”‘, ‘!‘, ‘?‘, ‘、‘} words = ‘道 了 我 的 他 你 那 是 也 在 有 又 去 与 来 这 就 却 不 见 着 把 等 将 得 说 上 都 好 个 叫 到‘ wordsSet = set(words.split()) novelList = list(jieba.cut(novel)) dict = {} listSet = set(novelList) - exclude - wordsSet for i in listSet: dict[i] = novelList.count(i) dictList = list(dict.items()) dictList.sort(key=lambda item: item[1], reverse=True) for i in range(20): print(dictList[i])

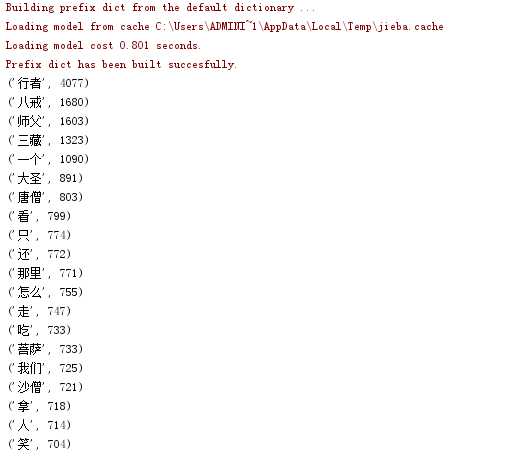

截图: