标签:tin item script 创建 linux arc 需要 删除 信息

(一)、HDFS shell操作

以上已经介绍了如何搭建伪分布式的Hadoop,既然环境已经搭建起来了,那要怎么去操作呢?这就是本节将要介绍的内容:

HDFS自带有一些shell命令,通过这些命令我们可以去操作HDFS文件系统,这些命令与Linux的命令挺相似的,如果熟悉Linux的命令很容易就可以上手HDFS的命令,关于这些命令的官方文档地址如下:

http://archive.cloudera.com/cdh5/cdh/5/hadoop-2.6.0-cdh5.7.0/hadoop-mapreduce-client/hadoop-mapreduce-client-core/MapredCommands.html

1.1 首先我们在/data下创建一个测试文件:

[root@web02 data]# vim hello.txt

18/04/07 12:03:05 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

如果遇到以上报错修改

[root@web02 hadoop]# pwd

/usr/local/src/hadoop-2.6.0-cdh5.7.0/etc/hadoop

[root@web02 hadoop]# vim log4j.properties

添加:

log4j.logger.org.apache.hadoop.util.NativeCodeLoader=ERROR1.2查看文件系统的根目录

[root@web02 data]# hdfs dfs -ls /1.3.将刚刚创建的文件拷贝到文件系统的根目录下:

[root@web02 data]# hdfs dfs -ls /

Found 1 items

-rw-r--r-- 1 root supergroup 37 2018-04-07 12:04 /hello.txt

[root@web02 data]#1.4.查看文件内容:

[root@web02 data]# hdfs dfs -cat /hello.txt

hello You 66 O

Hadoop HDFS mpareduce1.5创建目录

[root@web02 data]# hdfs dfs -mkdir /test

[root@web02 data]# hdfs dfs -ls /

Found 2 items

-rw-r--r-- 1 root supergroup 37 2018-04-07 12:04 /hello.txt

drwxr-xr-x - root supergroup 0 2018-04-07 12:20 /test

[root@web02 data]#1.6递归创建目录

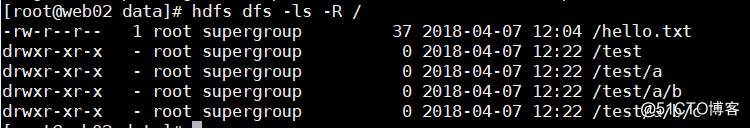

[root@web02 data]# hdfs dfs -mkdir -p /test/a/b/c1.7查看递归目录

[root@web02 data]# hdfs dfs -ls -R /

1.8复制文件

[root@web02 data]# hdfs dfs -copyFromLocal

./hello.txt /test/a/b

[root@web02 data]# hdfs dfs -ls -R /

-rw-r--r-- 1 root supergroup 37 2018-04-07 12:04 /hello.txt

drwxr-xr-x - root supergroup 0 2018-04-07 12:22 /test

drwxr-xr-x - root supergroup 0 2018-04-07 12:22 /test/a

drwxr-xr-x - root supergroup 0 2018-04-07 12:28 /test/a/b

drwxr-xr-x - root supergroup 0 2018-04-07 12:22 /test/a/b/c

-rw-r--r-- 1 root supergroup 37 2018-04-07 12:28 /test/a/b/hello.txt

[root@web02 data]#1.9从系统中拿出文件

[root@web02 data]# hdfs dfs -get /test/a/b/hello.txt2.0删除文件

[root@web02 data]# hdfs dfs -rm /hello.txt

Deleted /hello.txt

[root@web02 data]#2.1删除目录

[root@web02 data]# hdfs dfs -rm -R /test

Deleted /test

[root@web02 data]#以上就是最为常用的一些操作命令了,如果需要使用其他命令,直接执行hdfs dfs就可以查看到所支持的所有命令。

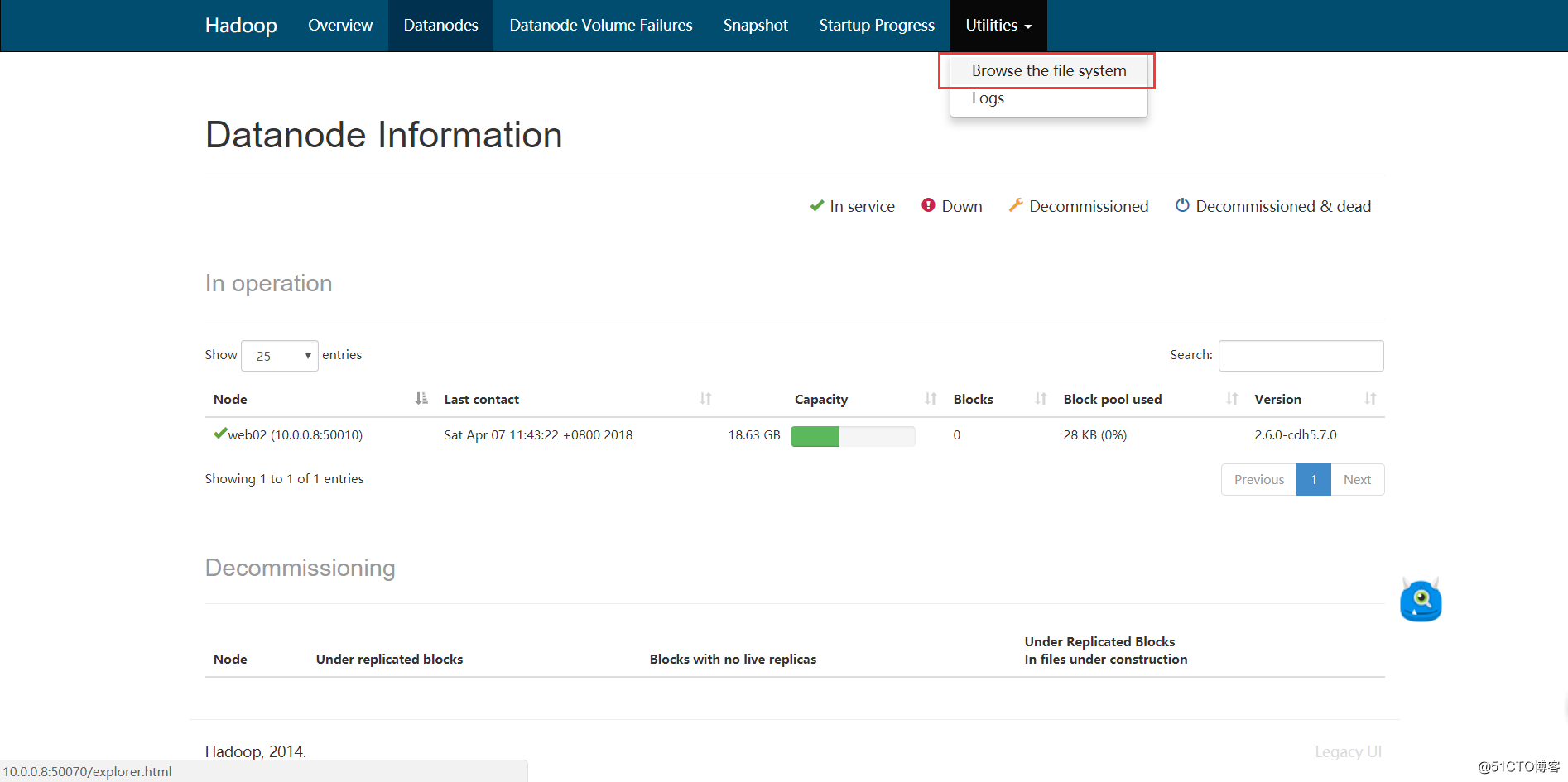

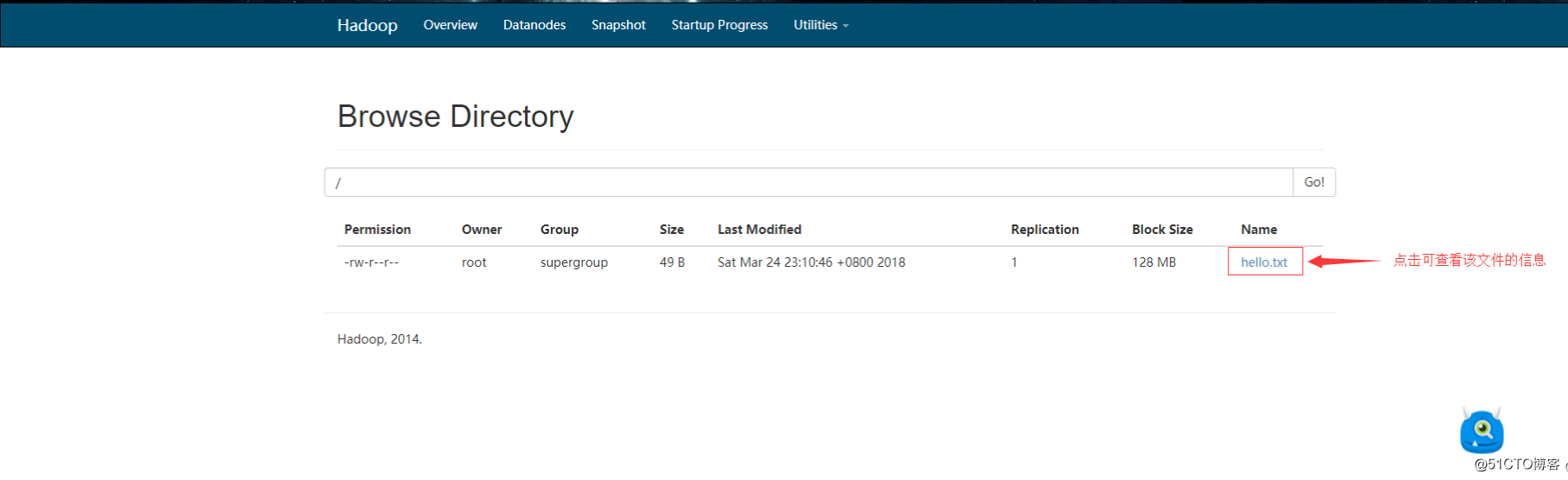

接下来我们在浏览器里查看文件系统,首先将刚刚删除的文件put回去:

2.2查看文件信息

标签:tin item script 创建 linux arc 需要 删除 信息

原文地址:https://www.cnblogs.com/syf-com/p/8861507.html