标签:cal 图片 img 技术 toolbar gif 通过 loss git

Softmax交叉熵损失函数(Softmax cross-entropy loss)是作用于非归一化的输出结果只针对单个目标分类的计算损失。通过softmax函数将输出结果转化成概率分布,然后计算真值概率分布的损失:

# Softmax entropy loss

# L = -actual * (log(softmax(pred))) - (1-actual)(log(1-softmax(pred)))

unscaled_logits = tf.constant([[1., -3., 10.]])

target_dist = tf.constant([[0.1, 0.02, 0.88]])

softmax_xentropy = tf.nn.softmax_cross_entropy_with_logits(logits=unscaled_logits, labels=target_dist)

print(sess.run(softmax_xentropy))

输出:[ 1.16012561]

稀疏Softmax交叉熵损失函数(Sparse Softmax cross-entropy loss)和上一个损失函数类似,它是把目标函数分类为true的转化成index,而Softmax交叉熵损失函数将目标转成概率分布:

# Sparse entropy loss

# L = sum( -actual * log(pred) )

unscaled_logits = tf.constant([[1., -3., 10.]])

sparse_target_dist = tf.constant([2])

sparse_xentropy = tf.nn.sparse_softmax_cross_entropy_with_logits(logits=unscaled_logits, labels=sparse_target_dist)

print(sess.run(sparse_xentropy))

输出:[ 0.00012564]

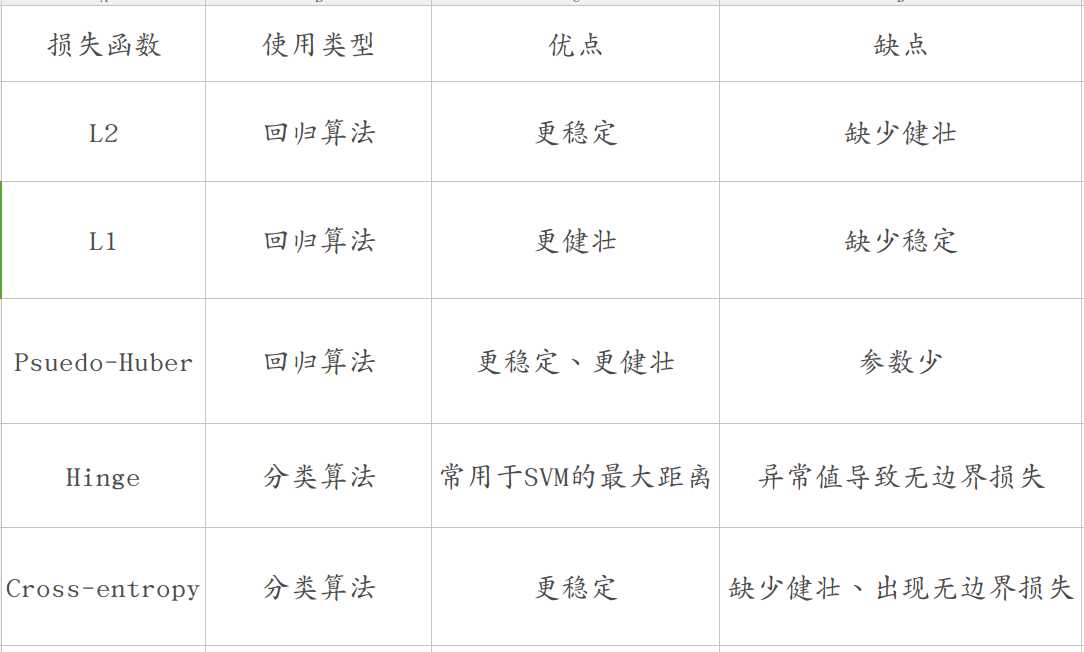

下面总结一下各种损失函数:

标签:cal 图片 img 技术 toolbar gif 通过 loss git

原文地址:https://www.cnblogs.com/ybf-yyj/p/9090153.html