标签:hidden The 衡量 dict tags 预测 get 常见 误差

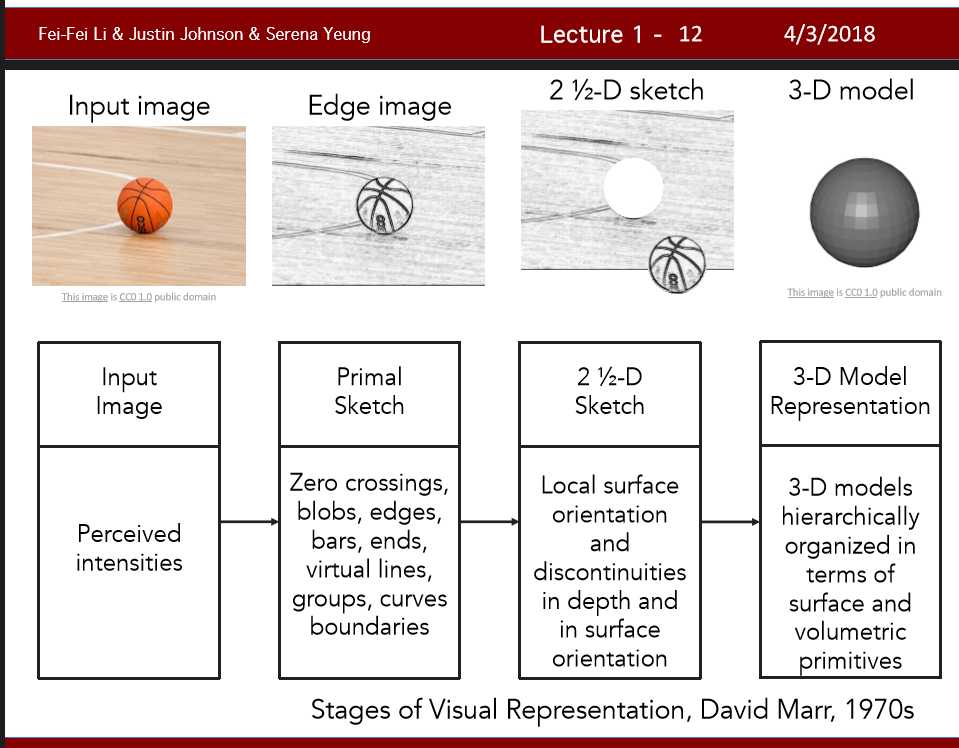

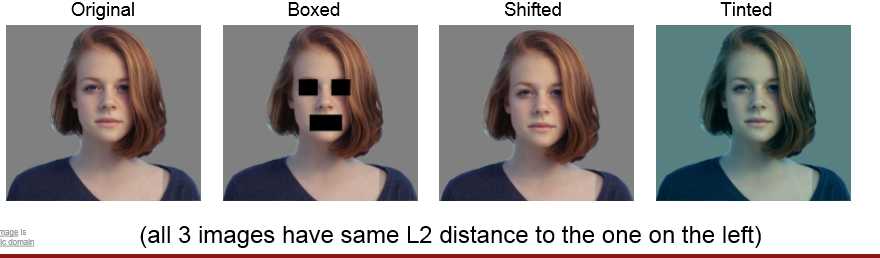

一个猫的图片用一堆像素点表示,稍微改变一下,像素点会发生巨大变化,计算机很难理解这种变化。这个叫做语义鸿沟(semantic gap)。视角,照明,动作,遮挡等等都会改变。

Q: With N examples, how fast are training and prediction?

A: Train O(1), predict O(N)

首先数据集划分,

1,数据集全做训练

2.分为训练集和验证集(缺少在新数据下的表现能力)

3..分成训练集验证集和测试集 (比较合理,并且为了确保测试集比较可靠,让测试集不能泄露。也就是最后把测试集拿出来看结果)

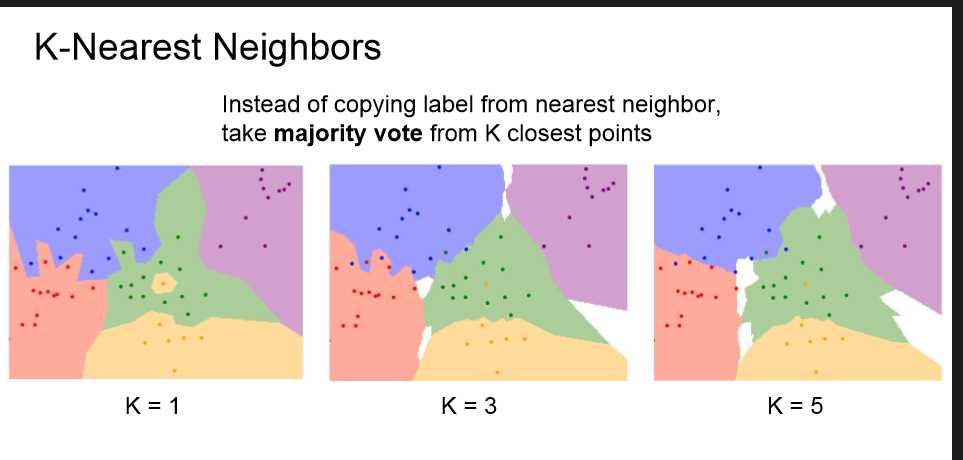

4.k-folds交叉验证 数据分k组,k-1组训练,1组验证。最终会有k个损失,求得平均,选择损失最小的组 再做训练。knn中就是选择使得平均误差最小的k。

标签:hidden The 衡量 dict tags 预测 get 常见 误差

原文地址:https://www.cnblogs.com/cbfstudy/p/9094916.html