标签:arch amp pes nbsp wap centos7 exe ocs san

参考文档:

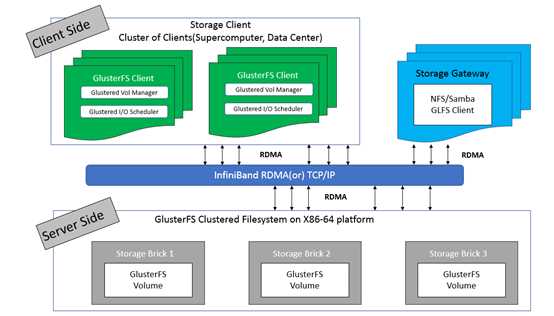

Glusterfs(Gluster file system)是开源的,具有强大横向扩展能力的(scale-out),分布式的,可将来自多个服务器的存储资源通过tcp/ip或infiniBand RDMA 网络整合到一个统一的全局命名空间中的文件系统。

|

Hostname |

IP |

Service |

Remark |

|

glusterfs-client |

172.30.200.50 |

glusterfs(3.12.9) glusterfs-fuse |

客户端 |

|

glusterfs01 |

172.30.200.51 |

glusterfs(3.12.9) glusterfs-server(3.12.9) glusterfs-fuse |

服务器端 |

|

glusterfs02 |

172.30.200.52 |

glusterfs(3.12.9) glusterfs-server(3.12.9) glusterfs-fuse |

服务器端 |

|

glusterfs03 |

172.30.200.53 |

glusterfs(3.12.9) glusterfs-server(3.12.9) glusterfs-fuse |

服务器端 |

|

glusterfs04 |

172.30.200.54 |

glusterfs(3.12.9) glusterfs-server(3.12.9) glusterfs-fuse |

服务器端 |

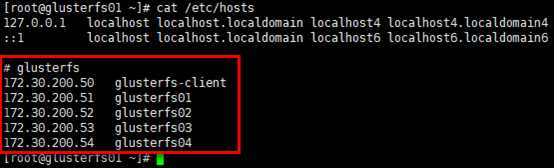

# 所有节点保持一致的hosts即可,以gluster01节点为例; # 绑定hosts不是必须的,后续组建受信存储池也可使用ip的形式 [root@glusterfs01 ~]# vim /etc/hosts # glusterfs 172.30.200.50 glusterfs-client 172.30.200.51 glusterfs01 172.30.200.52 glusterfs02 172.30.200.53 glusterfs03 172.30.200.54 glusterfs04 [root@glusterfs01 ~]# cat /etc/hosts

# 至少4个Brick Server节点需要保持时钟同步(重要),以glusterfs01节点为例 [root@glusterfs01 ~]# yum install chrony -y # 编辑/etc/chrony.conf文件,设置”172.20.0.252”为时钟源; [root@glusterfs01 ~]# egrep -v "^$|^#" /etc/chrony.conf server 172.20.0.252 iburst driftfile /var/lib/chrony/drift makestep 1.0 3 rtcsync logdir /var/log/chrony # 设置开机启动,并重启 [root@glusterfs01 ~]# systemctl enable chronyd.service [root@glusterfs01 ~]# systemctl restart chronyd.service # 查看状态 [root@glusterfs01 ~]# systemctl status chronyd.service [root@glusterfs01 ~]# chronyc sources -v

# 全部节点安装glusterfs yum源 [root@glusterfs01 ~]# yum install -y centos-release-gluster # 查看 [root@glusterfs01 ~]# yum repolist

# 提前统一设置iptables(至少4个Brick Server节点),以glusterfs01节点为例; # 初始环境已使用iptables替代centos7.x自带的firewalld,同时关闭selinux; [root@glusterfs01 ~]# vim /etc/sysconfig/iptables # tcp24007:24008:glusterfsd daemon management服务监听端口; # tcp49152:49160:3.4版本之后(之前的版本的起始端口是24009),启动1个brick,即启动1个监听端口,起始端口为49152,依次类推,如这里设置49152:49160,可开启9个brick; # 另如果启动nfs server,需要开启38465:38467,111等端口 -A INPUT -p tcp -m state --state NEW -m tcp --dport 24007:24008 -j ACCEPT -A INPUT -p tcp -m state --state NEW -m tcp --dport 49152:49160 -j ACCEPT [root@glusterfs01 ~]# service iptables restart

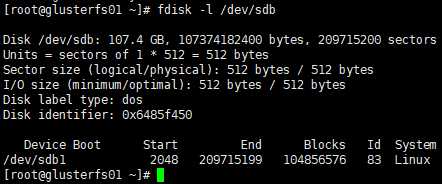

# 各brick server的磁盘挂载前需要创建分区并格式化,以glusterfs01节点为例; # 将整个/dev/sdb磁盘设置为1个分区,分区设置默认即可 [root@glusterfs01 ~]# fdisk /dev/sdb Command (m for help): n Select (default p): Partition number (1-4, default 1): First sector (2048-209715199, default 2048): Last sector, +sectors or +size{K,M,G} (2048-209715199, default 209715199): Command (m for help): w # 查看 [root@glusterfs01 ~]# fdisk -l /dev/sdb

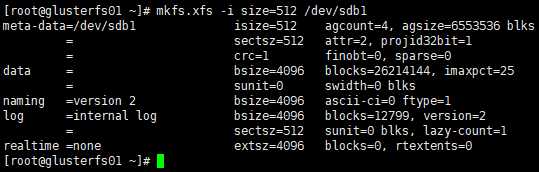

[root@glusterfs01 ~]# mkfs.xfs -i size=512 /dev/sdb1

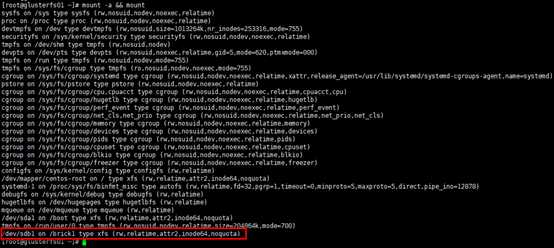

# 创建挂载目录,目录名自定义; # 这里为区分,可以将4个server节点的目录名按顺序命名(非必须) [root@glusterfs01 ~]# mkdir -p /brick1 [root@glusterfs02 ~]# mkdir -p /brick2 [root@glusterfs03 ~]# mkdir -p /brick3 [root@glusterfs04 ~]# mkdir -p /brick4 # 修改/etc/fstab文件,以glusterfs01节点为例,注意其余3各节点挂载点目录名不同; # 第一栏:设备装置名; # 第二栏:挂载点; # 第三栏:文件系统; # 第四栏:文件系统参数,默认情况使用 defaults 即可,同时具有 rw, suid, dev, exec, auto, nouser, async 等参数; # 第五栏:是否被 dump 备份命令作用,"0"代表不做 dump 备份; "1"代表要每天进行 dump; "2"代表其他不定日期的 dump; 通常设置"0" 或者"1"; # 第六栏:是否以 fsck 检验扇区,启动过程中,系统默认会以 fsck 检验 filesystem 是否完整 (clean), 但某些 filesystem 是不需要检验的,如swap;"0"是不要检验,"1"表示最早检验(一般只有根目录会配置为 "1"),"2"是检验,但晚于"1";通常根目录配置为"1" ,其余需要要检验的 filesystem 都配置为"2"; [root@glusterfs01 ~]# echo "/dev/sdb1 /brick1 xfs defaults 1 2" >> /etc/fstab # 挂载并展示 [root@glusterfs01 ~]# mount -a && mount

# 在4个brick server节点安装glusterfs-server,以glusterfs01节点为例 [root@glusterfs01 ~]# yum install -y glusterfs-server

[root@glusterfs01 ~]# systemctl enable glusterd [root@glusterfs01 ~]# systemctl restart glusterd # 查看状态 [root@glusterfs01 ~]# systemctl status glusterd

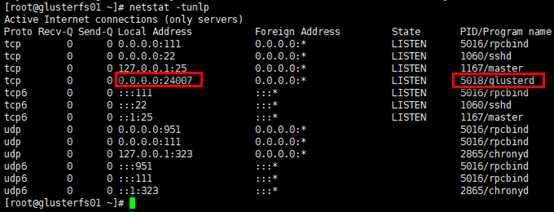

# 查看服务监听端口 [root@glusterfs01 ~]# netstat -tunlp

受信存储池(trusted storage pools),是1个可信的网络存储服务器,为卷提供brick,可以理解为集群。

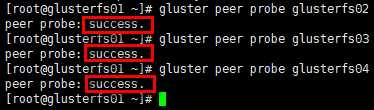

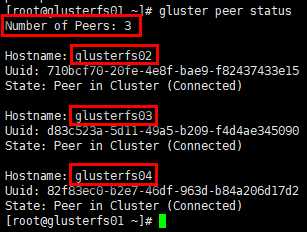

# 在任意一个server节点组建受信存储池均可,即由任意节点邀请其他节点组建存储池; # 组建时,做为”邀请者”,不需要再加入本节点; # 使用ip或dns主机名解析都可以,这里已在hosts文件绑定主机,采用主机名; # 从集群移除节点:gluster peer detach <ip or hostname> [root@glusterfs01 ~]# gluster peer probe glusterfs02 [root@glusterfs01 ~]# gluster peer probe glusterfs03 [root@glusterfs01 ~]# gluster peer probe glusterfs04

# 查看受信存储池状态; # 在glusterfs01节点查看集群状态,不会list出本节点,只展示peers [root@glusterfs01 ~]# gluster peer status

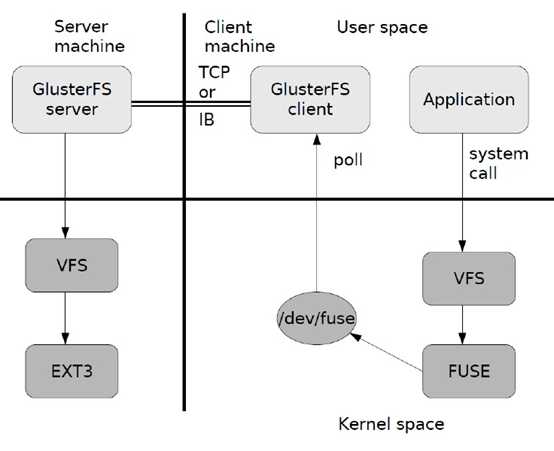

# 客户端主要安装两个组件,glusterfs与glusterfs-fuse; # glusterfs-client具备如数据卷管理、I/O 调度、文件定位、数据缓存等功能; # glusterfs-fuse将远端glusterfs挂载到本地文件系统,可通过”modinfo fuse”,“ll /dev/fuse”等命令查看 [root@glusterfs-client ~]# yum install -y glusterfs glusterfs-fuse

标签:arch amp pes nbsp wap centos7 exe ocs san

原文地址:https://www.cnblogs.com/netonline/p/9102004.html