- 一 错误和异常

- 二 异常处理

- 三 什么时候用异常处理

包

- 2.2 import

- 2.3 from ... import ...

- 2.4 __init__.py文件

- 2.5 from glance.api import *

- 2.6 绝对导入和相对导入

- 2.7 单独导入包

网络编程

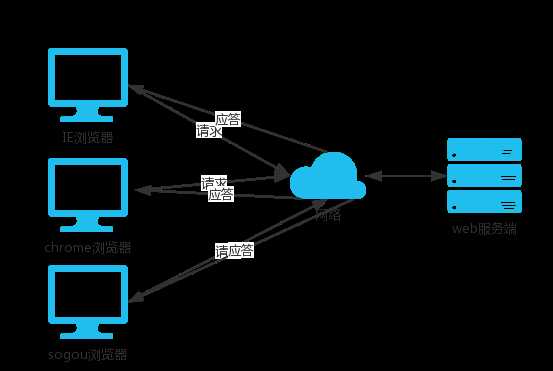

- 二.客户端/服务端架构

- 三.网络基础

- 四.套接字(socket)初使用

- 五.黏包

- 六.socket的更多方法介绍

- 七.验证客户端链接的合法性

- 八.socketserver模块

异常和错误

part1:程序中难免出现错误,而错误分成两种

1.语法错误(这种错误,根本过不了python解释器的语法检测,必须在程序执行前就改正)

#语法错误示范一

if

#语法错误示范二

def test:

pass

#语法错误示范三

print(haha

2.逻辑错误(逻辑错误)

#用户输入不完整(比如输入为空)或者输入非法(输入不是数字)

num=input(">>: ")

int(num)

#无法完成计算

res1=1/0

res2=1+‘str‘

part2:什么是异常

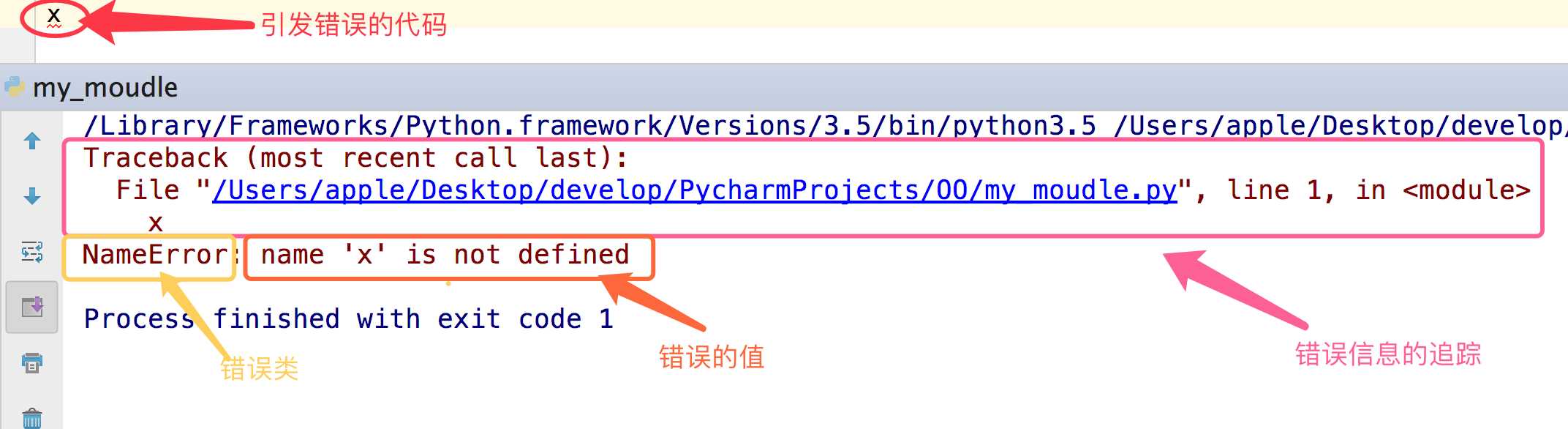

异常就是程序运行时发生错误的信号,在python中,错误触发的异常如下

part3:python中的异常种类

在python中不同的异常可以用不同的类型(python中统一了类与类型,类型即类)去标识,不同的类对象标识不同的异常,一个异常标识一种错误

l=[‘egon‘,‘aa‘] l[3]

dic={‘name‘:‘egon‘}

dic[‘age‘]

s=‘hello‘ int(s)

AttributeError 试图访问一个对象没有的树形,比如foo.x,但是foo没有属性x IOError 输入/输出异常;基本上是无法打开文件 ImportError 无法引入模块或包;基本上是路径问题或名称错误 IndentationError 语法错误(的子类) ;代码没有正确对齐 IndexError 下标索引超出序列边界,比如当x只有三个元素,却试图访问x[5] KeyError 试图访问字典里不存在的键 KeyboardInterrupt Ctrl+C被按下 NameError 使用一个还未被赋予对象的变量 SyntaxError Python代码非法,代码不能编译(个人认为这是语法错误,写错了) TypeError 传入对象类型与要求的不符合 UnboundLocalError 试图访问一个还未被设置的局部变量,基本上是由于另有一个同名的全局变量, 导致你以为正在访问它 ValueError 传入一个调用者不期望的值,即使值的类型是正确的

异常处理

什么是异常?

异常发生之后

异常之后的代码就不执行了

什么是异常处理

python解释器检测到错误,触发异常(也允许程序员自己触发异常)

程序员编写特定的代码,专门用来捕捉这个异常(这段代码与程序逻辑无关,与异常处理有关)

如果捕捉成功则进入另外一个处理分支,执行你为其定制的逻辑,使程序不会崩溃,这就是异常处理

为什么要进行异常处理?

python解析器去执行程序,检测到了一个错误时,触发异常,异常触发后且没被处理的情况下,程序就在当前异常处终止,后面的代码不会运行,谁会去用一个运行着突然就崩溃的软件。

所以你必须提供一种异常处理机制来增强你程序的健壮性与容错性

如何进行异常处理?

首先须知,异常是由程序的错误引起的,语法上的错误跟异常处理无关,必须在程序运行前就修正

一: 使用if判断式

num1=input(‘>>: ‘) #输入一个字符串试试 int(num1)

#_*_coding:utf-8_*_

__author__ = ‘Linhaifeng‘

num1=input(‘>>: ‘) #输入一个字符串试试

if num1.isdigit():

int(num1) #我们的正统程序放到了这里,其余的都属于异常处理范畴

elif num1.isspace():

print(‘输入的是空格,就执行我这里的逻辑‘)

elif len(num1) == 0:

print(‘输入的是空,就执行我这里的逻辑‘)

else:

print(‘其他情情况,执行我这里的逻辑‘)

‘‘‘

问题一:

使用if的方式我们只为第一段代码加上了异常处理,但这些if,跟你的代码逻辑并无关系,这样你的代码会因为可读性差而不容易被看懂

问题二:

这只是我们代码中的一个小逻辑,如果类似的逻辑多,那么每一次都需要判断这些内容,就会倒置我们的代码特别冗长。

‘‘‘

总结:

1.if判断式的异常处理只能针对某一段代码,对于不同的代码段的相同类型的错误你需要写重复的if来进行处理。

2.在你的程序中频繁的写与程序本身无关,与异常处理有关的if,会使得你的代码可读性极其的差

3.if是可以解决异常的,只是存在1,2的问题,所以,千万不要妄下定论if不能用来异常处理。

def test():

print(‘test running‘)

choice_dic={

‘1‘:test

}

while True:

choice=input(‘>>: ‘).strip()

if not choice or choice not in choice_dic:continue #这便是一种异常处理机制啊

choice_dic[choice]()

二:python为每一种异常定制了一个类型,然后提供了一种特定的语法结构用来进行异常处理

part1:基本语法

try:

被检测的代码块

except 异常类型:

try中一旦检测到异常,就执行这个位置的逻辑

f = open(‘a.txt‘)

g = (line.strip() for line in f)

for line in g:

print(line)

else:

f.close()

try:

f = open(‘a.txt‘)

g = (line.strip() for line in f)

print(next(g))

print(next(g))

print(next(g))

print(next(g))

print(next(g))

except StopIteration:

f.close()

‘‘‘

next(g)会触发迭代f,依次next(g)就可以读取文件的一行行内容,无论文件a.txt有多大,同一时刻内存中只有一行内容。

提示:g是基于文件句柄f而存在的,因而只能在next(g)抛出异常StopIteration后才可以执行f.close()

‘‘‘

part2:异常类只能用来处理指定的异常情况,如果非指定异常则无法处理。

# 未捕获到异常,程序直接报错

s1 = ‘hello‘

try:

int(s1)

except IndexError as e:

print e

part3:多分支

s1 = ‘hello‘

try:

int(s1)

except IndexError as e:

print(e)

except KeyError as e:

print(e)

except ValueError as e:

print(e)

part4:万能异常 在python的异常中,有一个万能异常:Exception,他可以捕获任意异常,即:

s1 = ‘hello‘

try:

int(s1)

except Exception as e:

print(e)

你可能会说既然有万能异常,那么我直接用上面的这种形式就好了,其他异常可以忽略

你说的没错,但是应该分两种情况去看

1.如果你想要的效果是,无论出现什么异常,我们统一丢弃,或者使用同一段代码逻辑去处理他们,那么骚年,大胆的去做吧,只有一个Exception就足够了。

s1 = ‘hello‘

try:

int(s1)

except Exception,e:

‘丢弃或者执行其他逻辑‘

print(e)

#如果你统一用Exception,没错,是可以捕捉所有异常,但意味着你在处理所有异常时都使用同一个逻辑去处理(这里说的逻辑即当前expect下面跟的代码块)

2.如果你想要的效果是,对于不同的异常我们需要定制不同的处理逻辑,那就需要用到多分支了。

s1 = ‘hello‘

try:

int(s1)

except IndexError as e:

print(e)

except KeyError as e:

print(e)

except ValueError as e:

print(e)

s1 = ‘hello‘

try:

int(s1)

except IndexError as e:

print(e)

except KeyError as e:

print(e)

except ValueError as e:

print(e)

except Exception as e:

print(e)

part5:异常的其他机构

s1 = ‘hello‘

try:

int(s1)

except IndexError as e:

print(e)

except KeyError as e:

print(e)

except ValueError as e:

print(e)

#except Exception as e:

# print(e)

else:

print(‘try内代码块没有异常则执行我‘)

finally:

print(‘无论异常与否,都会执行该模块,通常是进行清理工作‘)

part6:主动触发异常

try:

raise TypeError(‘类型错误‘)

except Exception as e:

print(e)

part7:自定义异常

class EvaException(BaseException):

def __init__(self,msg):

self.msg=msg

def __str__(self):

return self.msg

try:

raise EvaException(‘类型错误‘)

except EvaException as e:

print(e)

part8:断言

# assert 条件 assert 1 == 1 assert 1 == 2

part9:try..except的方式比较if的方式的好处

try..except这种异常处理机制就是取代if那种方式,让你的程序在不牺牲可读性的前提下增强健壮性和容错性

异常处理中为每一个异常定制了异常类型(python中统一了类与类型,类型即类),对于同一种异常,一个except就可以捕捉到,可以同时处理多段代码的异常(无需‘写多个if判断式’)减少了代码,增强了可读性

使用try..except的方式

1:把错误处理和真正的工作分开来

2:代码更易组织,更清晰,复杂的工作任务更容易实现;

3:毫无疑问,更安全了,不至于由于一些小的疏忽而使程序意外崩溃了;

什么时候用异常处理

有的同学会这么想,学完了异常处理后,好强大,我要为我的每一段程序都加上try...except,干毛线去思考它会不会有逻辑错误啊,这样就很好啊,多省脑细胞===》2B青年欢乐多

try...except应该尽量少用,因为它本身就是你附加给你的程序的一种异常处理的逻辑,与你的主要的工作是没有关系的

这种东西加的多了,会导致你的代码可读性变差,只有在有些异常无法预知的情况下,才应该加上try...except,其他的逻辑错误应该尽量修正

包

包是一种通过使用‘.模块名’来组织python模块名称空间的方式。

1. 无论是import形式还是from...import形式,凡是在导入语句中(而不是在使用时)遇到带点的,都要第一时间提高警觉:这是关于包才有的导入语法

2. 包是目录级的(文件夹级),文件夹是用来组成py文件(包的本质就是一个包含__init__.py文件的目录)

3. import导入文件时,产生名称空间中的名字来源于文件,import 包,产生的名称空间的名字同样来源于文件,即包下的__init__.py,导入包本质就是在导入该文件

强调:

1. 在python3中,即使包下没有__init__.py文件,import 包仍然不会报错,而在python2中,包下一定要有该文件,否则import 包报错

2. 创建包的目的不是为了运行,而是被导入使用,记住,包只是模块的一种形式而已,包即模块

包A和包B下有同名模块也不会冲突,如A.a与B.a来自俩个命名空间

import os os.makedirs(‘glance/api‘) os.makedirs(‘glance/cmd‘) os.makedirs(‘glance/db‘) l = [] l.append(open(‘glance/__init__.py‘,‘w‘)) l.append(open(‘glance/api/__init__.py‘,‘w‘)) l.append(open(‘glance/api/policy.py‘,‘w‘)) l.append(open(‘glance/api/versions.py‘,‘w‘)) l.append(open(‘glance/cmd/__init__.py‘,‘w‘)) l.append(open(‘glance/cmd/manage.py‘,‘w‘)) l.append(open(‘glance/db/models.py‘,‘w‘)) map(lambda f:f.close() ,l)

目录结构

glance/ #Top-level package ├── __init__.py #Initialize the glance package ├── api #Subpackage for api │ ├── __init__.py │ ├── policy.py │ └── versions.py ├── cmd #Subpackage for cmd │ ├── __init__.py │ └── manage.py └── db #Subpackage for db ├── __init__.py └── models.py

#文件内容

#policy.py

def get():

print(‘from policy.py‘)

#versions.py

def create_resource(conf):

print(‘from version.py: ‘,conf)

#manage.py

def main():

print(‘from manage.py‘)

#models.py

def register_models(engine):

print(‘from models.py: ‘,engine)

2.1 注意事项

1.关于包相关的导入语句也分为import和from ... import ...两种,但是无论哪种,无论在什么位置,在导入时都必须遵循一个原则:凡是在导入时带点的,点的左边都必须是一个包,否则非法。可以带有一连串的点,如item.subitem.subsubitem,但都必须遵循这个原则。

2.对于导入后,在使用时就没有这种限制了,点的左边可以是包,模块,函数,类(它们都可以用点的方式调用自己的属性)。

3.对比import item 和from item import name的应用场景:

如果我们想直接使用name那必须使用后者。

2.2 import

我们在与包glance同级别的文件中测试

1 import glance.db.models 2 glance.db.models.register_models(‘mysql‘)

2.3 from ... import ...

需要注意的是from后import导入的模块,必须是明确的一个不能带点,否则会有语法错误,如:from a import b.c是错误语法

我们在与包glance同级别的文件中测试

1 from glance.db import models 2 models.register_models(‘mysql‘) 3 4 from glance.db.models import register_models 5 register_models(‘mysql‘)

2.4 __init__.py文件

不管是哪种方式,只要是第一次导入包或者是包的任何其他部分,都会依次执行包下的__init__.py文件(我们可以在每个包的文件内都打印一行内容来验证一下),这个文件可以为空,但是也可以存放一些初始化包的代码。

2.5 from glance.api import *

在讲模块时,我们已经讨论过了从一个模块内导入所有*,此处我们研究从一个包导入所有*。

此处是想从包api中导入所有,实际上该语句只会导入包api下__init__.py文件中定义的名字,我们可以在这个文件中定义__all___:

#在__init__.py中定义

x=10

def func():

print(‘from api.__init.py‘)

__all__=[‘x‘,‘func‘,‘policy‘]

此时我们在于glance同级的文件中执行from glance.api import *就导入__all__中的内容(versions仍然不能导入)。

glance/ ├── __init__.py ├── api │ ├── __init__.py __all__ = [‘policy‘,‘versions‘] │ ├── policy.py │ └── versions.py ├── cmd __all__ = [‘manage‘] │ ├── __init__.py │ └── manage.py └── db __all__ = [‘models‘] ├── __init__.py └── models.py from glance.api import * policy.get()

2.6 绝对导入和相对导入

我们的最顶级包glance是写给别人用的,然后在glance包内部也会有彼此之间互相导入的需求,这时候就有绝对导入和相对导入两种方式:

绝对导入:以glance作为起始

相对导入:用.或者..的方式最为起始(只能在一个包中使用,不能用于不同目录内)

例如:我们在glance/api/version.py中想要导入glance/cmd/manage.py

在glance/api/version.py #绝对导入 from glance.cmd import manage manage.main() #相对导入 from ..cmd import manage manage.main()

测试结果:注意一定要在于glance同级的文件中测试

1 from glance.api import versions

注意:在使用pycharm时,有的情况会为你多做一些事情,这是软件相关的东西,会影响你对模块导入的理解,因而在测试时,一定要回到命令行去执行,模拟我们生产环境,你总不能拿着pycharm去上线代码吧!!!

特别需要注意的是:可以用import导入内置或者第三方模块(已经在sys.path中),但是要绝对避免使用import来导入自定义包的子模块(没有在sys.path中),应该使用from... import ...的绝对或者相对导入,且包的相对导入只能用from的形式。

比如我们想在glance/api/versions.py中导入glance/api/policy.py,有的同学一抽这俩模块是在同一个目录下,十分开心的就去做了,它直接这么做

1 #在version.py中 2 3 import policy 4 policy.get()

没错,我们单独运行version.py是一点问题没有的,运行version.py的路径搜索就是从当前路径开始的,于是在导入policy时能在当前目录下找到

但是你想啊,你子包中的模块version.py极有可能是被一个glance包同一级别的其他文件导入,比如我们在于glance同级下的一个test.py文件中导入version.py,如下

from glance.api import versions ‘‘‘ 执行结果: ImportError: No module named ‘policy‘ ‘‘‘ ‘‘‘ 分析: 此时我们导入versions在versions.py中执行 import policy需要找从sys.path也就是从当前目录找policy.py, 这必然是找不到的 ‘‘‘

glance/ ├── __init__.py from glance import api from glance import cmd from glance import db ├── api │ ├── __init__.py from glance.api import policy from glance.api import versions │ ├── policy.py │ └── versions.py ├── cmd from glance.cmd import manage │ ├── __init__.py │ └── manage.py └── db from glance.db import models ├── __init__.py └── models.py

glance/ ├── __init__.py from . import api #.表示当前目录 from . import cmd from . import db ├── api │ ├── __init__.py from . import policy from . import versions │ ├── policy.py │ └── versions.py ├── cmd from . import manage │ ├── __init__.py │ └── manage.py from ..api import policy #..表示上一级目录,想再manage中使用policy中的方法就需要回到上一级glance目录往下找api包,从api导入policy └── db from . import models ├── __init__.py └── models.py

2.7 单独导入包

单独导入包名称时不会导入包中所有包含的所有子模块,如

#在与glance同级的test.py中 import glance glance.cmd.manage.main() ‘‘‘ 执行结果: AttributeError: module ‘glance‘ has no attribute ‘cmd‘ ‘‘‘

解决方法:

1 #glance/__init__.py 2 from . import cmd 3 4 #glance/cmd/__init__.py 5 from . import manage

执行:

1 #在于glance同级的test.py中 2 import glance 3 glance.cmd.manage.main()

千万别问:__all__不能解决吗,__all__是用于控制from...import *

import glance之后直接调用模块中的方法

import glance

glance/ ├── __init__.py from .api import * from .cmd import * from .db import * ├── api │ ├── __init__.py __all__ = [‘policy‘,‘versions‘] │ ├── policy.py │ └── versions.py ├── cmd __all__ = [‘manage‘] │ ├── __init__.py │ └── manage.py └── db __all__ = [‘models‘] ├── __init__.py └── models.py import glance policy.get()

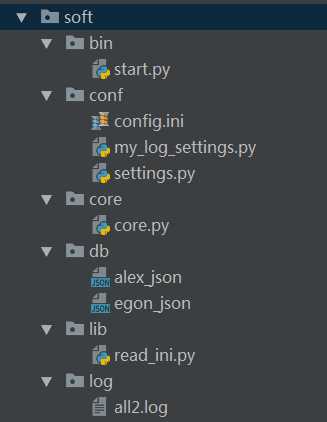

软件开发规范

#=============>bin目录:存放执行脚本

#start.py

import sys,os

BASE_DIR=os.path.dirname(os.path.dirname(os.path.abspath(__file__)))

sys.path.append(BASE_DIR)

from core import core

from conf import my_log_settings

if __name__ == ‘__main__‘:

my_log_settings.load_my_logging_cfg()

core.run()

#=============>conf目录:存放配置文件

#config.ini

[DEFAULT]

user_timeout = 1000

[egon]

password = 123

money = 10000000

[alex]

password = alex3714

money=10000000000

[yuanhao]

password = ysb123

money=10

#settings.py

import os

config_path=r‘%s\%s‘ %(os.path.dirname(os.path.abspath(__file__)),‘config.ini‘)

user_timeout=10

user_db_path=r‘%s\%s‘ %(os.path.dirname(os.path.dirname(os.path.abspath(__file__))), ‘db‘)

#my_log_settings.py

"""

logging配置

"""

import os

import logging.config

# 定义三种日志输出格式 开始

standard_format = ‘[%(asctime)s][%(threadName)s:%(thread)d][task_id:%(name)s][%(filename)s:%(lineno)d]‘ ‘[%(levelname)s][%(message)s]‘ #其中name为getlogger指定的名字

simple_format = ‘[%(levelname)s][%(asctime)s][%(filename)s:%(lineno)d]%(message)s‘

id_simple_format = ‘[%(levelname)s][%(asctime)s] %(message)s‘

# 定义日志输出格式 结束

logfile_dir = r‘%s\log‘ %os.path.dirname(os.path.dirname(os.path.abspath(__file__))) # log文件的目录

logfile_name = ‘all2.log‘ # log文件名

# 如果不存在定义的日志目录就创建一个

if not os.path.isdir(logfile_dir):

os.mkdir(logfile_dir)

# log文件的全路径

logfile_path = os.path.join(logfile_dir, logfile_name)

# log配置字典

LOGGING_DIC = {

‘version‘: 1,

‘disable_existing_loggers‘: False,

‘formatters‘: {

‘standard‘: {

‘format‘: standard_format

},

‘simple‘: {

‘format‘: simple_format

},

},

‘filters‘: {},

‘handlers‘: {

#打印到终端的日志

‘console‘: {

‘level‘: ‘DEBUG‘,

‘class‘: ‘logging.StreamHandler‘, # 打印到屏幕

‘formatter‘: ‘simple‘

},

#打印到文件的日志,收集info及以上的日志

‘default‘: {

‘level‘: ‘DEBUG‘,

‘class‘: ‘logging.handlers.RotatingFileHandler‘, # 保存到文件

‘formatter‘: ‘standard‘,

‘filename‘: logfile_path, # 日志文件

‘maxBytes‘: 1024*1024*5, # 日志大小 5M

‘backupCount‘: 5,

‘encoding‘: ‘utf-8‘, # 日志文件的编码,再也不用担心中文log乱码了

},

},

‘loggers‘: {

#logging.getLogger(__name__)拿到的logger配置

‘‘: {

‘handlers‘: [‘default‘, ‘console‘], # 这里把上面定义的两个handler都加上,即log数据既写入文件又打印到屏幕

‘level‘: ‘DEBUG‘,

‘propagate‘: True, # 向上(更高level的logger)传递

},

},

}

def load_my_logging_cfg():

logging.config.dictConfig(LOGGING_DIC) # 导入上面定义的logging配置

logger = logging.getLogger(__name__) # 生成一个log实例

logger.info(‘It works!‘) # 记录该文件的运行状态

if __name__ == ‘__main__‘:

load_my_logging_cfg()

#=============>core目录:存放核心逻辑

#core.py

import logging

import time

from conf import settings

from lib import read_ini

config=read_ini.read(settings.config_path)

logger=logging.getLogger(__name__)

current_user={‘user‘:None,‘login_time‘:None,‘timeout‘:int(settings.user_timeout)}

def auth(func):

def wrapper(*args,**kwargs):

if current_user[‘user‘]:

interval=time.time()-current_user[‘login_time‘]

if interval < current_user[‘timeout‘]:

return func(*args,**kwargs)

name = input(‘name>>: ‘)

password = input(‘password>>: ‘)

if config.has_section(name):

if password == config.get(name,‘password‘):

logger.info(‘登录成功‘)

current_user[‘user‘]=name

current_user[‘login_time‘]=time.time()

return func(*args,**kwargs)

else:

logger.error(‘用户名不存在‘)

return wrapper

@auth

def buy():

print(‘buy...‘)

@auth

def run():

print(‘‘‘

购物

查看余额

转账

‘‘‘)

while True:

choice = input(‘>>: ‘).strip()

if not choice:continue

if choice == ‘1‘:

buy()

if __name__ == ‘__main__‘:

run()

#=============>db目录:存放数据库文件

#alex_json

#egon_json

#=============>lib目录:存放自定义的模块与包

#read_ini.py

import configparser

def read(config_file):

config=configparser.ConfigParser()

config.read(config_file)

return config

#=============>log目录:存放日志

#all2.log

[2017-07-29 00:31:40,272][MainThread:11692][task_id:conf.my_log_settings][my_log_settings.py:75][INFO][It works!]

[2017-07-29 00:31:41,789][MainThread:11692][task_id:core.core][core.py:25][ERROR][用户名不存在]

[2017-07-29 00:31:46,394][MainThread:12348][task_id:conf.my_log_settings][my_log_settings.py:75][INFO][It works!]

[2017-07-29 00:31:47,629][MainThread:12348][task_id:core.core][core.py:25][ERROR][用户名不存在]

[2017-07-29 00:31:57,912][MainThread:10528][task_id:conf.my_log_settings][my_log_settings.py:75][INFO][It works!]

[2017-07-29 00:32:03,340][MainThread:12744][task_id:conf.my_log_settings][my_log_settings.py:75][INFO][It works!]

[2017-07-29 00:32:05,065][MainThread:12916][task_id:conf.my_log_settings][my_log_settings.py:75][INFO][It works!]

[2017-07-29 00:32:08,181][MainThread:12916][task_id:core.core][core.py:25][ERROR][用户名不存在]

[2017-07-29 00:32:13,638][MainThread:7220][task_id:conf.my_log_settings][my_log_settings.py:75][INFO][It works!]

[2017-07-29 00:32:23,005][MainThread:7220][task_id:core.core][core.py:20][INFO][登录成功]

[2017-07-29 00:32:40,941][MainThread:7220][task_id:core.core][core.py:20][INFO][登录成功]

[2017-07-29 00:32:47,222][MainThread:7220][task_id:core.core][core.py:20][INFO][登录成功]

[2017-07-29 00:32:51,949][MainThread:7220][task_id:core.core][core.py:25][ERROR][用户名不存在]

[2017-07-29 00:33:00,213][MainThread:7220][task_id:core.core][core.py:20][INFO][登录成功]

[2017-07-29 00:33:50,118][MainThread:8500][task_id:conf.my_log_settings][my_log_settings.py:75][INFO][It works!]

[2017-07-29 00:33:55,845][MainThread:8500][task_id:core.core][core.py:20][INFO][登录成功]

[2017-07-29 00:34:06,837][MainThread:8500][task_id:core.core][core.py:25][ERROR][用户名不存在]

[2017-07-29 00:34:09,405][MainThread:8500][task_id:core.core][core.py:25][ERROR][用户名不存在]

[2017-07-29 00:34:10,645][MainThread:8500][task_id:core.core][core.py:25][ERROR][用户名不存在]

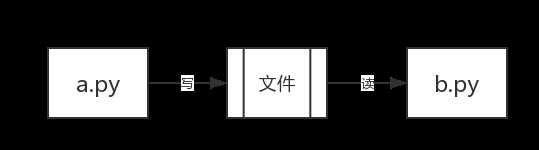

你现在已经学会了写python代码,假如你写了两个python文件a.py和b.py,分别去运行,你就会发现,这两个python的文件分别运行的很好。但是如果这两个程序之间想要传递一个数据,你要怎么做呢?

这个问题以你现在的知识就可以解决了,我们可以创建一个文件,把a.py想要传递的内容写到文件中,然后b.py从这个文件中读取内容就可以了。

但是当你的a.py和b.py分别在不同电脑上的时候,你要怎么办呢?

类似的机制有计算机网盘,qq等等。我们可以在我们的电脑上和别人聊天,可以在自己的电脑上向网盘中上传、下载内容。这些都是两个程序在通信。

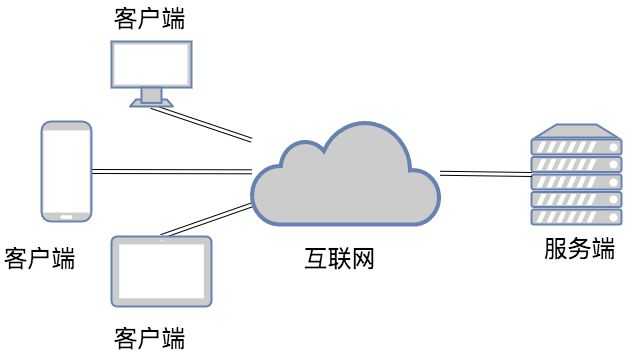

二.软件开发的架构

我们了解的涉及到两个程序之间通讯的应用大致可以分为两种:

第一种是应用类:qq、微信、网盘、优酷这一类是属于需要安装的桌面应用

第二种是web类:比如百度、知乎、博客园等使用浏览器访问就可以直接使用的应用

这些应用的本质其实都是两个程序之间的通讯。而这两个分类又对应了两个软件开发的架构~

1.C/S架构

C/S即:Client与Server ,中文意思:客户端与服务器端架构,这种架构也是从用户层面(也可以是物理层面)来划分的。

这里的客户端一般泛指客户端应用程序EXE,程序需要先安装后,才能运行在用户的电脑上,对用户的电脑操作系统环境依赖较大。

2.B/S架构

B/S即:Browser与Server,中文意思:浏览器端与服务器端架构,这种架构是从用户层面来划分的。

Browser浏览器,其实也是一种Client客户端,只是这个客户端不需要大家去安装什么应用程序,只需在浏览器上通过HTTP请求服务器端相关的资源(网页资源),客户端Browser浏览器就能进行增删改查。

三.网络基础

1.一个程序如何在网络上找到另一个程序?

首先,程序必须要启动,其次,必须有这台机器的地址,我们都知道我们人的地址大概就是国家\省\市\区\街道\楼\门牌号这样字。那么每一台联网的机器在网络上也有自己的地址,它的地址是怎么表示的呢?

就是使用一串数字来表示的,例如:100.4.5.6

因此ip地址精确到具体的一台电脑,而端口精确到具体的程序。

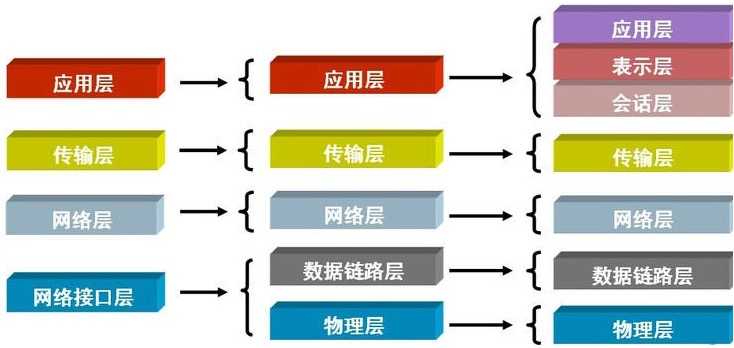

2.osi七层模型

引子

须知一个完整的计算机系统是由硬件、操作系统、应用软件三者组成,具备了这三个条件,一台计算机系统就可以自己跟自己玩了(打个单机游戏,玩个扫雷啥的)

如果你要跟别人一起玩,那你就需要上网了,什么是互联网?

互联网的核心就是由一堆协议组成,协议就是标准,比如全世界人通信的标准是英语,如果把计算机比作人,互联网协议就是计算机界的英语。所有的计算机都学会了互联网协议,那所有的计算机都就可以按照统一的标准去收发信息从而完成通信了。

osi七层模型

人们按照分工不同把互联网协议从逻辑上划分了层级:

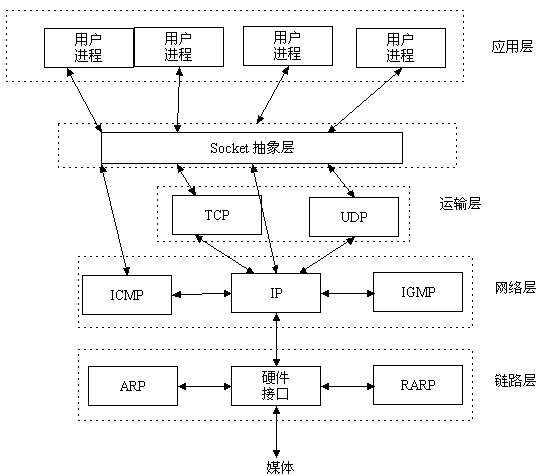

3.socket概念

socket层

理解socket

Socket是应用层与TCP/IP协议族通信的中间软件抽象层,它是一组接口。在设计模式中,Socket其实就是一个门面模式,它把复杂的TCP/IP协议族隐藏在Socket接口后面,对用户来说,一组简单的接口就是全部,让Socket去组织数据,以符合指定的协议。

其实站在你的角度上看,socket就是一个模块。我们通过调用模块中已经实现的方法建立两个进程之间的连接和通信。 也有人将socket说成ip+port,因为ip是用来标识互联网中的一台主机的位置,而port是用来标识这台机器上的一个应用程序。 所以我们只要确立了ip和port就能找到一个应用程序,并且使用socket模块来与之通信。

3.套接字(socket)的发展史

套接字起源于 20 世纪 70 年代加利福尼亚大学伯克利分校版本的 Unix,即人们所说的 BSD Unix。 因此,有时人们也把套接字称为“伯克利套接字”或“BSD 套接字”。一开始,套接字被设计用在同 一台主机上多个应用程序之间的通讯。这也被称进程间通讯,或 IPC。套接字有两种(或者称为有两个种族),分别是基于文件型的和基于网络型的。

基于文件类型的套接字家族

套接字家族的名字:AF_UNIX

unix一切皆文件,基于文件的套接字调用的就是底层的文件系统来取数据,两个套接字进程运行在同一机器,可以通过访问同一个文件系统间接完成通信

基于网络类型的套接字家族

套接字家族的名字:AF_INET

(还有AF_INET6被用于ipv6,还有一些其他的地址家族,不过,他们要么是只用于某个平台,要么就是已经被废弃,或者是很少被使用,或者是根本没有实现,所有地址家族中,AF_INET是使用最广泛的一个,python支持很多种地址家族,但是由于我们只关心网络编程,所以大部分时候我么只使用AF_INET)

4.tcp协议和udp协议

TCP(Transmission Control Protocol)可靠的、面向连接的协议(eg:打电话)、传输效率低全双工通信(发送缓存&接收缓存)、面向字节流。使用TCP的应用:Web浏览器;电子邮件、文件传输程序。

UDP(User Datagram Protocol)不可靠的、无连接的服务,传输效率高(发送前时延小),一对一、一对多、多对一、多对多、面向报文,尽最大努力服务,无拥塞控制。使用UDP的应用:域名系统 (DNS);视频流;IP语音(VoIP)。

我知道说这些你们也不懂,直接上图。

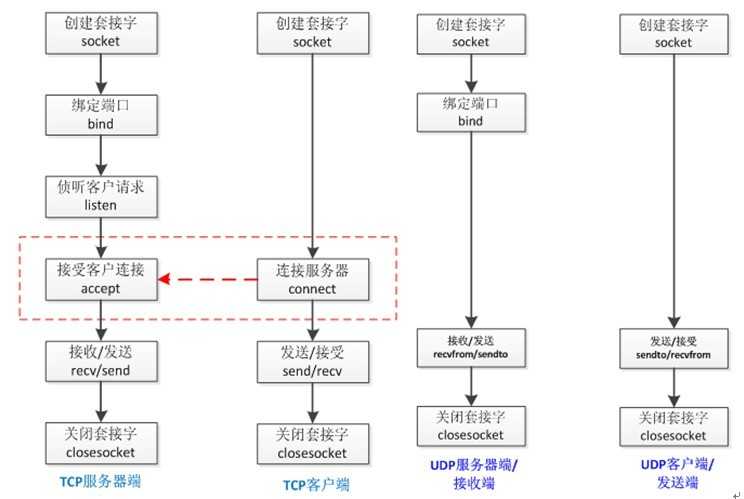

四.套接字(socket)初使用

基于TCP协议的socket

tcp是基于链接的,必须先启动服务端,然后再启动客户端去链接服务端

server端

import socket sk = socket.socket() sk.bind((‘127.0.0.1‘,8898)) #把地址绑定到套接字 sk.listen() #监听链接 conn,addr = sk.accept() #接受客户端链接 ret = conn.recv(1024) #接收客户端信息 print(ret) #打印客户端信息 conn.send(b‘hi‘) #向客户端发送信息 conn.close() #关闭客户端套接字 sk.close() #关闭服务器套接字(可选)

client端

import socket sk = socket.socket() # 创建客户套接字 sk.connect((‘127.0.0.1‘,8898)) # 尝试连接服务器 sk.send(b‘hello!‘) ret = sk.recv(1024) # 对话(发送/接收) print(ret) sk.close() # 关闭客户套接字

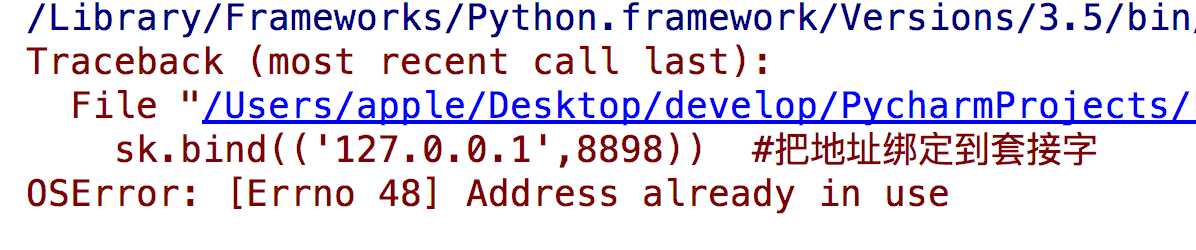

问题:有的同学在重启服务端时可能会遇到

解决方法:

#加入一条socket配置,重用ip和端口 import socket from socket import SOL_SOCKET,SO_REUSEADDR sk = socket.socket() sk.setsockopt(SOL_SOCKET,SO_REUSEADDR,1) #就是它,在bind前加 sk.bind((‘127.0.0.1‘,8898)) #把地址绑定到套接字 sk.listen() #监听链接 conn,addr = sk.accept() #接受客户端链接 ret = conn.recv(1024) #接收客户端信息 print(ret) #打印客户端信息 conn.send(b‘hi‘) #向客户端发送信息 conn.close() #关闭客户端套接字 sk.close() #关闭服务器套接字(可选)

基于UDP协议的socket

udp是无链接的,启动服务之后可以直接接受消息,不需要提前建立链接

简单使用

server端

import socket udp_sk = socket.socket(type=socket.SOCK_DGRAM) #创建一个服务器的套接字 udp_sk.bind((‘127.0.0.1‘,9000)) #绑定服务器套接字 msg,addr = udp_sk.recvfrom(1024) print(msg) udp_sk.sendto(b‘hi‘,addr) # 对话(接收与发送) udp_sk.close() # 关闭服务器套接字

client端

import socket ip_port=(‘127.0.0.1‘,9000) udp_sk=socket.socket(type=socket.SOCK_DGRAM) udp_sk.sendto(b‘hello‘,ip_port) back_msg,addr=udp_sk.recvfrom(1024) print(back_msg.decode(‘utf-8‘),addr)

qq聊天

#_*_coding:utf-8_*_

import socket

ip_port=(‘127.0.0.1‘,8081)

udp_server_sock=socket.socket(socket.AF_INET,socket.SOCK_DGRAM)

udp_server_sock.bind(ip_port)

while True:

qq_msg,addr=udp_server_sock.recvfrom(1024)

print(‘来自[%s:%s]的一条消息:\033[1;44m%s\033[0m‘ %(addr[0],addr[1],qq_msg.decode(‘utf-8‘)))

back_msg=input(‘回复消息: ‘).strip()

udp_server_sock.sendto(back_msg.encode(‘utf-8‘),addr)

#_*_coding:utf-8_*_

import socket

BUFSIZE=1024

udp_client_socket=socket.socket(socket.AF_INET,socket.SOCK_DGRAM)

qq_name_dic={

‘金老板‘:(‘127.0.0.1‘,8081),

‘哪吒‘:(‘127.0.0.1‘,8081),

‘egg‘:(‘127.0.0.1‘,8081),

‘yuan‘:(‘127.0.0.1‘,8081),

}

while True:

qq_name=input(‘请选择聊天对象: ‘).strip()

while True:

msg=input(‘请输入消息,回车发送,输入q结束和他的聊天: ‘).strip()

if msg == ‘q‘:break

if not msg or not qq_name or qq_name not in qq_name_dic:continue

udp_client_socket.sendto(msg.encode(‘utf-8‘),qq_name_dic[qq_name])

back_msg,addr=udp_client_socket.recvfrom(BUFSIZE)

print(‘来自[%s:%s]的一条消息:\033[1;44m%s\033[0m‘ %(addr[0],addr[1],back_msg.decode(‘utf-8‘)))

udp_client_socket.close()

时间服务器

# _*_coding:utf-8_*_

from socket import *

from time import strftime

ip_port = (‘127.0.0.1‘, 9000)

bufsize = 1024

tcp_server = socket(AF_INET, SOCK_DGRAM)

tcp_server.setsockopt(SOL_SOCKET,SO_REUSEADDR,1)

tcp_server.bind(ip_port)

while True:

msg, addr = tcp_server.recvfrom(bufsize)

print(‘===>‘, msg)

if not msg:

time_fmt = ‘%Y-%m-%d %X‘

else:

time_fmt = msg.decode(‘utf-8‘)

back_msg = strftime(time_fmt)

tcp_server.sendto(back_msg.encode(‘utf-8‘), addr)

tcp_server.close()

#_*_coding:utf-8_*_

from socket import *

ip_port=(‘127.0.0.1‘,9000)

bufsize=1024

tcp_client=socket(AF_INET,SOCK_DGRAM)

while True:

msg=input(‘请输入时间格式(例%Y %m %d)>>: ‘).strip()

tcp_client.sendto(msg.encode(‘utf-8‘),ip_port)

data=tcp_client.recv(bufsize)

socket参数的详解

socket.socket(family=AF_INET,type=SOCK_STREAM,proto=0,fileno=None)

创建socket对象的参数说明:

| family | 地址系列应为AF_INET(默认值),AF_INET6,AF_UNIX,AF_CAN或AF_RDS。 (AF_UNIX 域实际上是使用本地 socket 文件来通信) |

| type | 套接字类型应为SOCK_STREAM(默认值),SOCK_DGRAM,SOCK_RAW或其他SOCK_常量之一。 SOCK_STREAM 是基于TCP的,有保障的(即能保证数据正确传送到对方)面向连接的SOCKET,多用于资料传送。 SOCK_DGRAM 是基于UDP的,无保障的面向消息的socket,多用于在网络上发广播信息。 |

| proto | 协议号通常为零,可以省略,或者在地址族为AF_CAN的情况下,协议应为CAN_RAW或CAN_BCM之一。 |

| fileno | 如果指定了fileno,则其他参数将被忽略,导致带有指定文件描述符的套接字返回。 与socket.fromfd()不同,fileno将返回相同的套接字,而不是重复的。 这可能有助于使用socket.close()关闭一个独立的插座。 |

黏包

黏包现象

让我们基于tcp先制作一个远程执行命令的程序(命令ls -l ; lllllll ; pwd)

res=subprocess.Popen(cmd.decode(‘utf-8‘), shell=True, stderr=subprocess.PIPE, stdout=subprocess.PIPE) 的结果的编码是以当前所在的系统为准的,如果是windows,那么res.stdout.read()读出的就是GBK编码的,在接收端需要用GBK解码 且只能从管道里读一次结果

同时执行多条命令之后,得到的结果很可能只有一部分,在执行其他命令的时候又接收到之前执行的另外一部分结果,这种显现就是黏包。

基于tcp协议实现的黏包

tcp - server

*_coding:utf-8_*_ from socket import * import subprocess ip_port=(‘127.0.0.1‘,8888) BUFSIZE=1024 tcp_socket_server=socket(AF_INET,SOCK_STREAM) tcp_socket_server.setsockopt(SOL_SOCKET,SO_REUSEADDR,1) tcp_socket_server.bind(ip_port) tcp_socket_server.listen(5) while True: conn,addr=tcp_socket_server.accept() print(‘客户端‘,addr) while True: cmd=conn.recv(BUFSIZE) if len(cmd) == 0:break res=subprocess.Popen(cmd.decode(‘utf-8‘),shell=True, stdout=subprocess.PIPE, stdin=subprocess.PIPE, stderr=subprocess.PIPE) stderr=res.stderr.read() stdout=res.stdout.read() conn.send(stderr) conn.send(stdout)

tcp - client

#_*_coding:utf-8_*_ import socket BUFSIZE=1024 ip_port=(‘127.0.0.1‘,8888) s=socket.socket(socket.AF_INET,socket.SOCK_STREAM) res=s.connect_ex(ip_port) while True: msg=input(‘>>: ‘).strip() if len(msg) == 0:continue if msg == ‘quit‘:break s.send(msg.encode(‘utf-8‘)) act_res=s.recv(BUFSIZE) print(act_res.decode(‘utf-8‘),end=‘‘)

基于udp协议实现的黏包

#_*_coding:utf-8_*_

from socket import *

import subprocess

ip_port=(‘127.0.0.1‘,9000)

bufsize=1024

udp_server=socket(AF_INET,SOCK_DGRAM)

udp_server.setsockopt(SOL_SOCKET,SO_REUSEADDR,1)

udp_server.bind(ip_port)

while True:

#收消息

cmd,addr=udp_server.recvfrom(bufsize)

print(‘用户命令----->‘,cmd)

#逻辑处理

res=subprocess.Popen(cmd.decode(‘utf-8‘),shell=True,stderr=subprocess.PIPE,stdin=subprocess.PIPE,stdout=subprocess.PIPE)

stderr=res.stderr.read()

stdout=res.stdout.read()

#发消息

udp_server.sendto(stderr,addr)

udp_server.sendto(stdout,addr)

udp_server.close()

from socket import *

ip_port=(‘127.0.0.1‘,9000)

bufsize=1024

udp_client=socket(AF_INET,SOCK_DGRAM)

while True:

msg=input(‘>>: ‘).strip()

udp_client.sendto(msg.encode(‘utf-8‘),ip_port)

err,addr=udp_client.recvfrom(bufsize)

out,addr=udp_client.recvfrom(bufsize)

if err:

print(‘error : %s‘%err.decode(‘utf-8‘),end=‘‘)

if out:

print(out.decode(‘utf-8‘), end=‘‘)

注意:只有TCP有粘包现象,UDP永远不会粘包

黏包成因

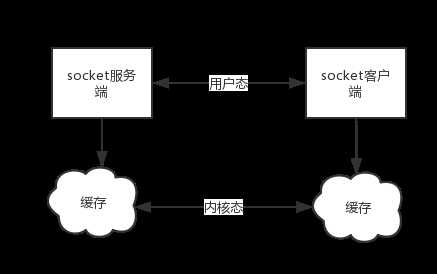

TCP协议中的数据传递

tcp协议的拆包机制

当发送端缓冲区的长度大于网卡的MTU时,tcp会将这次发送的数据拆成几个数据包发送出去。 MTU是Maximum Transmission Unit的缩写。意思是网络上传送的最大数据包。MTU的单位是字节。 大部分网络设备的MTU都是1500。如果本机的MTU比网关的MTU大,大的数据包就会被拆开来传送,这样会产生很多数据包碎片,增加丢包率,降低网络速度。

面向流的通信特点和Nagle算法

TCP(transport control protocol,传输控制协议)是面向连接的,面向流的,提供高可靠性服务。 收发两端(客户端和服务器端)都要有一一成对的socket,因此,发送端为了将多个发往接收端的包,更有效的发到对方,使用了优化方法(Nagle算法),将多次间隔较小且数据量小的数据,合并成一个大的数据块,然后进行封包。 这样,接收端,就难于分辨出来了,必须提供科学的拆包机制。 即面向流的通信是无消息保护边界的。 对于空消息:tcp是基于数据流的,于是收发的消息不能为空,这就需要在客户端和服务端都添加空消息的处理机制,防止程序卡住,而udp是基于数据报的,即便是你输入的是空内容(直接回车),也可以被发送,udp协议会帮你封装上消息头发送过去。 可靠黏包的tcp协议:tcp的协议数据不会丢,没有收完包,下次接收,会继续上次继续接收,己端总是在收到ack时才会清除缓冲区内容。数据是可靠的,但是会粘包。

基于tcp协议特点的黏包现象成因

发送端可以是一K一K地发送数据,而接收端的应用程序可以两K两K地提走数据,当然也有可能一次提走3K或6K数据,或者一次只提走几个字节的数据。 也就是说,应用程序所看到的数据是一个整体,或说是一个流(stream),一条消息有多少字节对应用程序是不可见的,因此TCP协议是面向流的协议,这也是容易出现粘包问题的原因。 而UDP是面向消息的协议,每个UDP段都是一条消息,应用程序必须以消息为单位提取数据,不能一次提取任意字节的数据,这一点和TCP是很不同的。 怎样定义消息呢?可以认为对方一次性write/send的数据为一个消息,需要明白的是当对方send一条信息的时候,无论底层怎样分段分片,TCP协议层会把构成整条消息的数据段排序完成后才呈现在内核缓冲区。

例如基于tcp的套接字客户端往服务端上传文件,发送时文件内容是按照一段一段的字节流发送的,在接收方看了,根本不知道该文件的字节流从何处开始,在何处结束

此外,发送方引起的粘包是由TCP协议本身造成的,TCP为提高传输效率,发送方往往要收集到足够多的数据后才发送一个TCP段。若连续几次需要send的数据都很少,通常TCP会根据优化算法把这些数据合成一个TCP段后一次发送出去,这样接收方就收到了粘包数据。

UDP不会发生黏包

UDP(user datagram protocol,用户数据报协议)是无连接的,面向消息的,提供高效率服务。 不会使用块的合并优化算法,, 由于UDP支持的是一对多的模式,所以接收端的skbuff(套接字缓冲区)采用了链式结构来记录每一个到达的UDP包,在每个UDP包中就有了消息头(消息来源地址,端口等信息),这样,对于接收端来说,就容易进行区分处理了。 即面向消息的通信是有消息保护边界的。 对于空消息:tcp是基于数据流的,于是收发的消息不能为空,这就需要在客户端和服务端都添加空消息的处理机制,防止程序卡住,而udp是基于数据报的,即便是你输入的是空内容(直接回车),也可以被发送,udp协议会帮你封装上消息头发送过去。 不可靠不黏包的udp协议:udp的recvfrom是阻塞的,一个recvfrom(x)必须对唯一一个sendinto(y),收完了x个字节的数据就算完成,若是y;x数据就丢失,这意味着udp根本不会粘包,但是会丢数据,不可靠。

补充说明:

用UDP协议发送时,用sendto函数最大能发送数据的长度为:65535- IP头(20) – UDP头(8)=65507字节。用sendto函数发送数据时,如果发送数据长度大于该值,则函数会返回错误。(丢弃这个包,不进行发送)

用TCP协议发送时,由于TCP是数据流协议,因此不存在包大小的限制(暂不考虑缓冲区的大小),这是指在用send函数时,数据长度参数不受限制。而实际上,所指定的这段数据并不一定会一次性发送出去,如果这段数据比较长,会被分段发送,如果比较短,可能会等待和下一次数据一起发送。

会发生黏包的两种情况

情况一 发送方的缓存机制

发送端需要等缓冲区满才发送出去,造成粘包(发送数据时间间隔很短,数据了很小,会合到一起,产生粘包)

服务端

服务端 客户端

客户端情况二 接收方的缓存机制

接收方不及时接收缓冲区的包,造成多个包接收(客户端发送了一段数据,服务端只收了一小部分,服务端下次再收的时候还是从缓冲区拿上次遗留的数据,产生粘包)

服务端

服务端 客户端

客户端

总结

黏包现象只发生在tcp协议中:

1.从表面上看,黏包问题主要是因为发送方和接收方的缓存机制、tcp协议面向流通信的特点。

2.实际上,主要还是因为接收方不知道消息之间的界限,不知道一次性提取多少字节的数据所造成的

黏包的解决方案

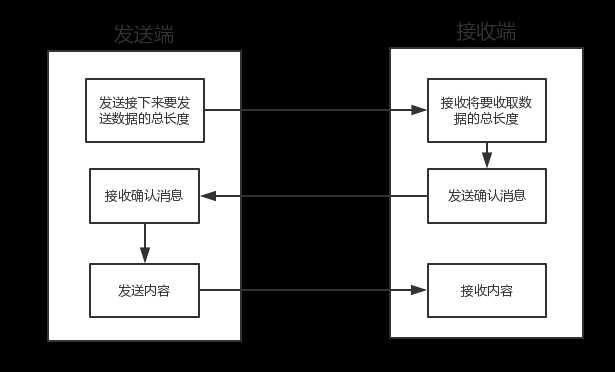

解决方案一

问题的根源在于,接收端不知道发送端将要传送的字节流的长度,所以解决粘包的方法就是围绕,如何让发送端在发送数据前,把自己将要发送的字节流总大小让接收端知晓,然后接收端来一个死循环接收完所有数据。

服务端

服务端 客户端

客户端存在的问题: 程序的运行速度远快于网络传输速度,所以在发送一段字节前,先用send去发送该字节流长度,这种方式会放大网络延迟带来的性能损耗

解决方案进阶

刚刚的方法,问题在于我们我们在发送

我们可以借助一个模块,这个模块可以把要发送的数据长度转换成固定长度的字节。这样客户端每次接收消息之前只要先接受这个固定长度字节的内容看一看接下来要接收的信息大小,那么最终接受的数据只要达到这个值就停止,就能刚好不多不少的接收完整的数据了。

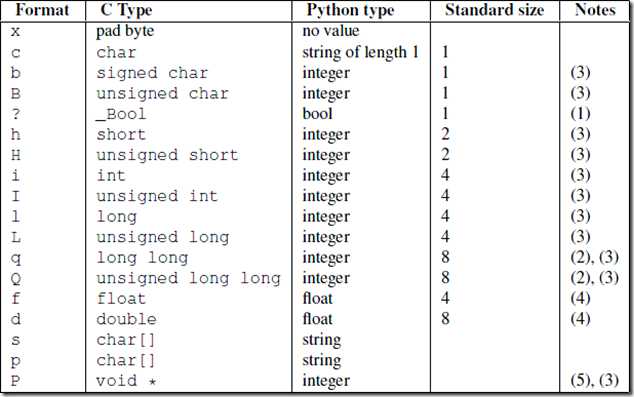

struct模块

该模块可以把一个类型,如数字,转成固定长度的bytes

>>> struct.pack(‘i‘,1111111111111) struct.error: ‘i‘ format requires -2147483648 <= number <= 2147483647 #这个是范围

import json,struct

#假设通过客户端上传1T:1073741824000的文件a.txt

#为避免粘包,必须自定制报头

header={‘file_size‘:1073741824000,‘file_name‘:‘/a/b/c/d/e/a.txt‘,‘md5‘:‘8f6fbf8347faa4924a76856701edb0f3‘} #1T数据,文件路径和md5值

#为了该报头能传送,需要序列化并且转为bytes

head_bytes=bytes(json.dumps(header),encoding=‘utf-8‘) #序列化并转成bytes,用于传输

#为了让客户端知道报头的长度,用struck将报头长度这个数字转成固定长度:4个字节

head_len_bytes=struct.pack(‘i‘,len(head_bytes)) #这4个字节里只包含了一个数字,该数字是报头的长度

#客户端开始发送

conn.send(head_len_bytes) #先发报头的长度,4个bytes

conn.send(head_bytes) #再发报头的字节格式

conn.sendall(文件内容) #然后发真实内容的字节格式

#服务端开始接收

head_len_bytes=s.recv(4) #先收报头4个bytes,得到报头长度的字节格式

x=struct.unpack(‘i‘,head_len_bytes)[0] #提取报头的长度

head_bytes=s.recv(x) #按照报头长度x,收取报头的bytes格式

header=json.loads(json.dumps(header)) #提取报头

#最后根据报头的内容提取真实的数据,比如

real_data_len=s.recv(header[‘file_size‘])

s.recv(real_data_len)

关于struct的详细用法

关于struct的详细用法使用struct解决黏包

借助struct模块,我们知道长度数字可以被转换成一个标准大小的4字节数字。因此可以利用这个特点来预先发送数据长度。

| 发送时 | 接收时 |

| 先发送struct转换好的数据长度4字节 | 先接受4个字节使用struct转换成数字来获取要接收的数据长度 |

| 再发送数据 | 再按照长度接收数据 |

服务端(自定制报头)

服务端(自定制报头) 客户端(自定制报头)

客户端(自定制报头)

我们还可以把报头做成字典,字典里包含将要发送的真实数据的详细信息,然后json序列化,然后用struck将序列化后的数据长度打包成4个字节(4个自己足够用了)

| 发送时 | 接收时 |

|

先发报头长度 |

先收报头长度,用struct取出来 |

| 再编码报头内容然后发送 | 根据取出的长度收取报头内容,然后解码,反序列化 |

| 最后发真实内容 | 从反序列化的结果中取出待取数据的详细信息,然后去取真实的数据内容 |

服务端:定制稍微复杂一点的报头

服务端:定制稍微复杂一点的报头 客户端

客户端

FTP作业:上传下载文件

服务端

服务端 客户端

客户端六.socket的更多方法介绍

更多方法

更多方法 send和sendall方法

send和sendall方法

七.验证客户端链接的合法性

如果你想在分布式系统中实现一个简单的客户端链接认证功能,又不像SSL那么复杂,那么利用hmac+加盐的方式来实现

服务端

服务端 客户端(合法)

客户端(合法) 客户端(非法:不知道加密方式)

客户端(非法:不知道加密方式) 客户端(非法:不知道secret_key)

客户端(非法:不知道secret_key) 八.socketserver

解读socketserver源码 —— http://www.cnblogs.com/Eva-J/p/5081851.html

server端

server端 client

client