标签:文件夹权限 代码 下载 blank ... 技术分享 www 3.5 mapr

1. 安装准备

(1)必须安装jdk:

因为hadoop是基于Java实现的,所有必须安装jdk

是JDK不是jre

(2)系统位数

(3)创建专用用户

useradd hadoop

passwd hadoop

为hadoop用户授予将要使用的文件夹权限

使用的文件夹有安装文件夹、数据存放文件夹(可以自定义)。

ps:lz放在了home/hadoop文件夹

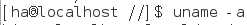

2. hadoop下载

推荐下载二进制(binary)不需要自己编译。hadoop2.8.4大约230M

ps:Linux下直接运行下载:wget http://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-2.8.4/hadoop-2.8.4.tar.gz

解压

tar xzf hadoop-2.8.4.tar.gz

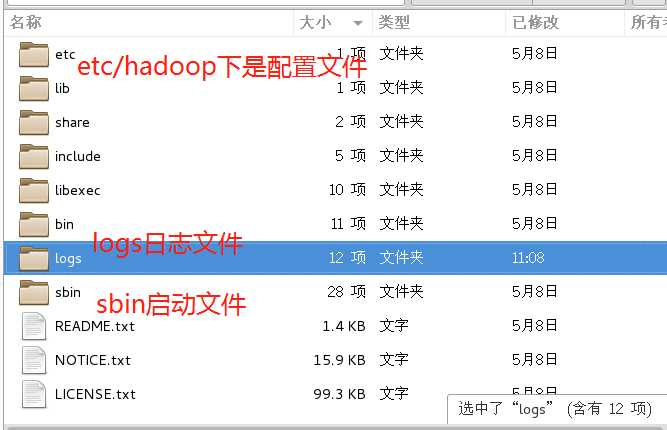

hadoop目录几个如下

先记住这三个文件即可

3. hadoop配置

3.1添加hadoop环境

在hadoop用户下配置hadoop环境(只对hadoop用户有效)

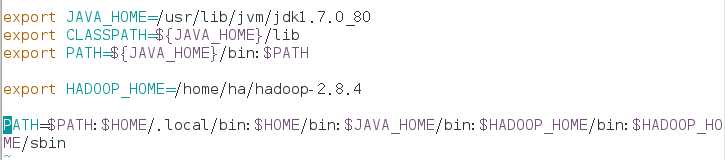

在hadoop的环境变量配置文件中添加下面代码

ps:最后一行PATH=...本来就有的,只要用冒号(英文)分割,加入新加入的环境变量名称即可。(类似win中path,使用分号分隔的情况)

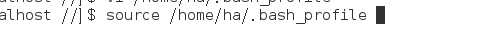

重新加载环境变量配置文件

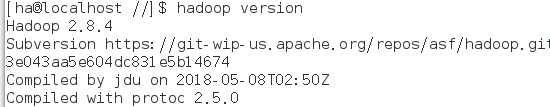

测试是否成功:

hadoop version

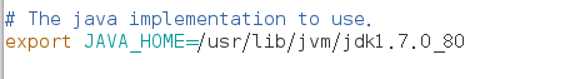

3.2 配置hadoop-env.sh

位置:在hadoop/etc/hadoop下

加入Java的路径

ps:建议使用决路径,不推荐使用${JAVA_HOME},lz使用这种hadoop找不到JAVA_HOME 。(可能是个别原因)

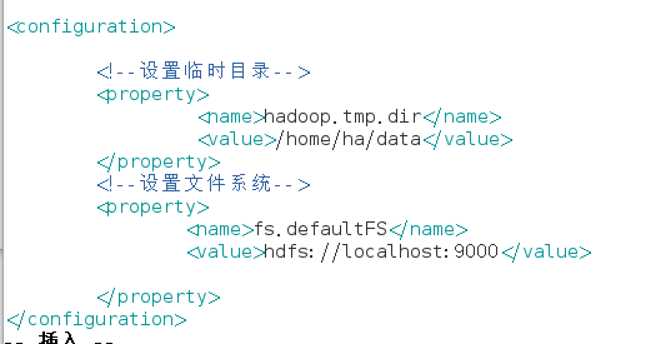

3.3 配置core-site.xml文件

写入下列内容

ps:hadoop用户必要有临时目录读写权限,最好所有者是hadoop

ps:确保端口被占用

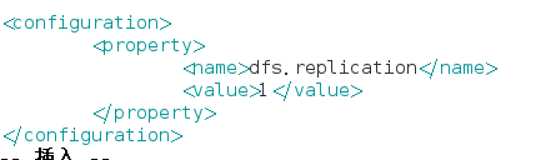

3.4 配置hdfs-site,xml

写入冗余份数,默认3份。

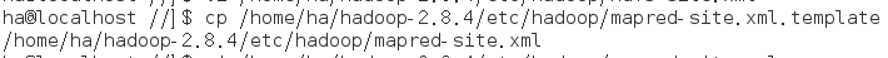

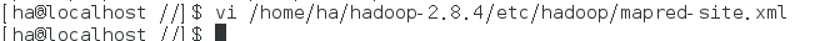

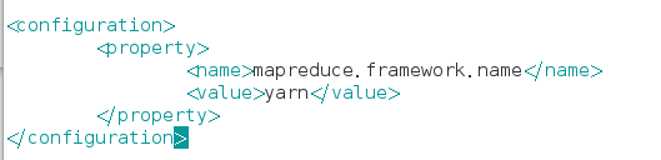

3.5 配置mapred-site.xml

使用mapred-site.xml.template模板复制得到mapred-site.xml

进行配置

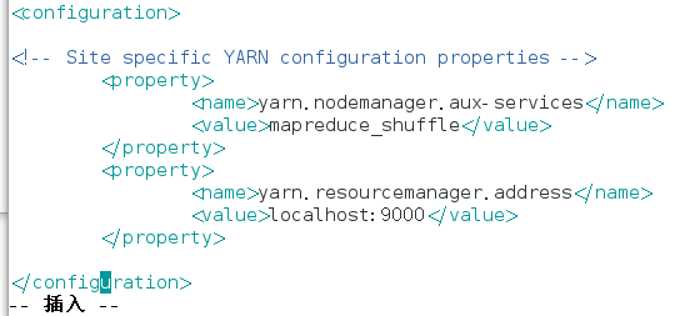

3.6配置yarn-site.xml

4启动hadoop

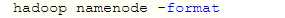

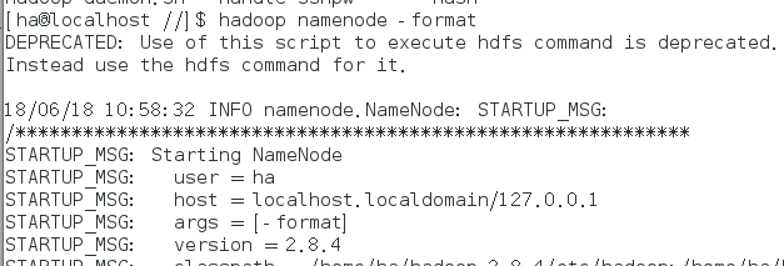

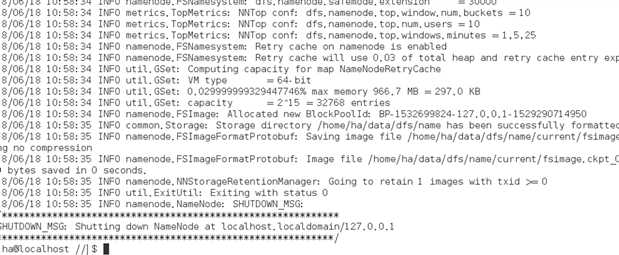

4.1.格式化

失败原因分析:

权限问题

Java环境变量

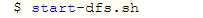

4.2 启动hdfs

需要入三次密码hadoop账户密码

4.3 启动 yarm

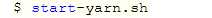

使用jps查看是否启动成功

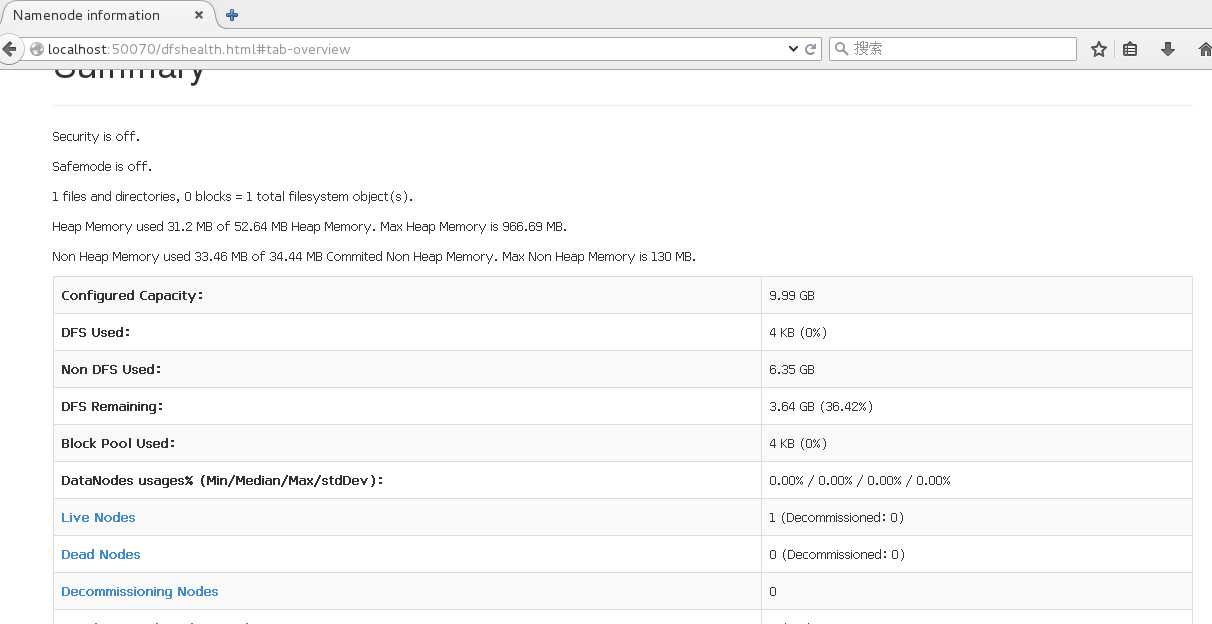

4.4浏览器查看

Linux机器上使用浏览器查看

5.总结

出现失败的原因主要是hadoop的权限和Java问题

标签:文件夹权限 代码 下载 blank ... 技术分享 www 3.5 mapr

原文地址:https://www.cnblogs.com/qingkongwuyun/p/9194942.html