标签:而在 成本 技术分享 com 机器 6.2 nbsp 输出变量 sub

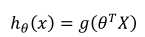

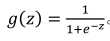

回归问题的输出可能是很大的数,而在分类问题中,比如二分类,希望输出的值是0或1,如何将回归输出的值转换成分类的输出0,1成为关键。

其中:

hθ(x)的作用是,对于给定的输入变量,根据选择的参数计算输出变量=1的可能性即hθ(x)=P(y=1|x;θ)。

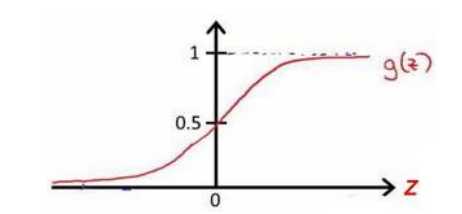

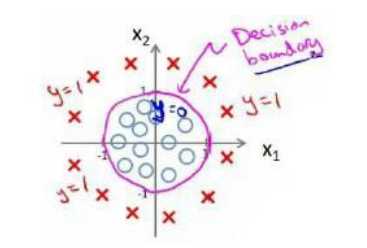

g(z)中的z即为判定边界,如下

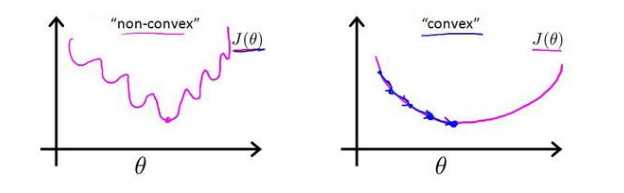

如果用之前回归时用的平方损失函数,代价函数将是非凸函数,会收敛到局部最优,而不是全局最优。

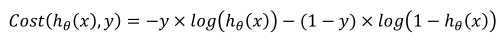

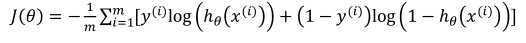

定义新的代价函数:

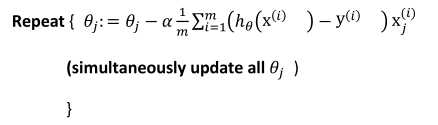

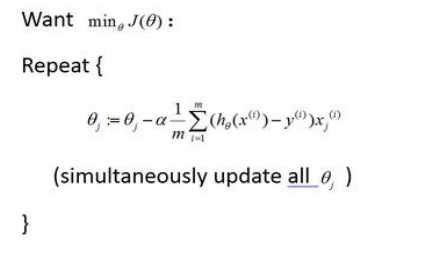

求导结果:

虽然式子看上去与回归的相同,但是hθ(x)实际定义不一样,所以二者是两回事。

共轭梯度法、变尺度法、限制变尺度法。

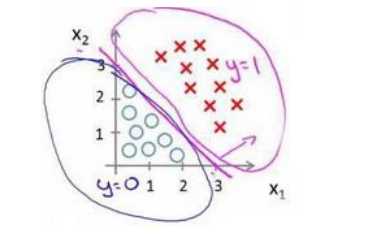

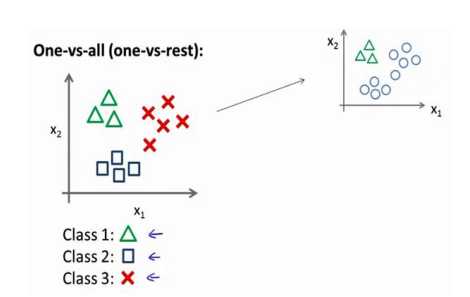

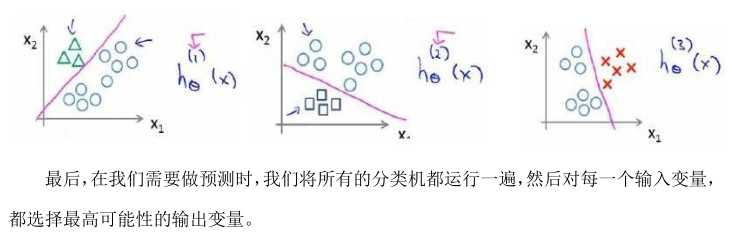

将某一类分为一类,剩余的其他类分为另一类,如下所示:

得到多个分类器,取分值最高的分类器作为判别:

标签:而在 成本 技术分享 com 机器 6.2 nbsp 输出变量 sub

原文地址:https://www.cnblogs.com/ys99/p/9251549.html