标签:response main homepage ons pid nbsp import 展示 com

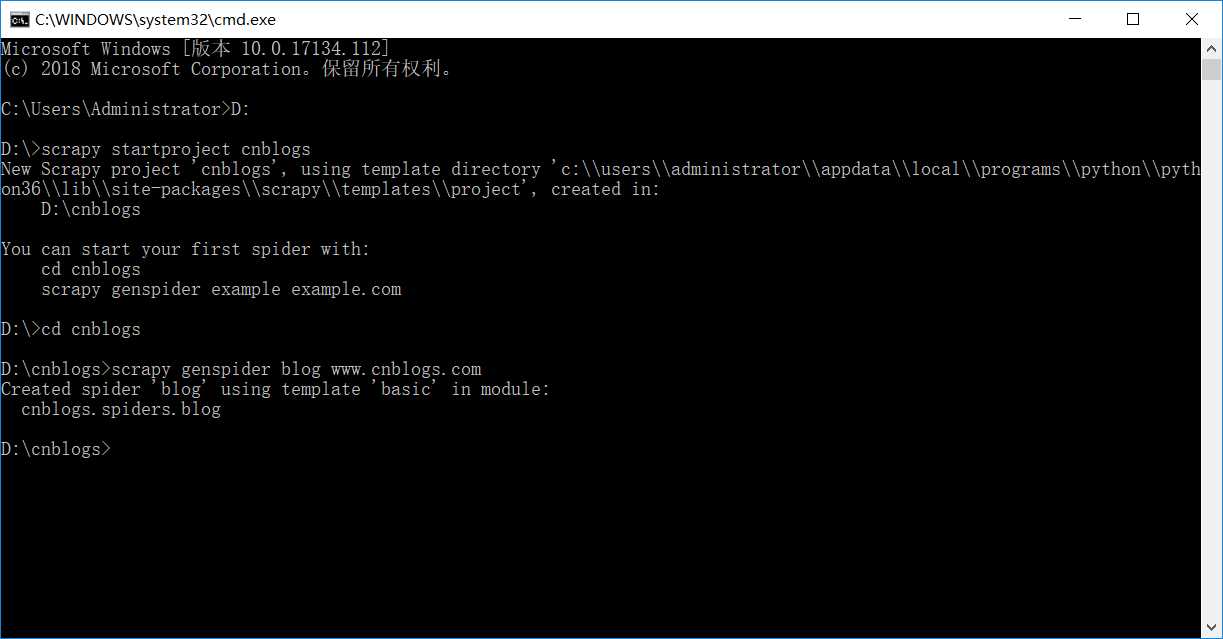

D:

进入D盘

scrapy startproject cnblogs

创建博客园项目

cd cnblogs

进入项目根目录

scrapy genspider blog www.cnblogs.com

创建爬虫文件

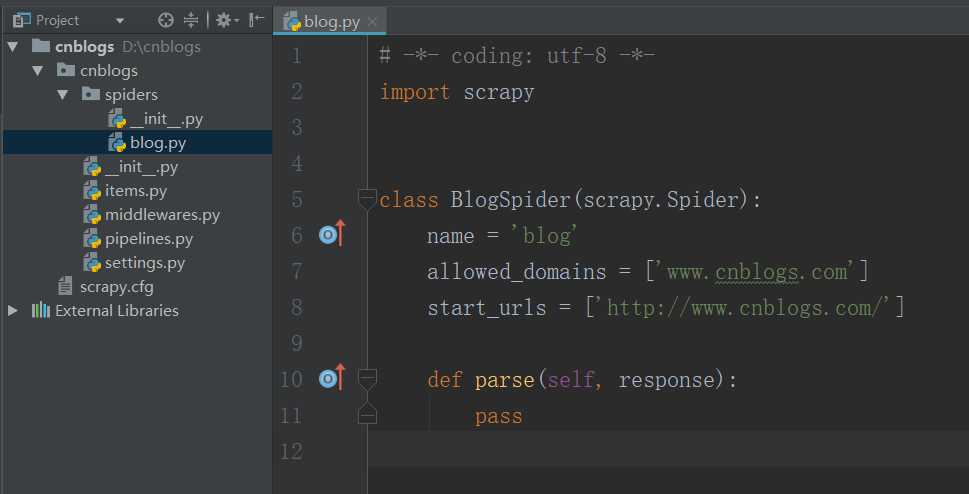

blog.py:

# -*- coding: utf-8 -*-

import scrapy

class BlogSpider(scrapy.Spider):

name = ‘blog‘

allowed_domains = [‘www.cnblogs.com‘]

start_urls = [‘http://www.cnblogs.com/‘]

def parse(self, response):

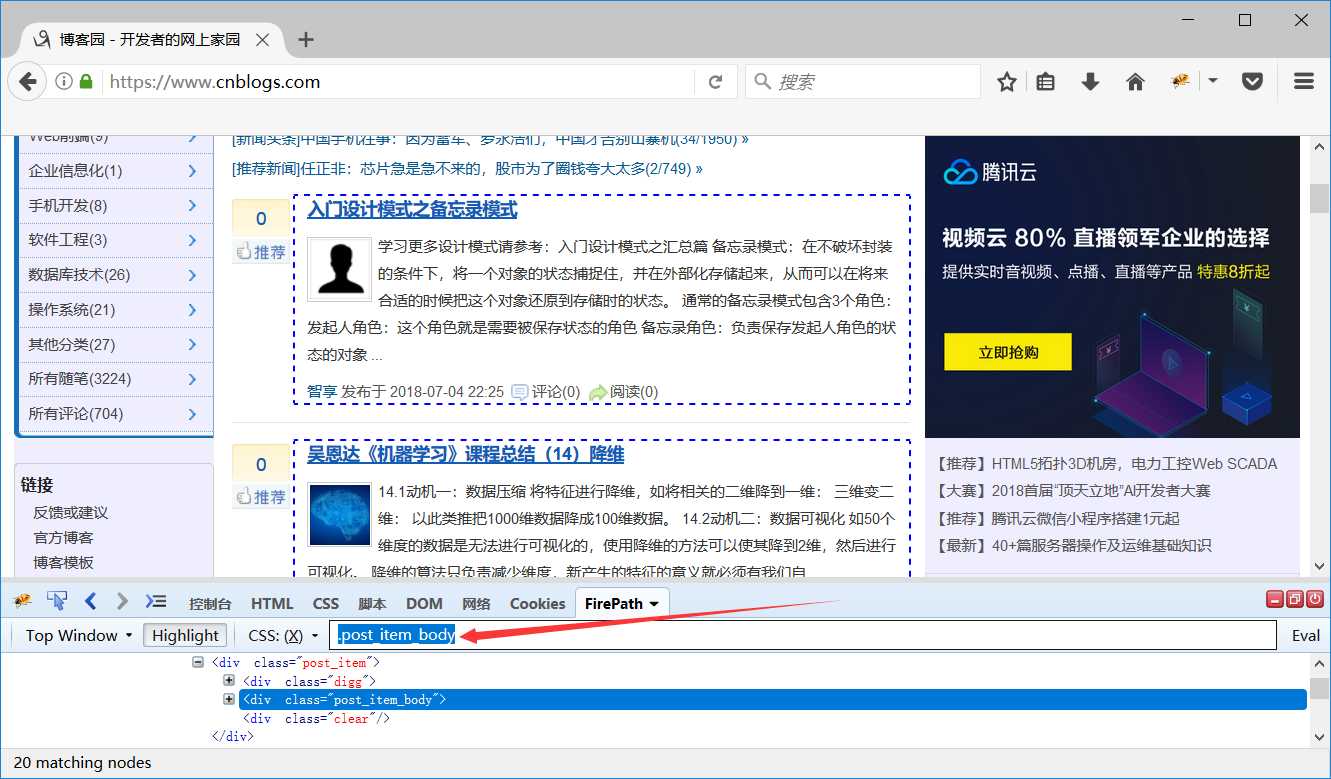

homePage = response.css(‘div.post_item_body‘)

# 提取首页展示的正文,保存至变量homePage

for v in homePage:

# 循环获取每一条里面的标题与作者

titlelnk = v.css(‘.titlelnk::text‘).extract_first()

# 提取标题

lightblue = v.css(‘.lightblue::text‘).extract_first()

# 提取作者

"""

接下来进行写文件操作,每个名人的名言储存在一个txt文档里面

"""

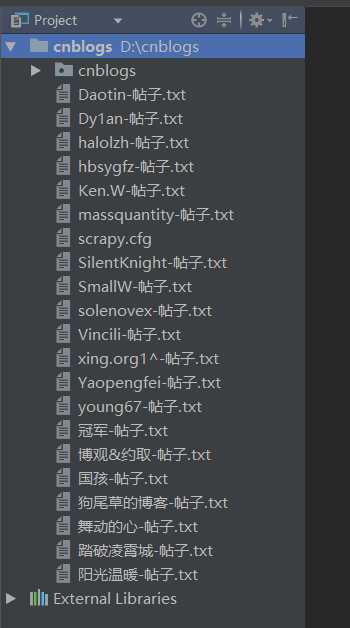

fileName = ‘%s-帖子.txt‘ % lightblue

# 定义文件名,如:作者-帖子.txt

with open(fileName, "a+") as f:

# 不同作者的标题保存在不同的txt文档,“a+”以追加的形式

f.write(titlelnk)

f.close()

scrapy crawl blog

运行爬虫

首页展示的20条博客的标题和作者:

标签:response main homepage ons pid nbsp import 展示 com

原文地址:https://www.cnblogs.com/yjlch1016/p/9266065.html