标签:mys 使用 col sql 9.png hdfs 默认目录 alt zha

“导入工具”导入单个表从RDBMS到HDFS。表中的每一行被视为HDFS的记录。所有记录都存储为文本文件的文

本数据(或者Avro、sequence文件等二进制数据)

下面的语法用于将数据导入HDFS:$ sqoop import (generic-args) (import-args)

下面的命令用于从MySQL数据库服务器中的emp表导入HDFS:

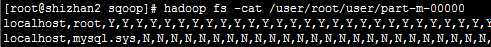

$bin/sqoop import --connect jdbc:mysql://shizhan2:3306/mysql \ --username root --password root --table user --m 1

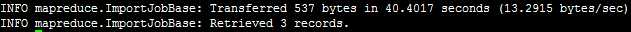

导入成功,会有如下输出:

如果没有指定该表导入到那个目录,将使用默认目录,为了验证在HDFS导入的数据,请使用以下命令查看导入的数据:

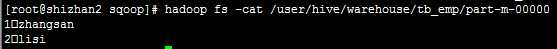

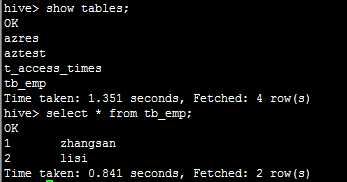

bin/sqoop import --connect jdbc:mysql://shizhan2:3306/mysql --username root --password root --table tb_emp --hive-import --m 1

在HDFS中Hive的默认目录下查看:

在导入表数据到HDFS使用Sqoop导入工具,我们可以指定目标目录。

例如下面的命令是用来导入emp_add表数据到‘/queryresult‘目录

bin/sqoop import --connect jdbc:mysql://shizhan2:3306/mysql \ --username root --password root --target-dir /queryresult --table tb_emp --m 1

标签:mys 使用 col sql 9.png hdfs 默认目录 alt zha

原文地址:https://www.cnblogs.com/yaboya/p/9324343.html