标签:ble 公司 行数据 pytho nbsp row 编程 double 分享图片

用惯了python或者R语言的DataFrame格式,对spark的RDD编程模式一开始上手可能有点不习惯。本文简单梳理一下spark中常用的RDD操作。

1.初始化spark环境

2.读取本地文件

读取本地文件之后,一般都是转换成Row类型RDD,方便后续操作;同时RDD转成DataFrame前,一定要先转化成Row类型的RDD。

当然,也可以将读取文件和转化成Row类型RDD写在一行代码中:

3.RDD转成DataFrame

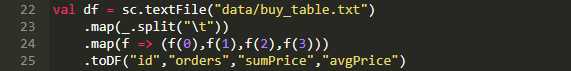

当然,我们依然可以用一行代码,将2、3步合并为一步,直接将读取的RDD转化成DataFrame,结果和上面是一样的;代码的含义为:选取了第1、2、3、4列生成DataFrame,列名为"id","orders","sumPrice","avgPrice"。

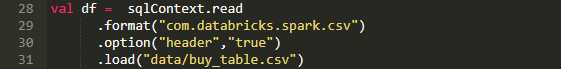

4.Spark Sql直接读取csv文件为DataFrame

如果是csv格式文件,可以直接利用spark sql读取成DataFrame,其中"com.databricks.spark.csv",是利用到了由databricks公司开发并开源外部数据源接口,通过这个类库我们才可以在spark sql中解析并查询CSV中的数据。

5.数值类型转换

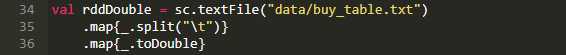

spark默认以String类型读取本地数据,我们可以根据需求,在读取数据过程中进行数据类型转换,例如转换成Double类型:

也可以用map函数将指定的列进行数据类型转换,其他列不变;例如只将第2、3个字段转换成Double:

标签:ble 公司 行数据 pytho nbsp row 编程 double 分享图片

原文地址:https://www.cnblogs.com/solong1989/p/9342589.html