标签:RoCE link use 资源限制 版本号 malloc nss 无法 命令

【taskset详解】

taskset设置cpu亲和力,taskset能够将一个或者多个进程绑定到一个或者多个处理器上运行

参数:

选项:

-a, --all-tasks 在给定 pid 的所有任务(线程)上操作

-p, --pid 在存在的给定 pid 上操作

-c, --cpu-list 以列表格式显示和指定 CPU

-h, --help 显示此帮助

-V, --version 输出版本信息

案例:设置nginx cpu亲合力

在conf/nginx.conf中,

worker_processes 4;用来配置 nginx启动几个工作进程 的,默认为1,而nginx还支持一个名为worker_cpu_affinity的配置项,也就是说nhinx可以为每个工作进程绑定CPU,

worker_cpu_affinity 00000001 00000010 00000100 00001000 ;

这里0001,0010, 0100, 01000是掩码,分别代表第1,2,3,4等四颗cpu核心;

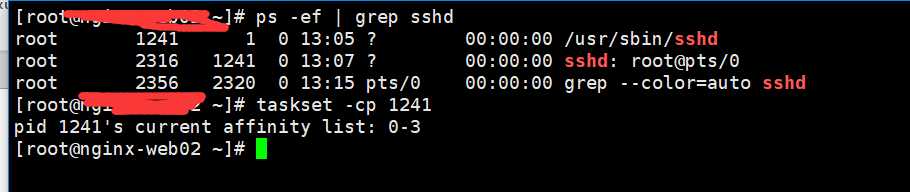

如果要想绑定nginx进程的cpu,首先要查看nginx的进程ID,随后将对应的ID取出来,通过taskset -cp 指定cpu核心数以及进程号即可

# ps -ef | grep nginx 查看nginx的主进程ID号

root 2304 1 0 13:07 ? 00:00:00 nginx: master process nginx

[root@nginx-web02 ~]# taskset -cp 0,2 2304 #设置cpu亲和力,让nginx的主进程跑cpu1和cpu3上面

pid 2304‘s current affinity list: 0-3 #未绑定之前是跑在所有1-4个cpu上面

pid 2304‘s new affinity list: 0,2 #绑定之后,只跑在cpu1和cpu3上面

另外我们可以通过taskset -cp 【进程号】查看某服务的进程ID跑在拿个CPU上面,如下所示

【设置docker容器cpu亲和力】

# docker run -itd --name centosv2 --cpuset-cpus 1-2 49f7960eb7e4 #通过“--cpuset-cpus“参数,让一个容器进程只在cpu2-3上面运行

我们可以在"/sys/fs/cgroup/system.slice/"这个目录查看docker容器生成的绑定cpu核心数

#cat /sys/fs/cgroup/cpuset/system.slice/docker-e5ea5af23654a142518c3076395ff02a6ff2869708b59852abaf84614a70d665.scope/cpuset.cpus

1-2

进程容器测试

可以通过docker exec (容器ID或者名称)taskset -cp (1容器内部第一个编号一般为1),可以看到容器进程与CPU绑定关系,可以认为达到了绑定CPU内核的目的

# docker exec centosv2 taskset -cp 1

pid 1‘s current affinity list: 1,2

【cpu配额控制参数的混合使用】

在上面的参数中,cpu-shares控制只发生在容器竞争同一个内核的时间片段,如果通过cpuset-cpus制定容器A使用内核0,容器B使用内核1,在主机上只有这两个容器使用对应内核情况,那么cpu-share没有明显效果

cpu-period,cpu-quota这两个参数联合使用,在单核情况下或者的通过cpuset-cpus强制容器使用一个cpu内核的情况下,即使cpu-quota超过cpu-period,也不会让容器使用更多的cpu资源

cpuset-cpus,cpuset-mems只在多核,多内存节点上的服务器有效,并且必须要与实际 的物理配置匹配吗否则无法达到资源控制的目的

例子:测试cpuset-cpus和cpu-shares混合使用运行效果,就需要一个压力测试工具stress来让容器把实例cpu跑满

工具安装部分

stress是linux系统压力测试软件,stress可以测试linux系统cpu,menory,IO,disk的负载

wget http://people.seas.harvard.edu/~apw/stress/stress-1.0.4.tar.gz

tar zxvf stress-1.0.4.tar.gzcd stress-1.0.4

./configure --prefix=/usr/local/stress

make

make install

stress参数详解: -? 显示帮助信息 -v 显示版本号 -q 不显示运行版本 -n 显示已完成的指令情况 -t --timeout N 指定运行 N秒后停止 --backoff N 等待N微妙后开始运行 -c 产生n个进程,每个进程都会反复不停的计算随机数的平方根,测试CPU -i 产生n个进程,每个进程反复调用sync(),sync()用于将内存上面的内容写到硬盘上面,测试硬盘磁盘IO -m --vm n产生N个进程,每个进程不断调用内存分配malloc和内存释放free 测试内存 --vm-bytes B 指定malloc时内存的字节数(默认256MB) --vm-hang N 指定在free栈的秒数 -d -hadd n产生n个执行write和unlink函数的进程 -hadd-bytes B 指定写的字节数 --hadd-noclean 不 unlink

# cd /usr/local/stress/

# ./bin/stress -c 2 -i 2 --verbose --timeout 20s #2个进程,2个IO进程,20秒后停止

[Docker容器cpu资源隔离和限制]---重点内容

实例1:测试cpuset-cpus和cpus-shares混合使用运行效果,通过stress压力测试容器,将cpu跑满,当cpu跑满后,会不会去其他cpu上去运行呢?如果第一颗cpu跑满后,没有转移到第二颗cpu,那么,说明cgroup资源隔离成功

]# docker run -itd --name centosv1 --cpuset-cpus 0,1 --cpu-shares 512 49f7960eb7e4 /bin/bash

# docker run -itd --name centosv2 --cpuset-cpus 0,1 --cpu-shares 1024 49f7960eb7e4 /bin/bash

首先分别在容器内部安装scp命令,以便将宿主机的stress工具拷贝进来,在内部压测,例如进入centosv2进行压力测试,先测试一下cpu资源是够隔离,

[root@b4577f900fcc /]# yum install -y openssh-clients #在容器安装scp命令

[root@b4577f900fcc /]# scp -r root@192.168.2.151:/usr/local/stress ./ #将宿主机的stress路径拷贝到centosv2容器中,以便进行压力测试

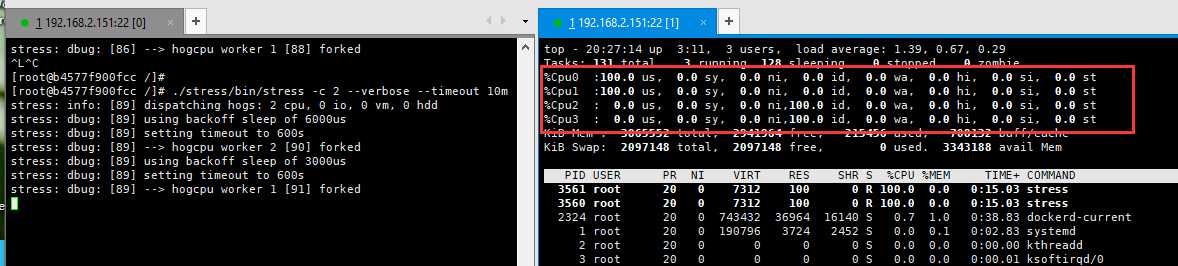

[root@b4577f900fcc /]# ./stress/bin/stress -c 2 --verbose --timeout 10m

ok~上述图中,我们可以看到CPU0和cpu2已经跑满了,只在cpu0和cpu1上面,并未在cpu 2和cpu3运行,说明cpu资源隔离成功

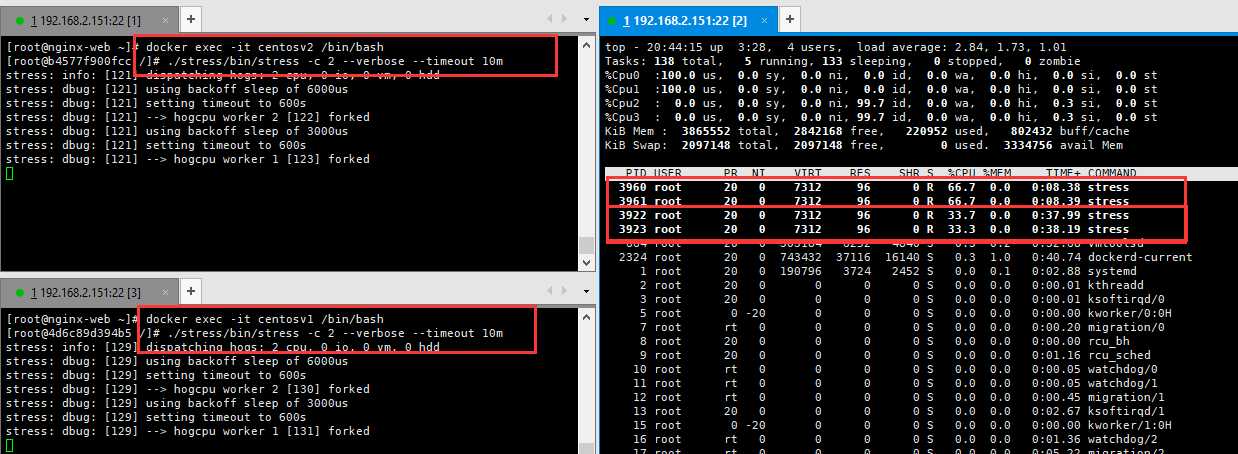

2)下面同时运行centosv1和centosv2两个容器,当时通过--cpuset-cpus设置两个容器只运行在cpu0-1上面,随后通过--cpu-shares进行cpu份额,也就是 centosv2的cpu使用率量是centosv1的两倍,我们可以很清晰的看到,两个容器使用情况,centosv2使用率为66.x%,而centosv1使用量是v2的一半,也就是33.x%,说明--cpu-shares资源限制成功

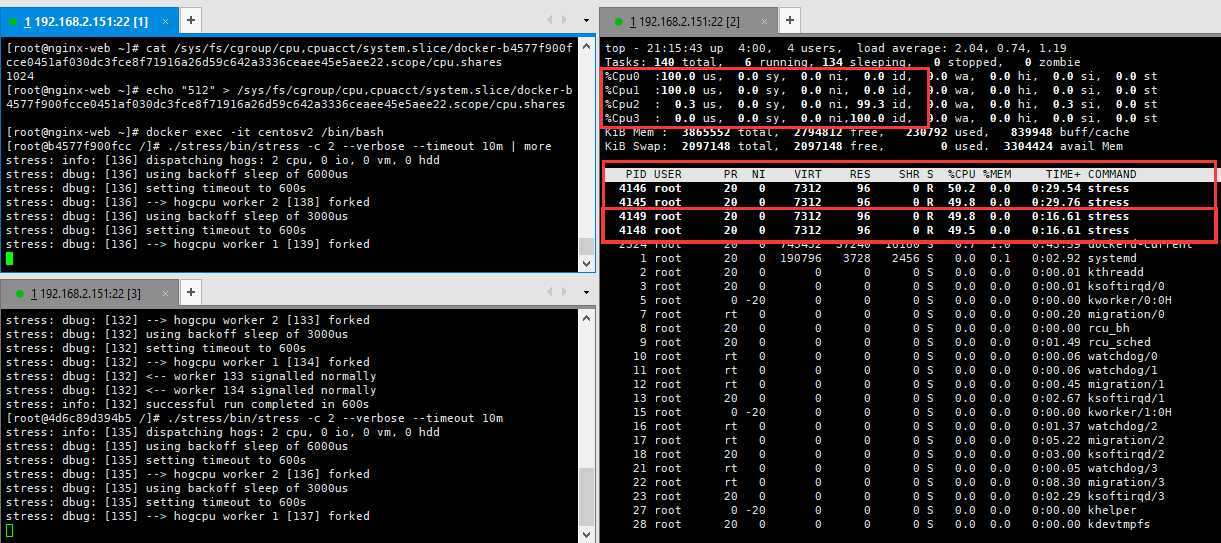

例子2:动态修改,比如说,我现在想将两个容器的cpu份额平均下来,,只需将centosv2的--cpu.shares 1024改成与centosv1相同的512即可

# docker ps | grep centosv2

b4577f900fcc 49f7960eb7e4 "/bin/bash" 2 hours ago Up 2 hours

# cat /sys/fs/cgroup/cpu,cpuacct/system.slice/docker-b4577f900fcce0451af030dc3fce8f71916a26d59c642a3336ceaee45e5aee22.scope/cpu.shares

1024

将“512”写入cpu.shares中即可,无需重启centosv2容器生效,如果找不到cpu.shares这个文件存放在那个路径,可以通过find / --name “cpu.shares”查看

[root@nginx-web ~]# echo "512" > /sys/fs/cgroup/cpu,cpuacct/system.slice/docker-b4577f900fcce0451af030dc3fce8f71916a26d59c642a3336ceaee45e5aee22.scope/cpu.shares

tasksetCPU亲和力&docker容器资源配额控制之cpu

标签:RoCE link use 资源限制 版本号 malloc nss 无法 命令

原文地址:https://www.cnblogs.com/bixiaoyu/p/9339151.html