标签:network 时间 .com 梯度 work nbsp 间隔 short font

深度学习(DL)有三大模型:CNN,RNN,DBN(深度信念网络)

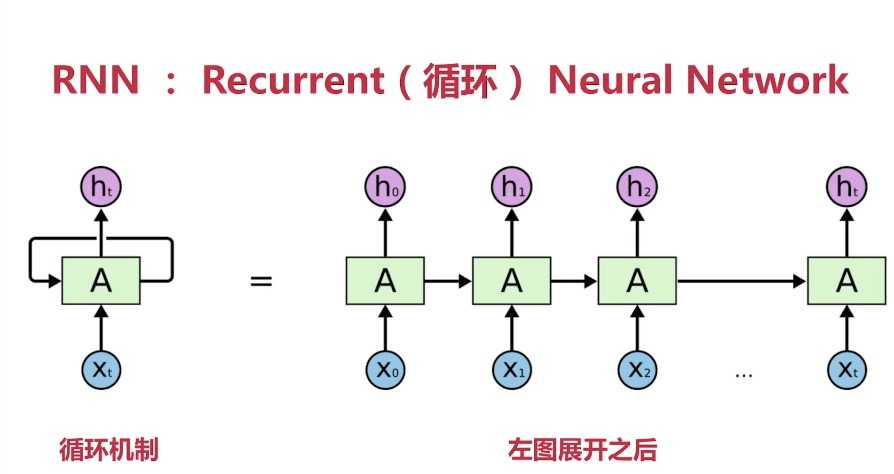

RNN:Recurrent Neural Network

RNN可以与记忆做类比,经验的累积。 读书破万卷下笔如有神!

RNN 当前产生的结果 是 <以前记忆> 和 <当前状态的叠加>

RNN每一个输出与前面的输出建立起关联,以前面的序列化对象为基础生成新的对象

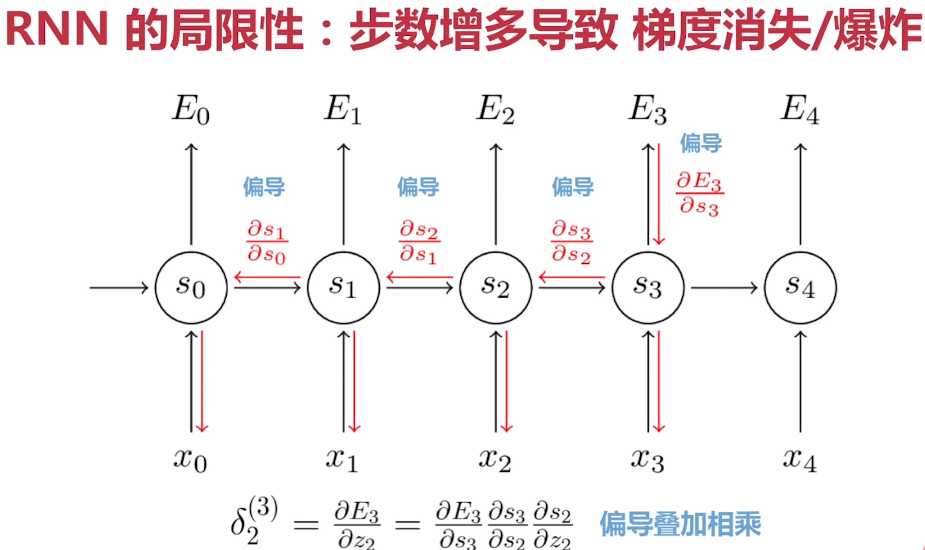

RNN的局限性:步数增多导致 梯度消失Vanshing (or Exploding) 0.9 ** 100 梯度消失 ; 1.04 ** 100 梯度爆炸

Gradient Clipping(梯度裁剪)有效解决梯度爆炸

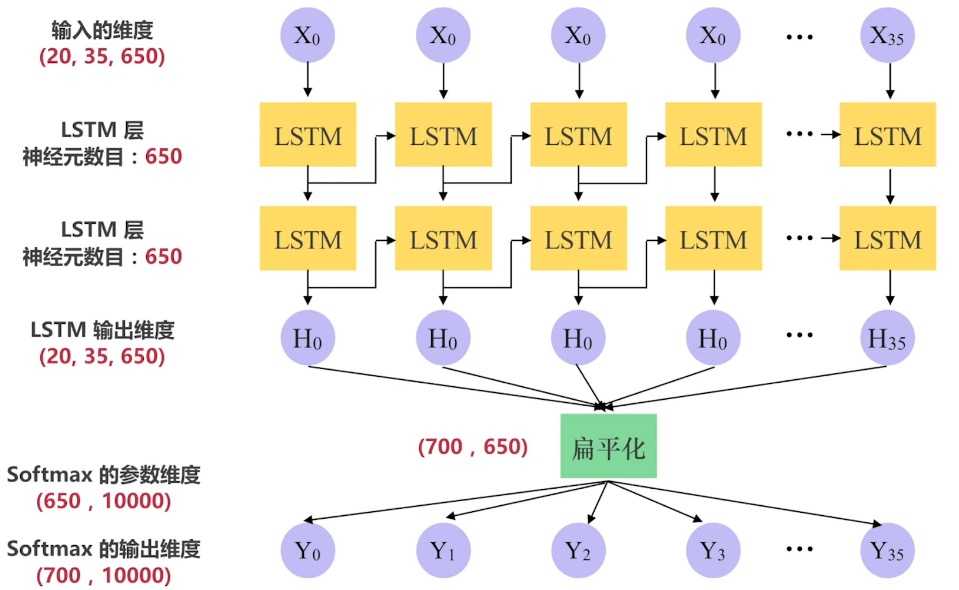

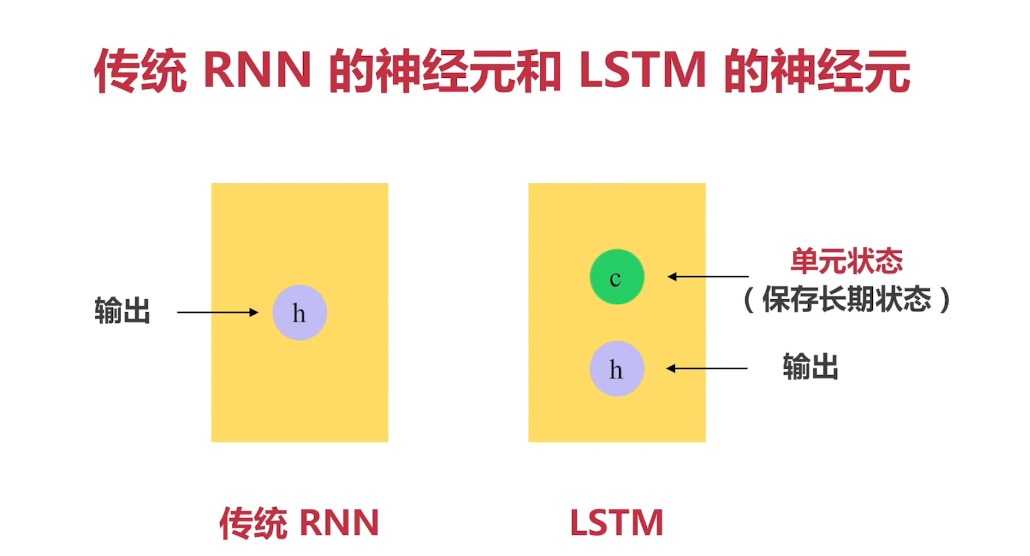

在这里介绍LSTM_RNN:

LSTM(Long Short-Term Memory)是长短期记忆网络,是一种时间递归神经网络,适合于处理和预测时间序列中间隔和延迟相对较长的重要事件

标签:network 时间 .com 梯度 work nbsp 间隔 short font

原文地址:https://www.cnblogs.com/AlexHaiY/p/9347781.html