标签:style blog http color io os ar java strong

0. 准备

出于学习目的,本文将Spark部署在虚拟机中。在虚拟机中,需要安装以下软件:

1. 安装JDK

....

2. 安装及配置SSH

....

3. 安装hadoop2.4.0

....

4. 安装scala

@下载编译好的spark,通过查看pom.xml文件得到对应Scala的版本号;

@下载对应scala:

@解压,设置环境变量:

source /etc/profile

@测试Scala:

[root@hadoop0 local]# source /etc/profile [root@hadoop0 local]# scala -version Scala code runner version 2.10.4 -- Copyright 2002-2013, LAMP/EPFL

@解压,设置环境变量

@ $SPARK_HOME/conf/ spark-env.sh

export SCALA_HOME=/usr/local/scal export JAVA_HOME=/usr/local/jdk export SPARK_MASTER_IP=localhost export SPARK_WORKER_MEMORY=1000m

启动:

#到spark安装目录下: sbin/start-all.sh

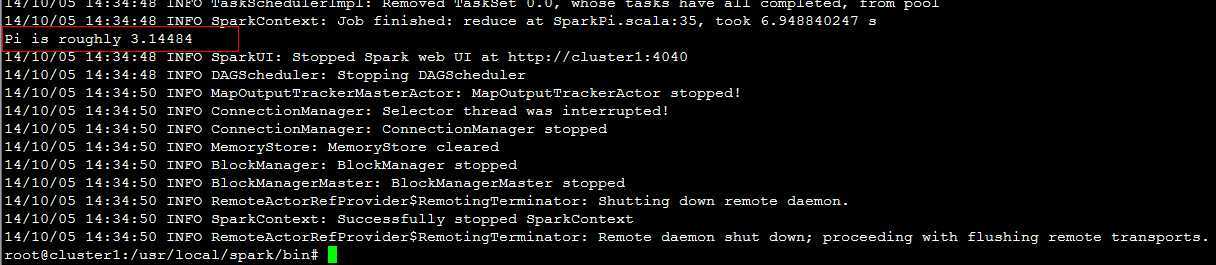

测试:

bin/run-example SparkPi

spark-1.1.0-bin-hadoop2.4.tgz安装

标签:style blog http color io os ar java strong

原文地址:http://www.cnblogs.com/muzhongjiang/p/4007030.html