一、idea社区版安装scala插件

因为idea默认不支持scala开发环境,所以当需要使用idea搭建scala开发环境时,首先需要安装scala插件,具体安装办法如下。

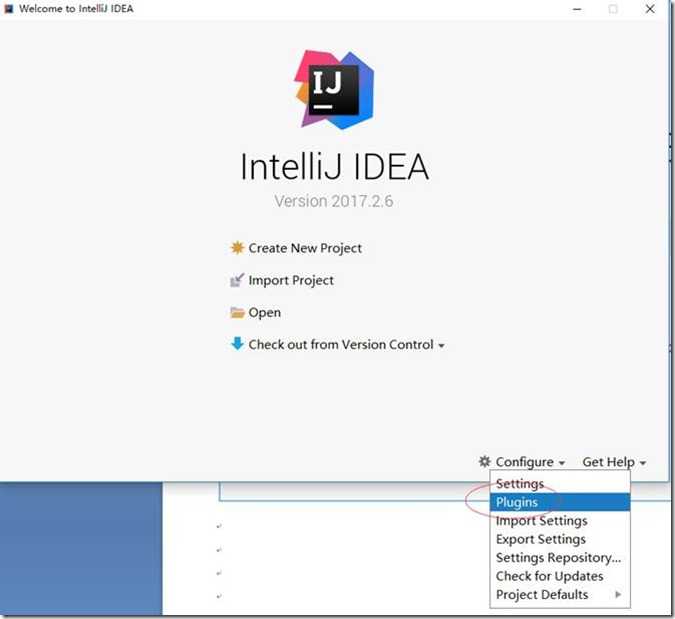

1、打开idea,点击configure下拉菜单中的plugins选项:

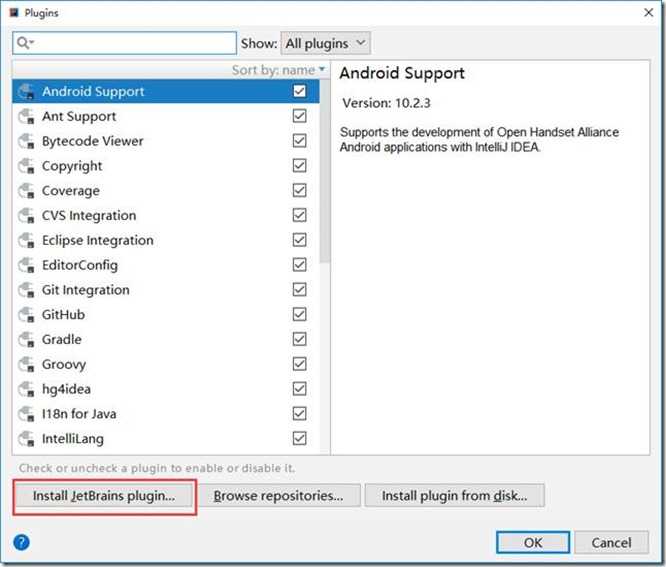

2、在弹出对话框中点击红框按钮:

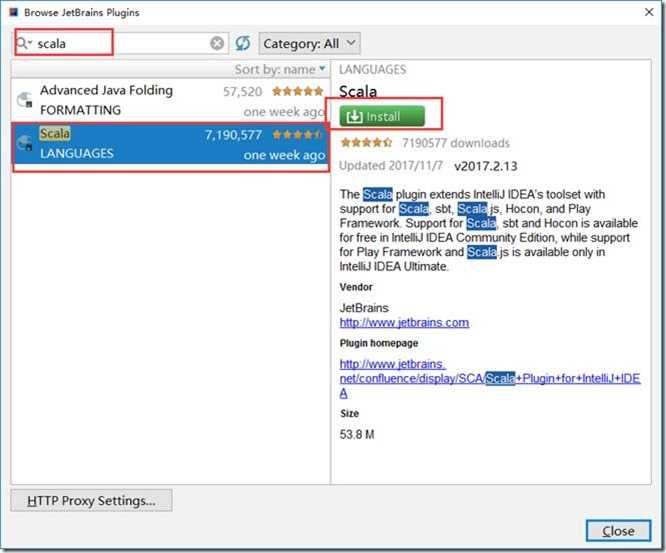

3、在弹出最新对话框的搜索栏输入scala,在筛选出的内容中选择红框部分,点击右侧install按钮开始下载插件:

本人在测试过程中通过install自动下载插件失败,最后选择手动下载scala插件,然后通过步骤2中install plugin from disk选项,选择手动下载zip包的方式安装插件成功。

二、创建scala工程

1、下载scala安装文件,并解压到d:\目录下:

https://downloads.lightbend.com/scala/2.10.6/scala-2.10.6.zip

2、打开idea开发工具,选择“create new project”,创建一个新的工程:

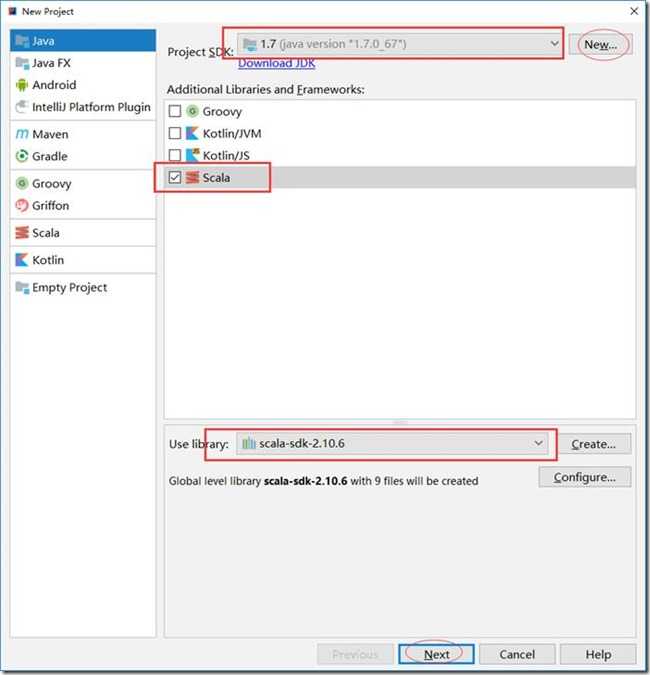

3、下图中选择jdk版本、选择scala、以及scala依赖包位置(scala安装软件位置),next:

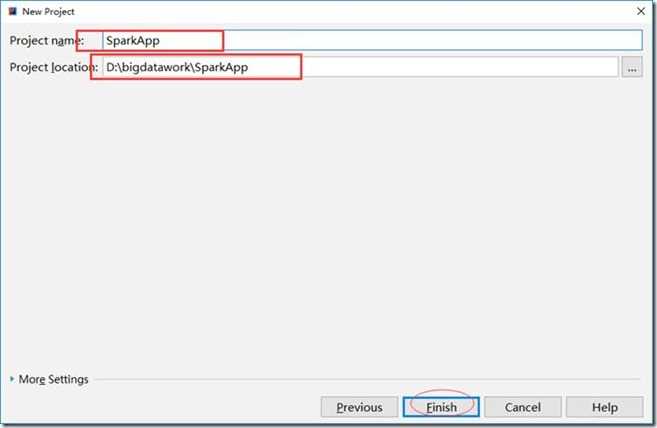

4、输入工程名称并且选择工程位置,点击finash:

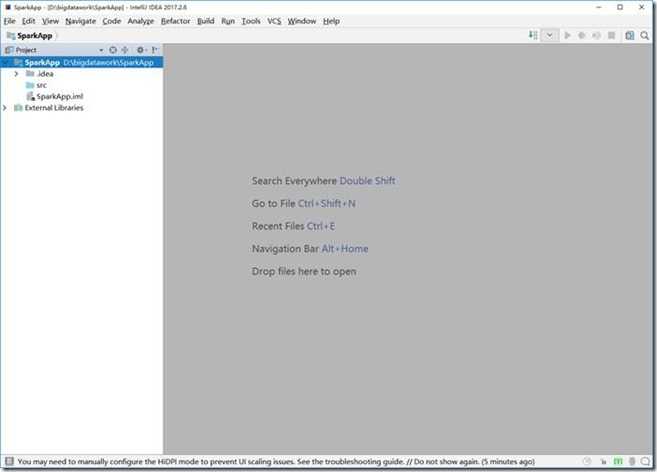

5、完成工程创建后如下:

三、配置scala工程

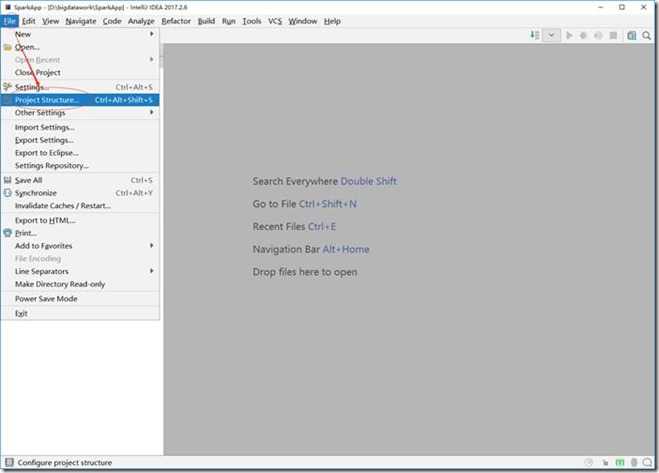

1、file->preject structure:

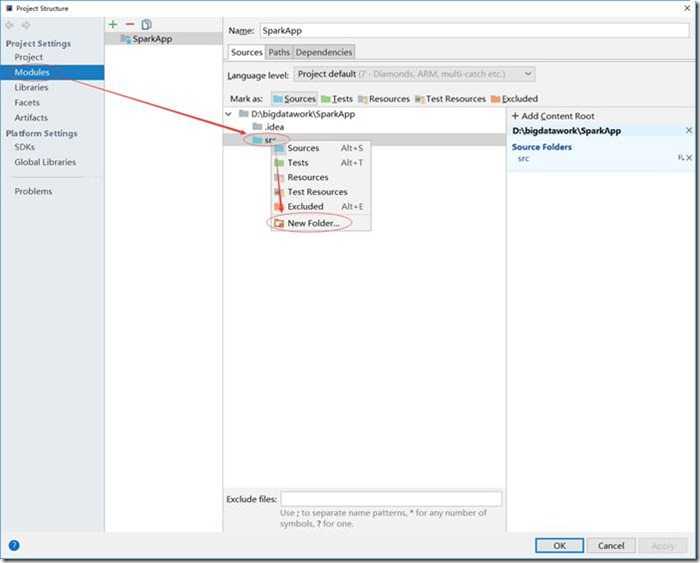

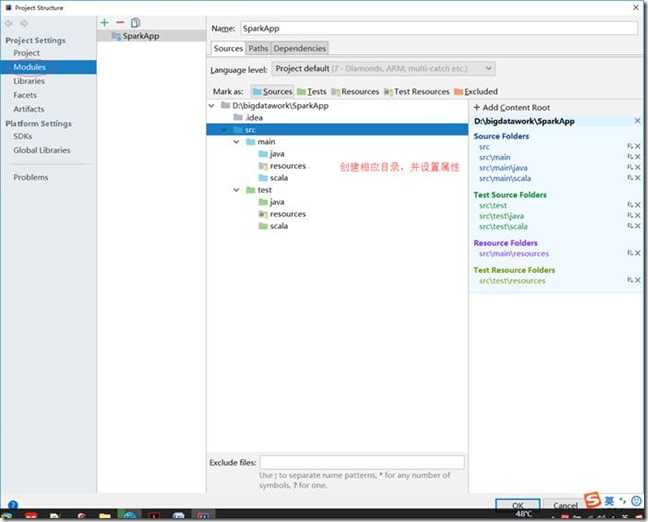

2、modulesàsrcànew folder方式创建文件夹:

3、完成文件创建后,点击ok完成配置。

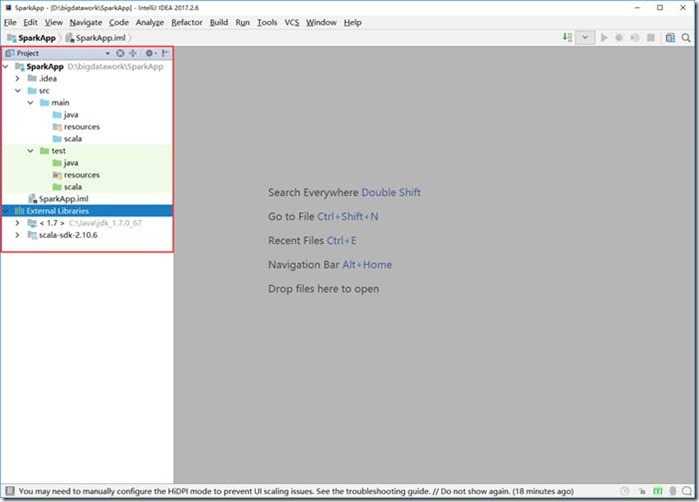

工程结构如下:

四、为工程导入spark jar包

1、首先解压缩spark安装包到d:\目录下:

D:\spark-1.3.0-bin-2.5.0-cdh5.3.6

2、fileàproject structure:

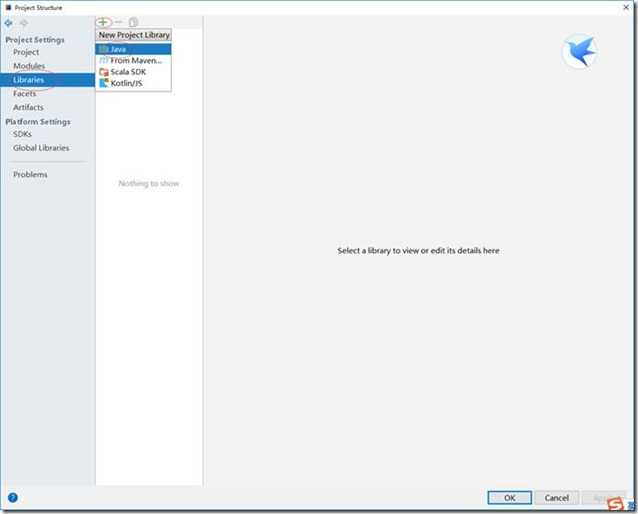

3、在对话框选择librariesà+àjava:

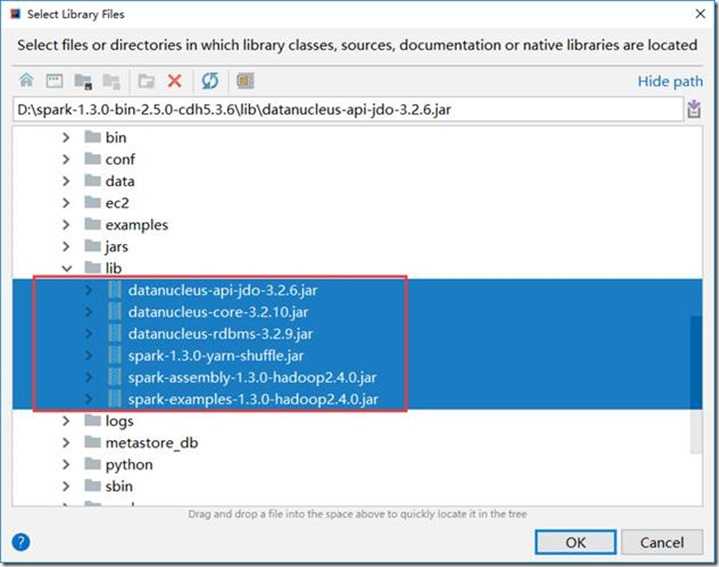

4、在弹出对话框内选择spark解压目录,选中spark lib目录下所有jar包,点击ok导入所有jar包:

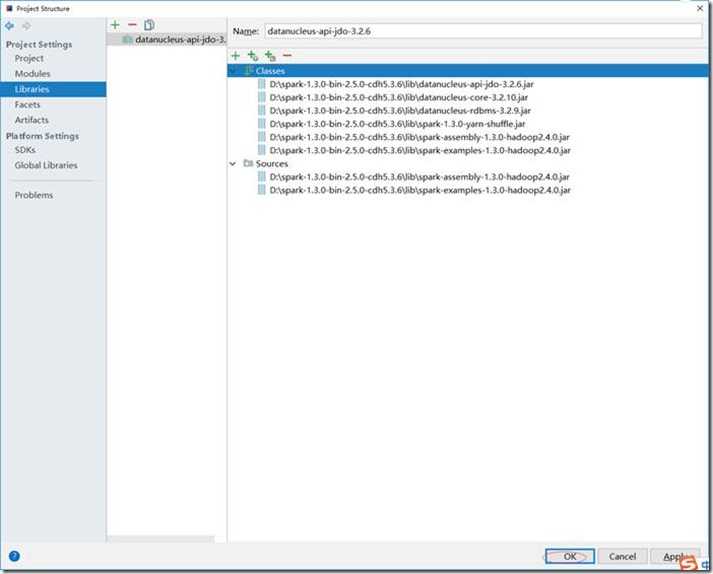

5、点击ok,完成spark jar包导入scala工程:

五、编写wordcount程序进行基准测试

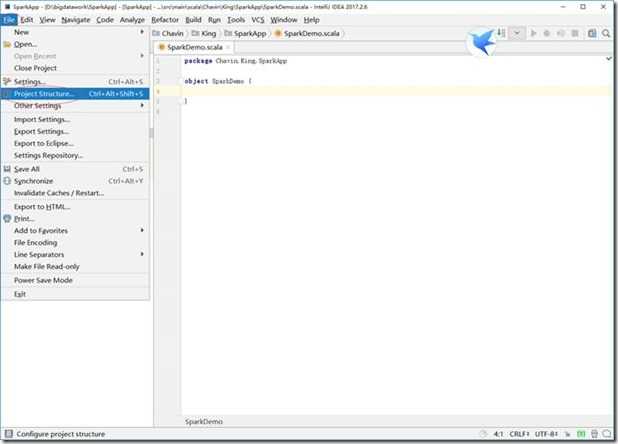

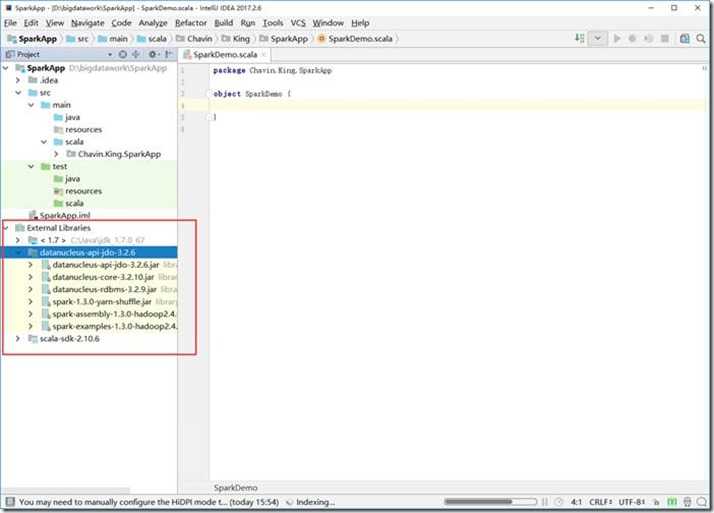

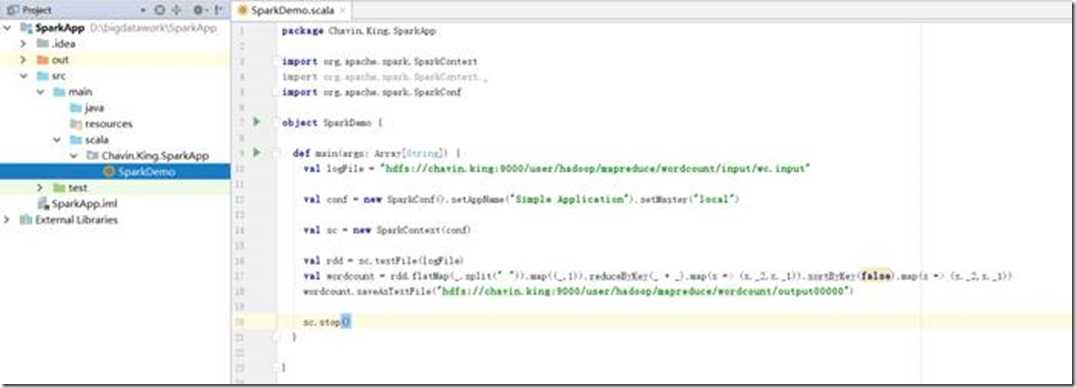

1、在scala工程中创建packet,并且创建测试spark类,并且编写wordcount程序代码,如下:

|

package Chavin.King.SparkApp |

截图如下:

2、代码完成之后,右键à选择run “SparkApp”,运行程序进行功能测试。

3、打包SparkApp程序:

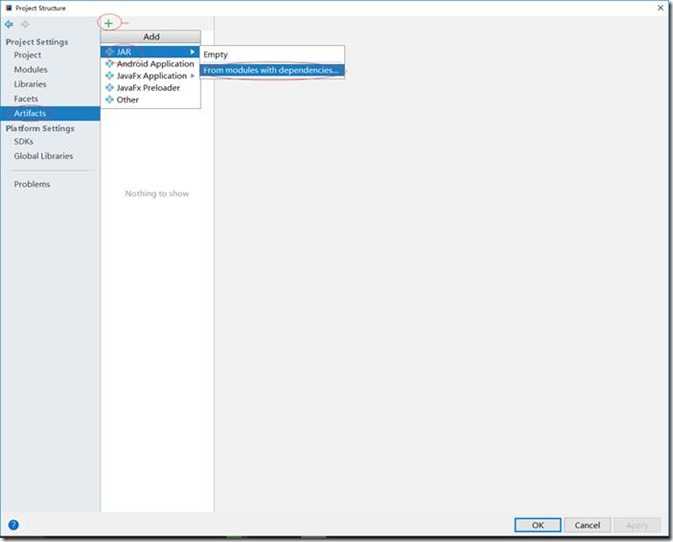

File—>preject structureàartifactsà+àJARàfrom modules with dependencies:

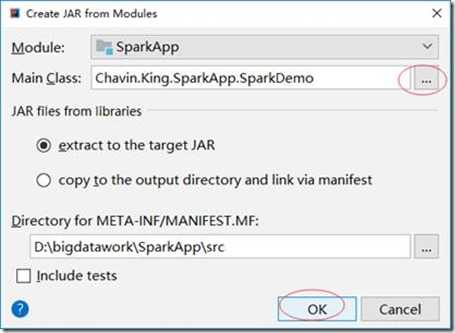

下图中选择要编译的主类,点击ok:

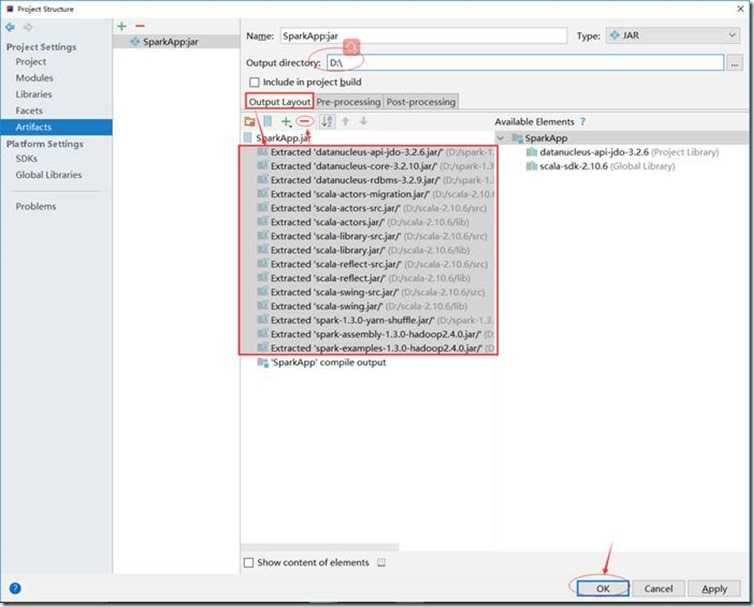

删除output layout下的所有依赖jar包,并且指定output directory,点击ok:

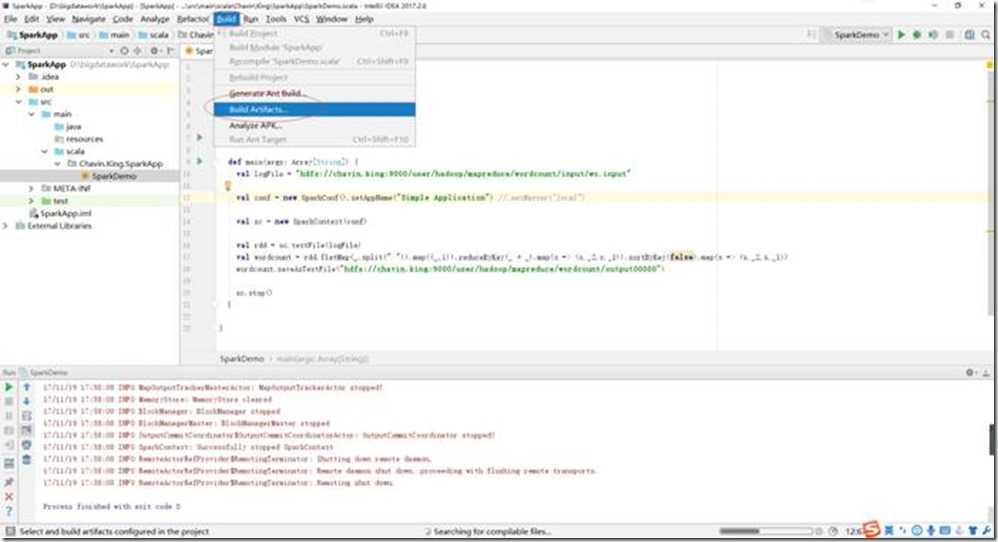

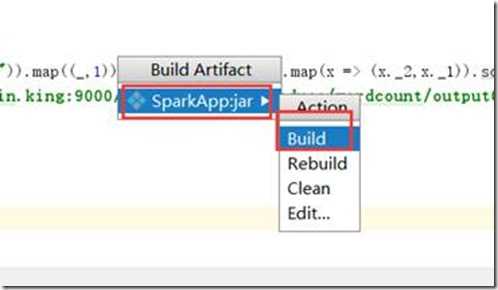

回到idea主页面,点击buildàbuild artifacts:

SaprkApp.jar—>build,进行jar包编译:

编译完成后到d:\下可以看到我们编译的jar包。

4、测试编译的jar包(SparkApp.jar):

4.1)删除hdfs输出目录:

bin/hdfs dfs -rm -r hdfs://chavin.king:9000/user/hadoop/mapreduce/wordcount/output00000

4.2)spark-submit方式测试jar包:

bin/spark-submit \

--master yarn \

--deploy-mode client \

/opt/datas/SparkApp.jar