标签:ring 地方 很多 transform 如何 vector 方差 call nbsp

Dimensionality Reduction

--Hands-on Machine Learning with Scikit-Learn and TensorFlow -Chapter 8

Introduction

Two main approaches for Dimensionalty Reduction

PCA(Principal Component Analysis)

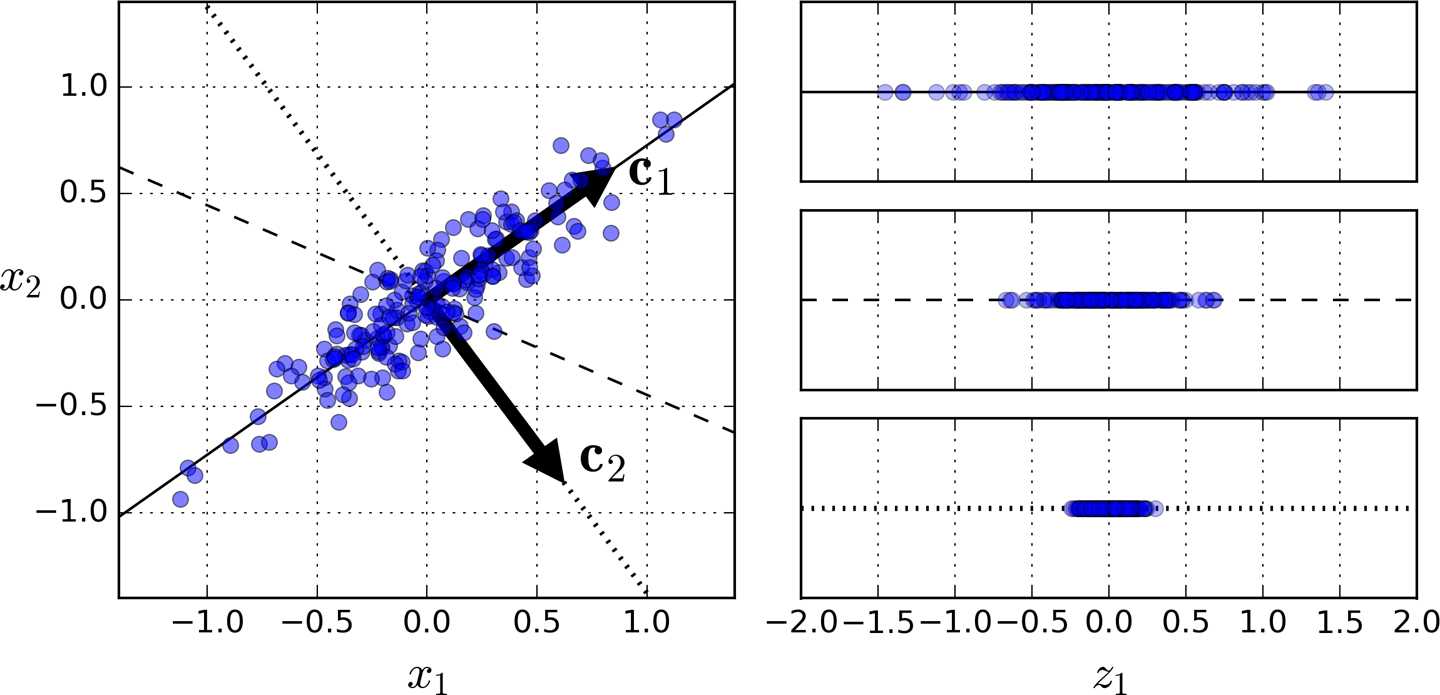

3. Principal Components:PCA identifies the axis that accounts for the largest amount of variance in the training set.

the unit vector that defines the i(th) axis is called i(th) principal component.

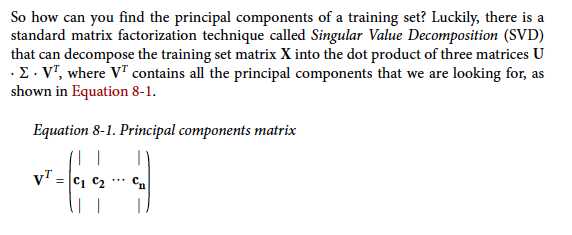

如何找到训练数据的主成分?Singular Value Decomposition(SVD)

PAC默认数据集是以愿数据为中心的。Sklearn 的pca 包已经将数据集中化处理了。而用其他方法构造pca时候,不要忘记首先集中化处理数据。(centering the data)

在降维的时候,一定要尽可能的保证更大的方差。

from sklearn.decomposition import PCA pca=PCA(n_components=2) X2D=pcd.fit_transform(X)

pca.explained_variance_ratio_

选择合适的维数

标签:ring 地方 很多 transform 如何 vector 方差 call nbsp

原文地址:https://www.cnblogs.com/makino/p/9626871.html