标签:反向 差分 oid 误差 .com art sum array 分享图片

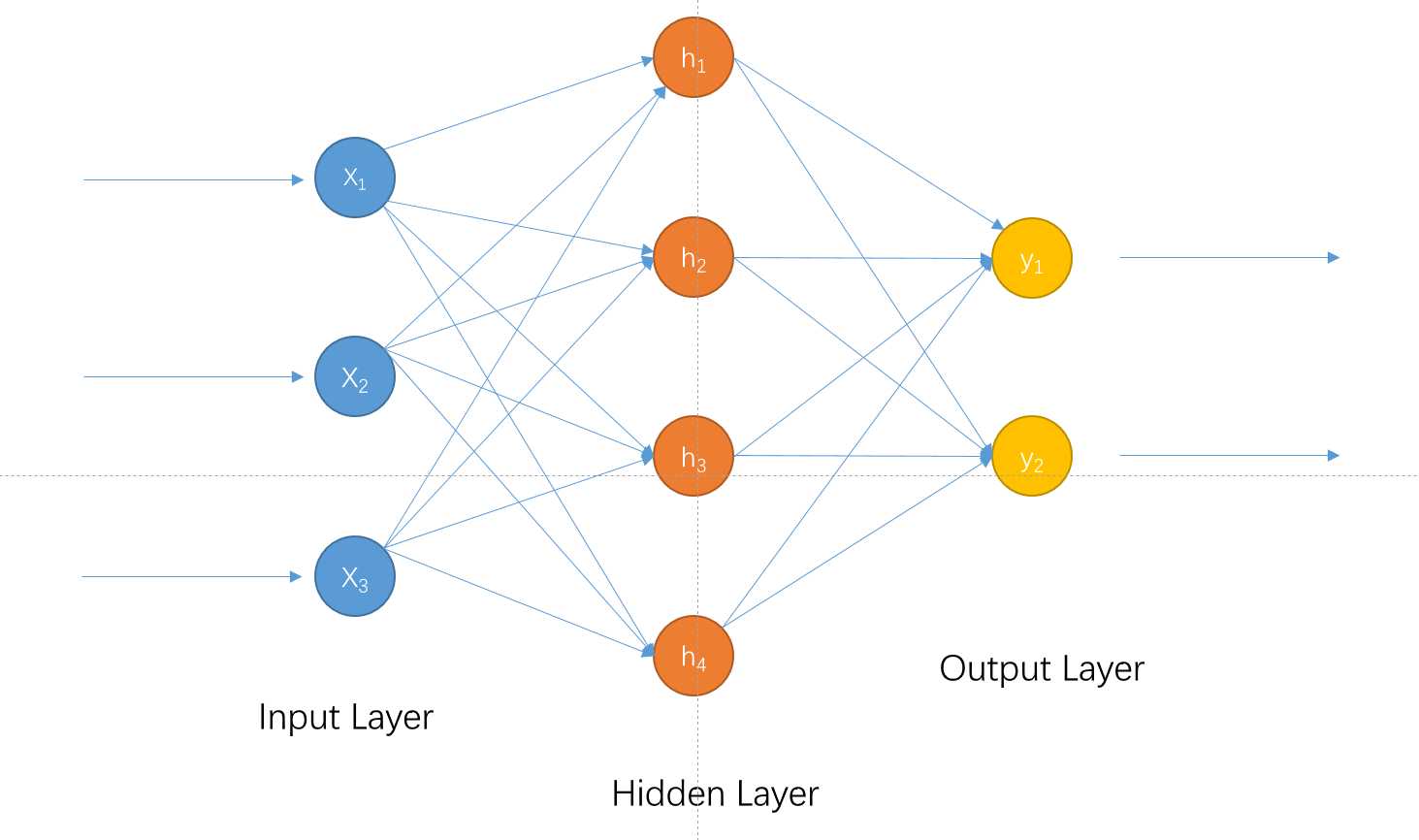

如图中所示我们规定\(W_{ij}^k\)表示第k层与第k+1层之间神经元的权重值,\(z^k\)表示对应输入第k层的值,\(o^k\)表示对应第k层输出的值

定义损失函数为:

比如图中第2层和第3层的误差分配如下:

我们可以发现:此处的权重矩阵就是前向传播的时候第2层所乘的矩阵的转置矩阵,也就是\((w^k)^T\)

引出记号:

则损失函数改写为:

暂时把\(\sum\)忽略可得:

又根据链式法则:

如果取激活函数为sigmoid函数可得其导函数为:

进一步改写得:

依次倒推回去即可

注:以上图的网络为例,\(z^{k+1}=o^kW^k\)对\(W^k\)来说\(o^k\)就是斜率

标签:反向 差分 oid 误差 .com art sum array 分享图片

原文地址:https://www.cnblogs.com/MartinLwx/p/9694060.html