标签:十分 通过 条件 reg 分类方法 spl 梯度 end ssi

全文引用自《统计学习方法》(李航)

本节介绍的对数线性模型,主要包括逻辑斯谛回归(logistic regression)模型以及最大熵模型(maximum entropy model)。逻辑斯谛回归模型是统计学中十分经典的分类方法,而最大熵是概率学习中的一个准则,通过推广到分类问题,可以得到最大熵模型。本文主要介绍逻辑斯谛回归模型,并在以后详细介绍最大熵模型以及对数线性模型的优化方法。

逻辑斯谛分布(logistic distribution)定义: 设X是连续的随机变量,则X服从逻辑斯谛分布是指其满足一下分布函数和密度函数:

\[

\begin{aligned}

F(x)=P(X\le x)=\frac{1}{1+e^{-(x-\mu)/\gamma}}\f(x)=F‘(x)=\frac{e^{-(x-\mu)/\gamma}}{\gamma(1+e^{-(x-\mu)/\gamma})^2}

\end{aligned}

\]

式中,\(\mu\)为位置参数,\(\gamma > 0\)为形状参数。

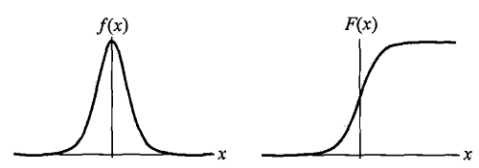

逻辑斯谛回归分布的密度函数和分布函数的形状如下图:

分布函数F(x)即逻辑斯谛函数,其图形是一条s形曲线,以\((\mu, \frac{1}{2})\)点为中心呈中心对称,即满足

\[

F(-x+\mu)-\frac{1}{2}=-F(x-\mu)+\frac{1}{2}

\]

形状参数\(\gamma\)越小,曲线在对称中心附近增长越快。

二项逻辑斯谛回归模型(binomial logistic regression model)是一种分类模型,由条件概率P(Y|X)表示,其形式为参数化的逻辑斯谛分布。其中,随机变量X为实数,随机变量Y取值0或1。则二项逻辑斯谛回归模型形式如下:

\[

\begin{aligned}

P(Y=1|x)=\frac{\exp(w\cdot x+b)}{1+\exp(w\cdot x+b)}\P(Y=0|x)=\frac{1}{1+\exp(w\cdot x+b)}

\end{aligned}

\]

其中,\(x\in R^n\)为模型输入实例,\(Y\in\{0,1\}\)为模型输出,\(w\in R^n.b\in R\)为参数,w称为权值向量,b称为偏置,\(w\cdot x\)为两者的内积。

对于给定的输入实例x,按照上式进行计算,可以得到P(Y=1|x)和P(Y=0|x),则逻辑回归模型比较两者的大小,将实例分为概率较大的一类。

通常为了计算方便,会将权值向量和输入向量扩展为\(w=(w^{(1)},w^{(2)},\cdots,w^{(n)},b)^T,x=(x^{(1)},x^{(2)},\cdots,x^{(n)},1)^T\),同时,逻辑斯谛回归模型的形式如下:

\[

\begin{aligned}

P(Y=1|x)=\frac{\exp(w\cdot x)}{1+\exp(w\cdot x)}\P(Y=0|x)=\frac{1}{1+\exp(w\cdot x)}

\end{aligned}

\]

定义一个事件的几率(odds)为该事件发生的概率和该事件不发生的概率之比,若一个事件发生的概率为p,那么该事件的几率为\(\frac{p}{1-p}\),则该事件的对数几率(log odds)或logit函数是:

\[

logit(p)=\log\frac{p}{1-p}

\]

则对于逻辑斯谛回归模型而言,Y=1的几率为:

\[

\log\frac{P(Y=1|x)}{1-P(Y=1|x)}=w\cdot x

\]

即,在逻辑斯谛回归模型中,输出Y=1的对数几率是输入x的线性函数,或输出Y=1的对数几率是由输入x的线性函数表示的模型此模型即为逻辑斯谛回归模型。

对于逻辑斯谛回归模型的学习流程,主要是对于给定的训练数据集\(T=\{(x_1,y_1),(x_2,y_2),\cdots,(x_N,y_N)\},x_i\in R^n,y_i\in\{0,1\}\),利用极大似然估计法来估计模型的参数,从而得到逻辑斯谛回归模型。

假设:\(P(Y=1|x)=\sigma(x),P(Y=0|x)=1-\sigma(x)\)

则似然函数为:

\[

\prod_{i=1}^N[\sigma(x_i)]^{y_i}[1-\sigma(x_i)]^{1-y_i}

\]

对数似然函数为:

\[

\begin{aligned}

L(w)&=\sum_{i=1}^N[y_i\log\sigma(x_i)+(1-y_i)\log(1-\sigma(x_i))]\&=\sum_{i=1}^N\left[y_i\log\frac{\sigma(x_i)}{1-\sigma(x_i)}+\log(1-\sigma(x_i))\right]\&=\sum_{i=1}^N[y_i(w\cdot x_i)-\log(1+\exp(w\cdot x_i))]

\end{aligned}

\]

此时,对L(w)求最大值,即得到w的估计值。

因此,模型的学习问题就变成了以对数似然函数为目标函数的最优化问题。通常采用梯度下降法或拟牛顿法来求取最优值。

假定w的极大似然估计值为\(\hat{w}\),则学习到的逻辑斯谛回归模型为:

\[

\begin{aligned}

P(Y=1|x)=\frac{\exp(\hat{w}\cdot x)}{1+\exp(\hat{w}\cdot x)}\P(Y=0|x)=\frac{1}{1+\exp(\hat{w}\cdot x)}

\end{aligned}

\]

针对多分类问题,可以将二项分类的逻辑斯谛回归模型进行推广,称为多项逻辑斯谛回归模型。

假定离散型随机变量Y的取值集合为\(\{1,2,\cdots,K\}\),那么多项逻辑斯谛回归模型为:

\[

\begin{aligned}

P(Y=k|x)=\frac{\exp(w_k\cdot x)}{1+\sum_{k=1}^{K-1}\exp(w_k\cdot x)},k=1,2,\cdots,K-1\P(Y=K|x)=\frac{1}{1+\sum_{k=1}^{K-1}\exp(w_k\cdot x)}

\end{aligned}

\]

其中\(x\in R^{n+1},w_k\in R^{n+1}\)。

而二项逻辑斯谛回归模型的参数估计方法,也可以推广到多项逻辑斯谛回归模型中。

标签:十分 通过 条件 reg 分类方法 spl 梯度 end ssi

原文地址:https://www.cnblogs.com/zhiyuxuan/p/9702978.html