标签:插件 pom 默认 关于 远程 文本 词语 font span

一、IK简介

ElasticSearch(以下简称ES)默认的分词器是标准分词器Standard,如果直接使用在处理中文内容的搜索时,中文词语被分成了一个一个的汉字,因此引入中文分词器IK就能解决这个问题,同时用户可以配置自己的扩展字典、远程扩展字典等。

二、IK安装

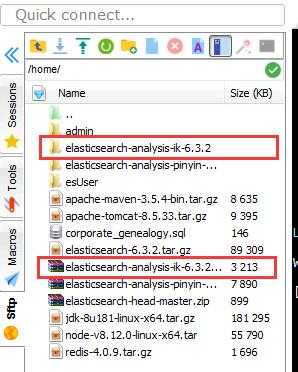

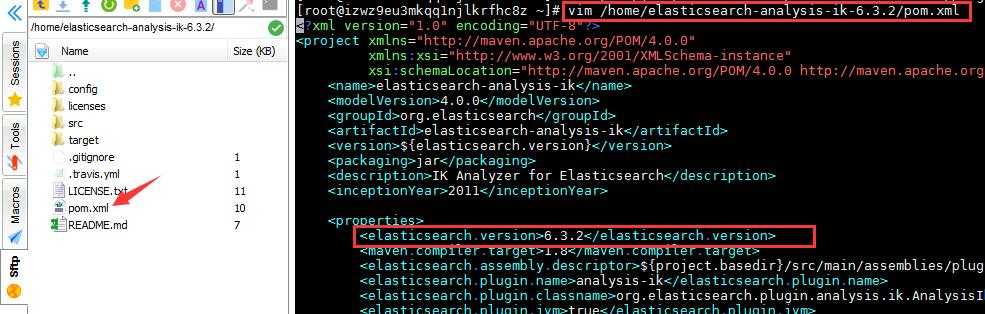

1、首先前往GitHub下载安装包(注意版本与ES对应,若无对应版本,解压后修改pom.xml文件中<elasticsearch.version>,建议查看修改一下版本号),上传至/home/目录,并解压至当前目录,如下图所示:

1 vim /home/elasticsearch-analysis-ik-6.3.2/pom.xml

2、然后切换至解压目录进行编译(若无安装Maven工具,首先安装Maven才能编译,具体参考Linux安装Maven):

1 [root@izwz9eu3mkqq1njlkrfhc8z elasticsearch-analysis-ik-6.3.2]# mvn package

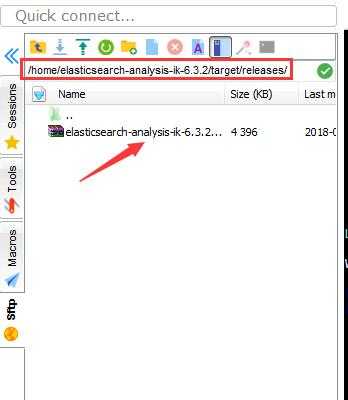

编译之后,会在当前目录下的target/releases找到对应的zip包,如下图所示:

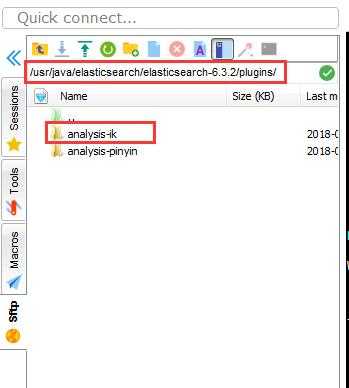

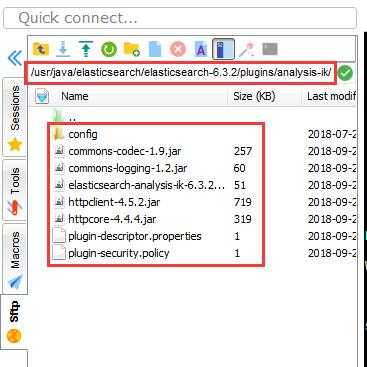

3、然后在/usr/java/elasticsearch/elasticsearch-6.3.2/plugins/目录下创建analysis-ik,再将上述中的zip包解压至该目录,如下图所示:

1 [root@izwz9eu3mkqq1njlkrfhc8z elasticsearch-analysis-ik-6.3.2]# unzip /home/elasticsearch-analysis-ik-6.3.2/target/releases/elasticsearch-analysis-ik-6.3.2.zip -d /usr/java/elasticsearch/elasticsearch-6.3.2/plugins/analysis-ik/

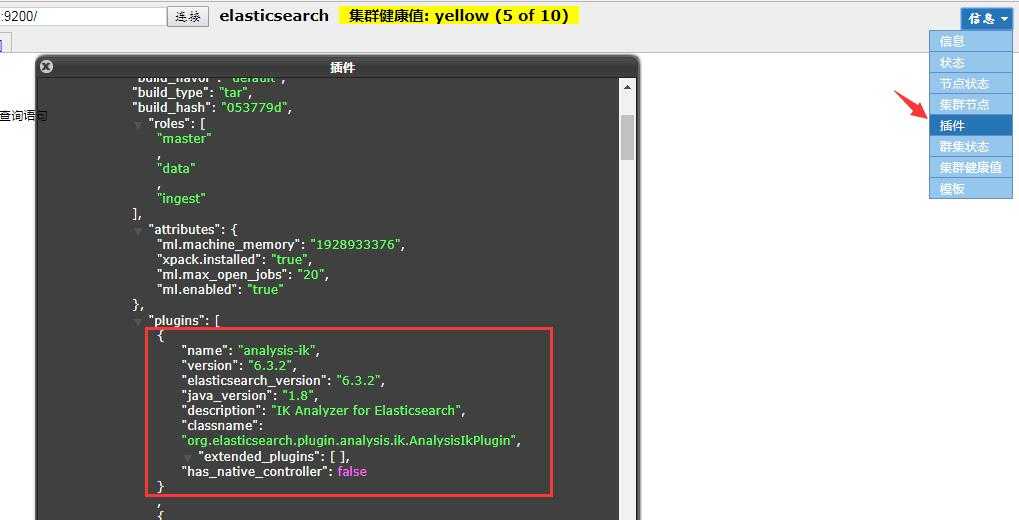

4、切换至非root用户,重新启动ES即可,并且可在Head插件中查看插件信息,如下图所示:

三、IK测试

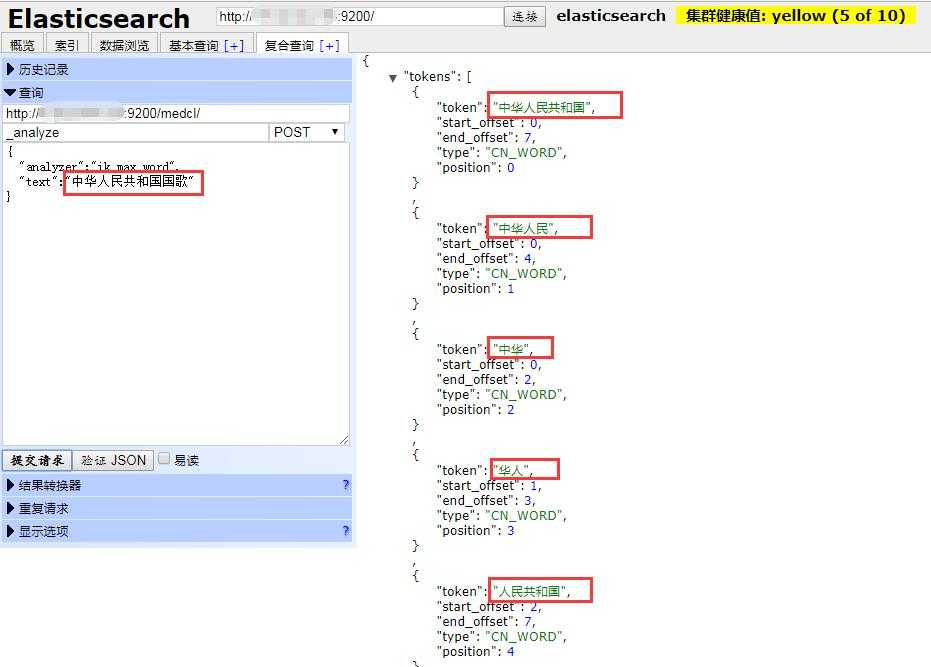

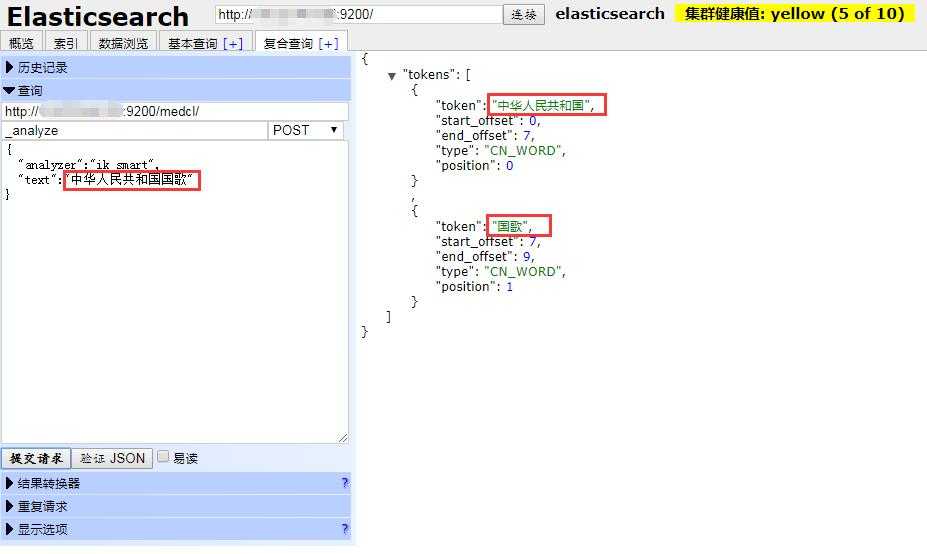

IK分词器的两种分词模式:

ik_max_word: 会将文本做最细粒度的拆分,

ik_smart: 会做最粗粒度的拆分。

这里使用_analyze api对中文段落进行分词,如下图所示:

至此是关于介绍在Linux系统中ElasticSearch搜索引擎安装配置中文分词器IK插件,后续会介绍ElasticSearch拼音插件pinyin。

如有疏漏错误之处,还请不吝赐教!

ElasticSearch搜索引擎安装配置中文分词器IK插件

标签:插件 pom 默认 关于 远程 文本 词语 font span

原文地址:https://www.cnblogs.com/yijialong/p/9717593.html