标签:kpi bin dal star 进入 需要 spark BMI submit

local模式也就是本地模式,也就是在本地机器上单机执行程序。使用这个模式的话,并不需要启动Hadoop集群,也不需要启动Spark集群,只要有一台机器上安装了JDK、Scala、Spark即可运行。

进入到Spark2.1.1的安装目录,命令是:

cd /opt/spark/spark-2.1.1-bin-hadoop2.7

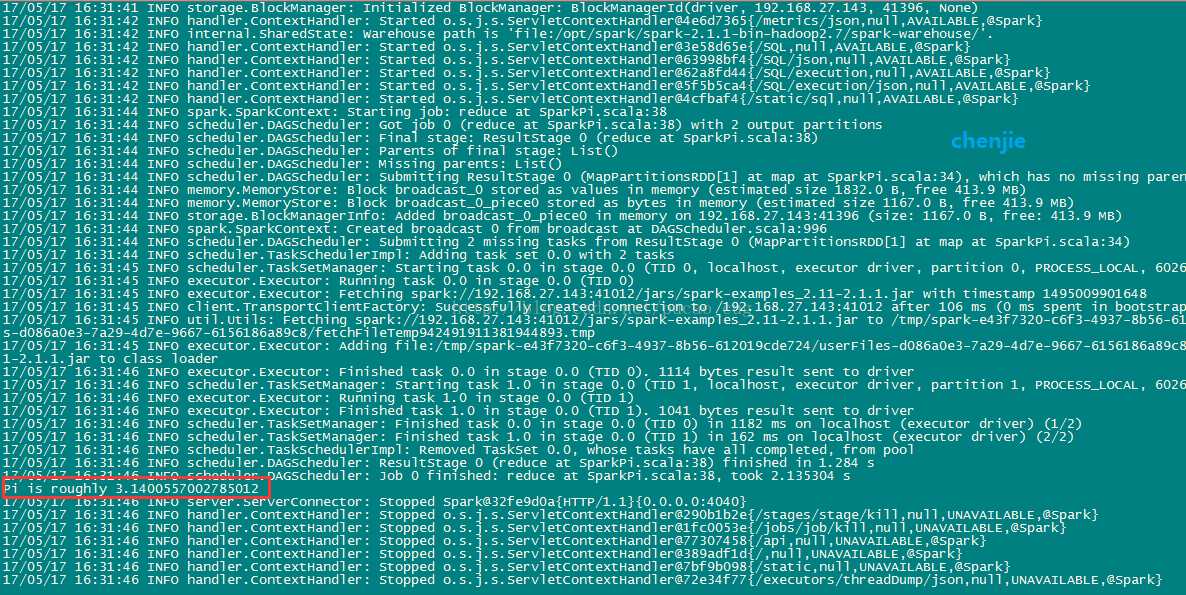

执行命令,用单机模式运行计算圆周率的Demo:

./bin/spark-submit --class org.apache.spark.examples.SparkPi --master local examples/jars/spark-examples_2.11-2.1.1.jar

如图:

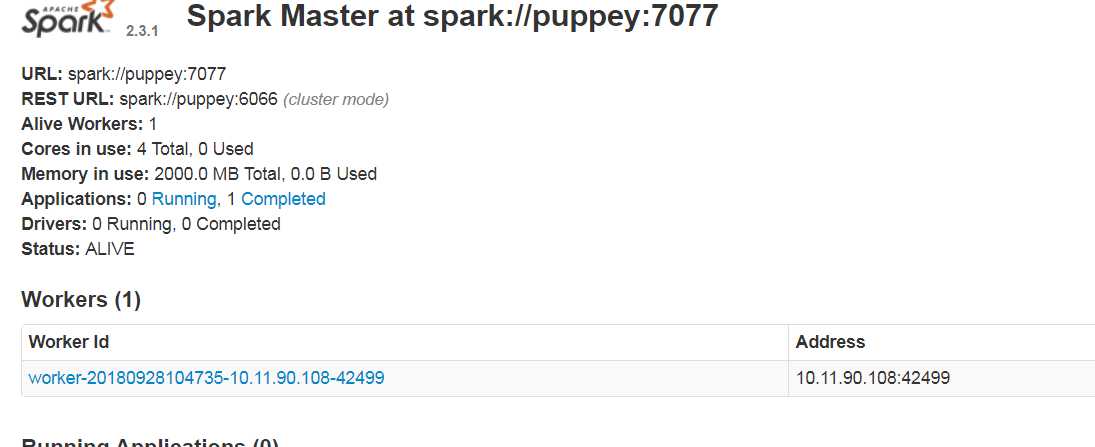

这种模式也就是Standalone模式,使用独立的Spark集群模式提交任务,需要先启动Spark集群,但是不需要启动Hadoop集群。启动Spark集群的方法是进入$SPARK_HOME/sbin目录下,执行start-all.sh脚本,启动成功后,可以访问下面的地址看是否成功:

http://Spark的Marster机器的IP:8080/

如图:

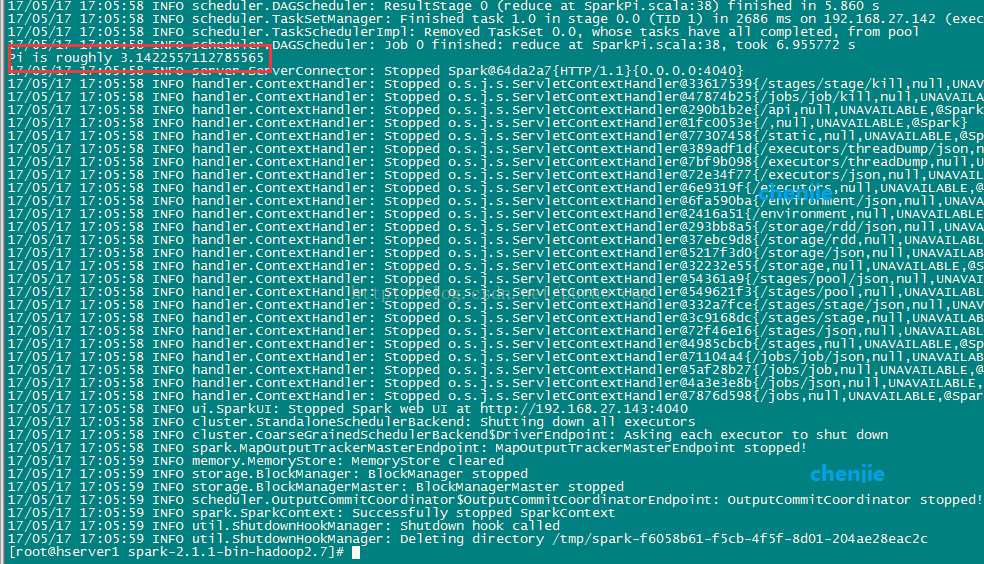

执行命令,用Standalone模式运行计算圆周率的Demo:

./bin/spark-submit --class org.apache.spark.examples.SparkPi --master spark://192.168.27.143:7077 examples/jars/spark-examples_2.11-2.1.1.jar

如图:

标签:kpi bin dal star 进入 需要 spark BMI submit

原文地址:https://www.cnblogs.com/puppey/p/9718592.html