标签:一个 分类 结果 cal 多少 总结 res header 技术

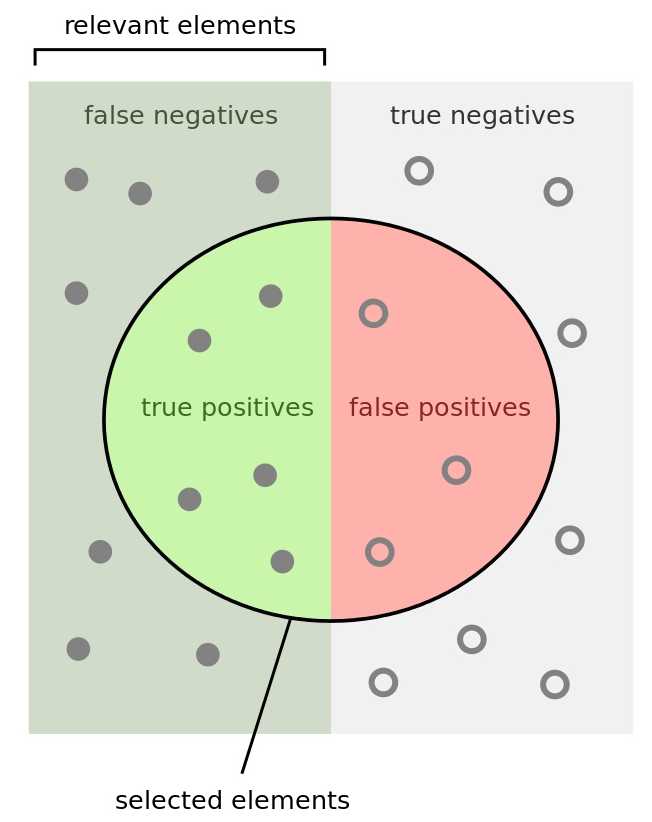

首先我们先来看一组机器学习评价标准中中常见概念, 总结如下表

| 术语 | 缩写 | 含义 |

|---|---|---|

| True Positive | TP | 被模型预测为正的正样本 |

| True Negative | TN | 被模型预测为负的负样本 |

| False Negative | FN | 被模型预测为负的正样本 |

| False Positive | FP | 被模型预测为正的负样本 |

上述定义解读如下

在理解一个组合的含义时, 先看第二个关键字含义, 然后再看第一个关键字含义

如: True Negative

即该样本为被模型预测为负的负样本

?

?

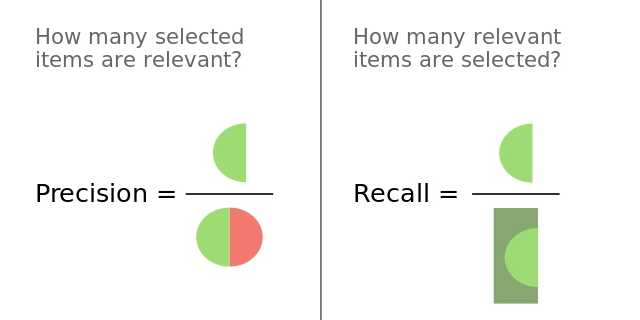

精确率(Precision)是针对预测结果而言的,它表示的是预测为正的样本中有多少是真正的正样本。那么预测为正就有两种可能了,一种就是把正类预测为正类(TP),另一种就是把负类预测为正类(FP),也就是

\[ \begin{align} \bf Precision = \frac{TP}{TP+FN} \tag{1}\\end{align} \]

召回率(Recall)是针对原来的样本而言的,它表示的是样本中的正例有多少被预测正确了。那也有两种可能,一种是把原来的正类预测成正类(TP),另一种就是把原来的正类预测为负类(FN)。

\[ \begin{align} \bf Recall = \frac{TP}{TP+FP} \tag{2} \end{align} \]

?

?

F-measure 是一种统计量,F-Measure 又称为 F-Score,F-Measure 是 Precision 和 Recall 加权调和平均,是IR(信息检索)领域的常用的一个评价标准,常用于评价分类模型的好坏. F-measure 综合了 Presion 和 Recall 的结果,当 F-measure 较高时则能说明试验方法比较有效。 F1-Measure 定义如下

\[{\displaystyle F_{1}=\left({\frac {\mathrm {recall} ^{-1}+\mathrm {precision} ^{-1}}{2}}\right)^{-1}=2\cdot {\frac {\mathrm {precision} \cdot \mathrm {recall} }{\mathrm {precision} +\mathrm {recall} }}}\]

在 F-measure 的通用定义如下,

\[ F_\beta = (1 + \beta^2) \cdot \frac{\mathrm{precision} \cdot \mathrm{recall}}{(\beta^2 \cdot \mathrm{precision}) + \mathrm{recall}} \]

将式(1)和式(2)代入上式

\[{\displaystyle F_{\beta }={\frac {(1+\beta ^{2})\cdot \mathrm {true\ positive} }{(1+\beta ^{2})\cdot \mathrm {true\ positive} +\beta ^{2}\cdot \mathrm {false\ negative} +\mathrm {false\ positive} }}\,} \]

使用 β的平方, 只是为了说明 Presion 上的因子大于 0

?

标签:一个 分类 结果 cal 多少 总结 res header 技术

原文地址:https://www.cnblogs.com/nowgood/p/APdefinite.html