标签:arc loss 识别 概率 分数 原来 sub 全连接 png

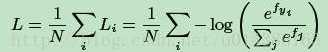

softmax loss:

N是样本的数量,i代表第i个样本,j代表第j个类别,fyi代表着第i个样本所属的类别的分数

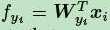

fyi是全连接层的输出,代表着每一个类别的分数,

每一个分数即为权重W和特征向量X的内积

每一个分数即为权重W和特征向量X的内积

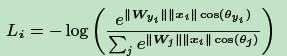

每个样本的softmax值即为:

L-softmax loss:

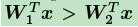

假设一个2分类问题,x属于类别1,那么原来的softmax肯定是希望:

也就是属于类别1的概率大于类别2的概率,这个式子和下式是等效的:

标签:arc loss 识别 概率 分数 原来 sub 全连接 png

原文地址:https://www.cnblogs.com/k7k8k91/p/9777148.html