标签:也会 批量 默认 时间 批量提交 append mit 服务 顺序

kafka是一个分布式的、分区化、可复制提交的发布订阅消息系统

传统的消息传递方法包括两种:

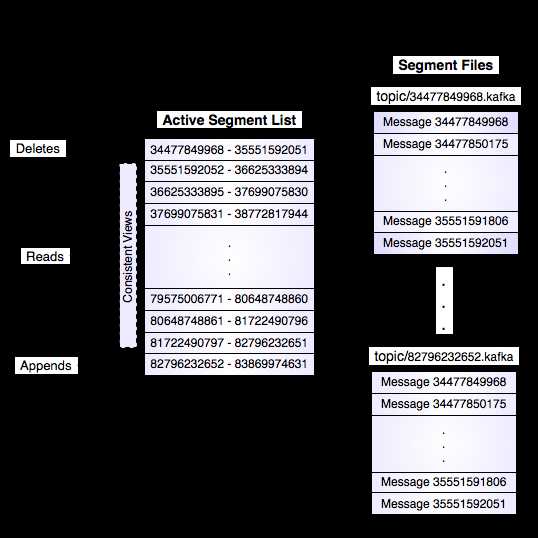

日志是一个只能增加的,完全按照时间排序的一系列记录。我们可以给日志的末尾添加记录,并且可以从左到右读取日志记录。每一条记录都指定了一个唯一的有一定顺序的日志记录编号。

每个日志文件都是“log entries”序列,每一个log entry包含一个4字节整型数(值为N),其后跟N个字节的消息体。每条消息都有一个当前partition下唯一的64字节的offset,它指明了这条消息的起始位置

这个“log entries”并非由一个文件构成,而是分成多个segment,每个segment名为该segment第一条消息的offset和“.kafka”组成。另外会有一个索引文件,它标明了每个segment下包含的log entry的offset范围。

谈到kafka的存储,就不得不提到分区。

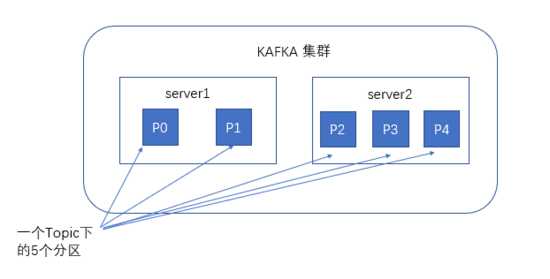

创建一个topic时,同时可以指定分区数目,分区数越多,其吞吐量也越大,但是需要的资源也越多,同时也会导致更高的不可用性,kafka在接收到生产者发送的消息之后,会根据均衡策略将消息存储到不同的分区中。

为了使得Kafka的吞吐率可以水平扩展,物理上把topic分成一个或多个partition,每个partition在物理上对应一个文件夹,该文件夹下存储这个partition的所有消息和索引文件。

消息以顺序存储:每一个分区都是一个顺序的、不可变的消息队列, 并且可以持续的添加,,最晚接收的的消息会最后被消费。

分区中的消息都被分配了一个序列号,称之为偏移量(64字节的offset),在每个分区中此偏移量都是唯一的。

因为每条消息都被append到该partition中,是顺序写磁盘,因此效率非常高(经验证,顺序写磁盘效率比随机写内存还要高,这是Kafka高吞吐率的一个很重要的保证)

生产者在向kafka集群发送消息的时候,可以通过指定分区来发送到指定的分区中

也可以通过指定均衡策略来将消息发送到不同的分区中

如果不指定,就会采用默认的随机均衡策略,将消息随机的存储到不同的分区中

每一条消息被发送到broker时,会根据paritition规则选择被存储到哪一个partition。

如果partition规则设置的合理,所有消息可以均匀分布到不同的partition里,这样就实现了水平扩展。(如果一个topic对应一个文件,那这个文件所在的机器I/O将会成为这个topic的性能瓶颈,而partition解决了这个问题)。

在发送一条消息时,可以指定这条消息的key,producer根据这个key和partition机制来判断将这条消息发送到哪个parition。

paritition机制可以通过指定producer的paritition. class这一参数来指定,该class必须实现kafka.producer.Partitioner接口。

本例中如果key可以被解析为整数则将对应的整数与partition总数取余,该消息会被发送到该数对应的partition。(每个parition都会有个序号)

在消费者消费消息时,kafka使用offset来记录当前消费的位置

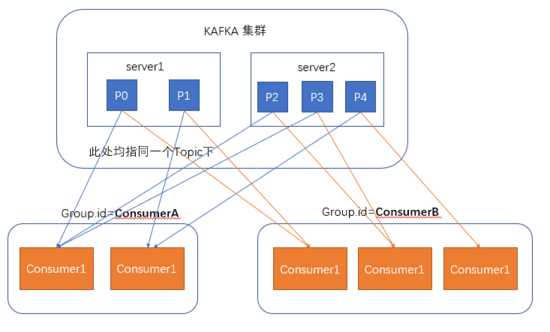

在kafka的设计中,可以有多个不同的group来同时消费同一个topic下的消息,

两个不同的group同时消费,他们的的消费的记录位置offset各不项目,不互相干扰。

对于一个group而言,消费者的数量不应该多余分区的数量,

因为每个分区至多只能自动发送消息到一个group中的一个消费者上,即一个消费者可以消费多个分区,一个分区只能给同一个组的一个消费者消费。

因此,若一个group中的消费者数量大于分区数量的话,多余的消费者将不会收到任何消息。

自动提交是在kafka拉取到数据完就直接提交数据偏移量。

而业务系统中,消费数据还伴随着一些逻辑业务处理,插入数据库等。

这事务过程,需要完成才提交。不然还没插进数据库,新的数据又来了。

加入插入数据库还失败了,就没法再消费一次失败的数据了。

所以要严格的不丢数据,需要手动控制offest。

官网还说:

手动控制offest让我们能精确控制消息被消费(能实现 提交了offest的不再消费,没提交过offest的数据会再次消费)。

但这一过程可能在 数据插入数据库后,但是还没commit offset到kafka时 失败了。

那么下一次消费将还是从上次消费的起点取到数据,会重复插入数据库。

kafka提供的是 "at-least once delivery" 保证, 每个消息会被传递至少一次,然而在失败的时候会造成重复。

标签:也会 批量 默认 时间 批量提交 append mit 服务 顺序

原文地址:https://www.cnblogs.com/stillcoolme/p/9780964.html