标签:proc 激活 scm hive test class content htm for

其实cloudera已经做了这个事了,只是把kafka的包和cdh的parcel包分离了,只要我们把分离开的kafka的服务描述jar包和服务parcel包下载了,就可以实现完美集成了。

具体实现的简要步骤可参照cloudera官网提供的文档:http://www.cloudera.com/content/www/en-us/documentation/kafka/latest/topics/kafka_installing.html,

下面就是我根据这个文档的集成过程。

kafka相关包准备csd包:http://archive.cloudera.com/csds/kafka/

parcel包: http://archive.cloudera.com/kafka/parcels/latest/ ( 根据自己的集群的系统版本下载 )

我用的是centos6.5 x64的系统,所以我下载的parcel包为KAFKA-0.8.2.0-1.kafka1.3.2.p0.56-el6.parcel与KAFKA-0.8.2.0-1.kafka1.3.2.p0.56-el6.parcel.sha1

集成实现关闭集群,关闭cm服务( 假如不关闭cm服务,会出现在添加kafka服务时找不到相关的服务描述 )

将csd包放到cm安装节点下的 /opt/cloudera/csd目录下,如图 :

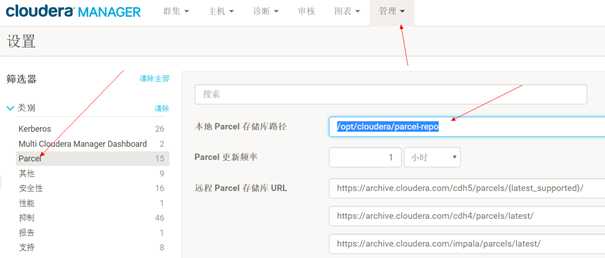

1.下载 KAFKA 和SPARK2的 Parcel 包(可以从 TD CDH 包里拿到) 并放置到 Cloudera Manager 的 parcel 仓库目录下 (登录 CM 控制台 设置 Parcel配置)

2.对于前面重名的文件可以采取手动改名的形式, 例如 mainifest.json 可以备份以前的json 文件并改名,

3.重启 cloudera server 和 agent 服务

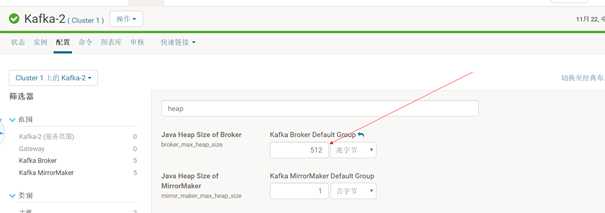

4.安装Kafka过程中如果启动失败 需要更改 默认的 Java Heap Size (默认50 M) 改成 512 即可

5.为客流运营平台单独安装 Kafka (需要先安装第二个Zookeeper集群 客源专用)

6.然后重新启动 Kafka 服务,并检查其状态 。

标签:proc 激活 scm hive test class content htm for

原文地址:https://www.cnblogs.com/fanshudada/p/9842354.html