标签:width 公式 个数 基本 基于 数据 class 常用 方式

---恢复内容开始---

在机器学习中,有时候我们基于一个数据集训练的模型对该模型的正确率非常高,而该模型对没有见过的数据集很难做出正确的响应;那么这个模型就存在过拟合现象。

为了缓解或避免过拟合现象,我们通常用的方法是采用正则化方法(Regularization)。

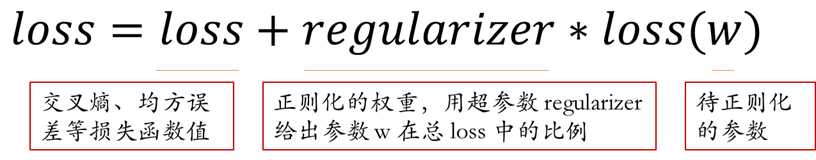

正则化在损失函数中引入模型复杂度指标,利用给W加权值,弱化了训练数据的噪声(注:一般不正则化 b,仅正则化 w )

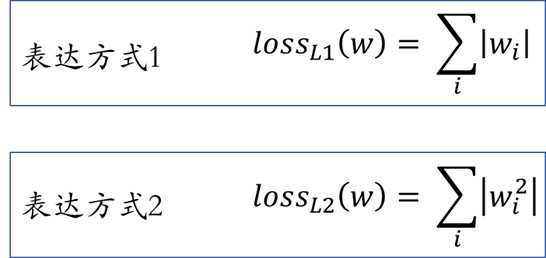

# 表达方式1 loss(w) = tf.contrib.l1_regularizer(regularizer)(w) # 表达方式2 loss(w) = tf.contrib.l2_regularizer(regularizer)(w)

其对应的数学表达式为

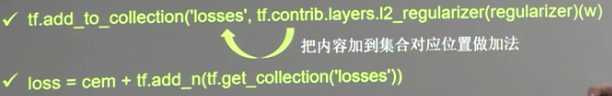

将正则化计算好的 w 添加到 losses 中

---恢复内容结束---

标签:width 公式 个数 基本 基于 数据 class 常用 方式

原文地址:https://www.cnblogs.com/gengyi/p/9901749.html