标签:zhang 测试 nbsp ble target 目录 partition val image

使用hive储存数据时,需要对做分区,如果从kafka接收数据,将每天的数据保存一个分区(按天分区),保存分区时需要根据某个字段做动态分区,而不是傻傻的将数据写到某一个临时目录最后倒入到某一个分区,这是静态分区。

Hive动态分区步骤如下:

1、建立某一个源表模拟数据源并插入一些数据

create table t_test_p_source ( id string, name string, birthday string ) row format delimited fields terminated by ‘\t‘ stored as textfile; insert into t_test_p_source values (‘a1‘, ‘zhangsan‘, ‘2018-01-01‘); insert into t_test_p_source values (‘a2‘, ‘lisi‘, ‘2018-01-02‘); insert into t_test_p_source values (‘a3‘, ‘zhangsan‘, ‘2018-01-03‘); insert into t_test_p_source values (‘a4‘, ‘wangwu‘, ‘2018-01-04‘); insert into t_test_p_source values (‘a5‘, ‘sanzang‘, ‘2018-01-05‘); insert into t_test_p_source values (‘a6‘, ‘zhangsan2‘, ‘2018-01-01‘);

2、建立一张分区表 (按ds字段分区)

create table t_test_p_target ( id string, name string ) partitioned by (ds string) row format delimited fields terminated by ‘\t‘ stored as textfile;

3、向分区表中插入数据

SET hive.exec.dynamic.partition=true; #是否开启动态分区,默认是false,所以必须要设置成true SET hive.exec.dynamic.partition.mode=nonstrict; # 动态分区模式,默认为strict, 表示表中必须一个分区为静态分区,nostrict表示允许所有字段都可以作为动态分区 insert into table t_test_p_target partition (ds) select id, name, birthday as ds from t_test_p_source;

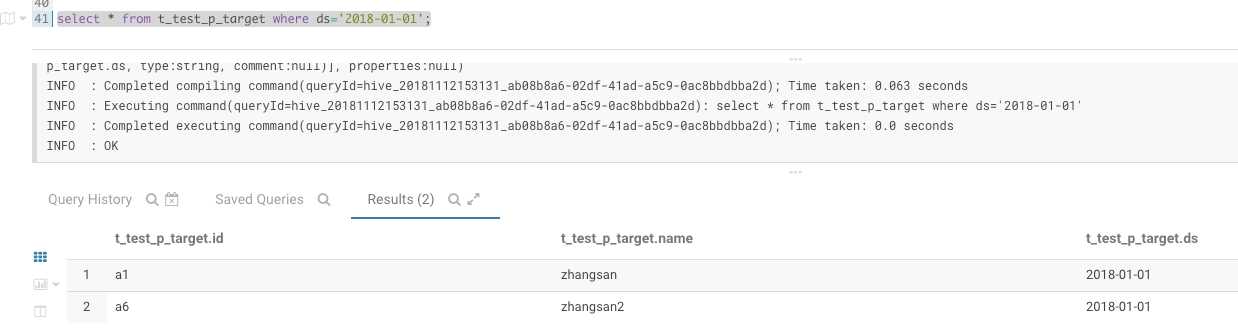

4、测试是否动态分区了

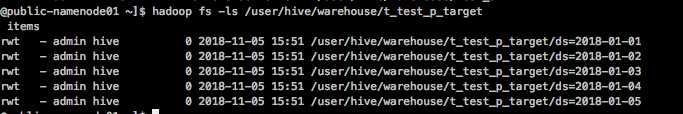

2018-01-01这个分区只有2条数据,再来看下HDFS上的分区目录

至此,hive动态分区已经完成了。

标签:zhang 测试 nbsp ble target 目录 partition val image

原文地址:https://www.cnblogs.com/jsnr-tdyd/p/9946788.html